2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Support Vector Machine (SVM) ist ein effizienter überwachter Lernalgorithmus, der häufig bei Klassifizierungs- und Regressionsproblemen eingesetzt wird. Es unterscheidet verschiedene Kategorien von Datenpunkten, indem es eine optimale Hyperebene im Merkmalsraum findet. Ziel ist es, das Intervall zwischen zwei Arten von Datenpunkten zu maximieren und dadurch die Generalisierungsfähigkeit des Modells zu verbessern. Zu den Schlüsselkonzepten von SVM gehören Hyperebenen, Intervalle, Unterstützungsvektoren und Kernelfunktionen. Die Kernelfunktion ermöglicht es SVM, nichtlineare Probleme zu behandeln und linear trennbare Hyperebenen zu finden, indem Daten einem höherdimensionalen Raum zugeordnet werden. Darüber hinaus werden Soft-Margin- und Regularisierungstechniken verwendet, um mit der unvollständigen linearen Trennbarkeit der Daten umzugehen und gleichzeitig die Komplexität des Modells zu kontrollieren und eine Überanpassung zu verhindern. Die Implementierung von SVM umfasst die Auswahl einer geeigneten Kernelfunktion, die Erstellung und Lösung eines konvexen quadratischen Programmierproblems sowie die Bewertung und Anwendung des trainierten Modells. Seine Vorteile bestehen darin, dass das Modell einfach und leicht zu implementieren ist und über eine gute Verallgemeinerungsfähigkeit verfügt. Es weist jedoch eine hohe Rechenkomplexität auf, reagiert empfindlich auf die Kernelfunktion und die Parameterauswahl und kann bei der Verarbeitung großer Datensätze auf Leistungsengpässe stoßen.

🏘️🏘️个人主页:Berge und Flüsse als Geschenk nutzen。

🎖️🎖️:Rising Star Creator im Python-Bereich, CSDN Rising Star-Zertifizierung, CSDN Content Partner, Alibaba Cloud Community Expert Blogger, Rising Star Program Mentor und Datenanalyst am Arbeitsplatz.

💕💕悲索之人烈焰加身,堕落者不可饶恕。永恒燃烧的羽翼,带我脱离凡间的沉沦。

| Typ | Spalte |

|---|---|

| Python-Grundlagen | Einführung in die Python-Grundlagen – ausführliche Version |

| Python für Fortgeschrittene | Einführung in die Python-Grundlagen – Modul-Edition |

| Python für Fortgeschrittene | Python网络爬虫从入门到精通🔥🔥🔥 |

| Web-Full-Stack-Entwicklung | Erste Schritte mit Django-Grundlagen |

| Web-Full-Stack-Entwicklung | Einführung in die HTML- und CSS-Grundlagen |

| Web-Full-Stack-Entwicklung | Erste Schritte mit JavaScript-Grundlagen |

| Python-Datenanalyse | Python数据分析项目🔥🔥 |

| maschinelles Lernen | 机器学习算法🔥🔥 |

| KI | KI |

Support Vector Machine (SVM) ist ein leistungsstarker Algorithmus für maschinelles Lernen, der hauptsächlich zur Lösung von Klassifizierungs- und Regressionsproblemen verwendet wird. Es basiert auf dem Prinzip der strukturellen Risikominimierung in der statistischen Lerntheorie und unterscheidet verschiedene Datenkategorien, indem es eine optimale Entscheidungsgrenze, also eine Hyperebene, im Merkmalsraum findet. Die Wahl dieser Hyperebene zielt darauf ab, den kürzesten Abstand von den Datenpunkten zur Hyperebene zu maximieren, der als Rand bezeichnet wird. Je größer das Intervall, desto besser ist in der Regel die Generalisierungsfähigkeit des Modells.

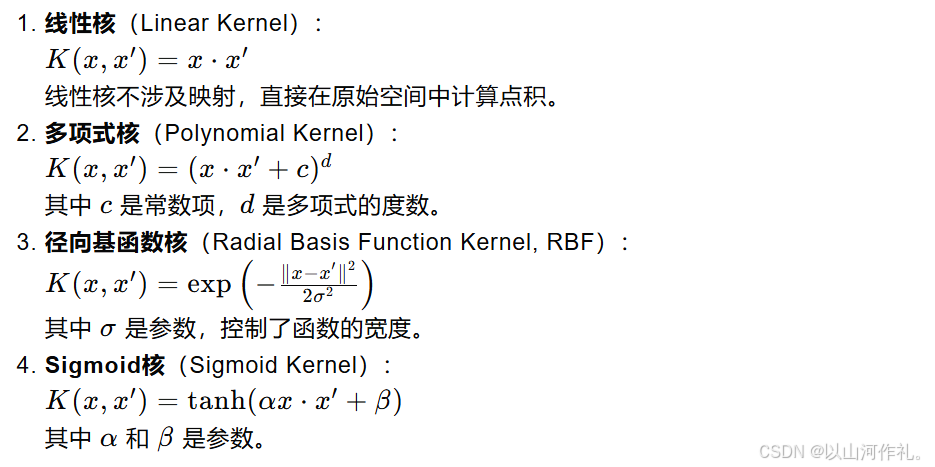

Der Kern von SVM ist der Unterstützungsvektor, ein Satz von Datenpunkten, die für die Bestimmung der Position und Richtung der Hyperebene von entscheidender Bedeutung sind. Dies sind die Punkte, die der Hyperebene am nächsten liegen. Wenn die Daten nicht linear trennbar sind, ordnet SVM die Originaldaten durch Einführung einer Kernelfunktion einem höherdimensionalen Raum zu und findet in diesem neuen Raum eine linear trennbare Hyperebene. Zu den häufig verwendeten Kernelfunktionen gehören lineare Kernel, Polynomkernel, Radialbasisfunktionskerne (RBF) usw.

Um mit Rauschen und Ausreißern in den Daten umzugehen, führt SVM das Konzept des Soft Margin ein, das die Fehlklassifizierung einiger Datenpunkte im Austausch für eine bessere Generalisierungsleistung ermöglicht. Gleichzeitig wird die Komplexität des Modells durch Regularisierungsterme kontrolliert, um eine Überanpassung zu vermeiden. Der Trainingsprozess von SVM umfasst normalerweise die Lösung eines konvexen quadratischen Programmierproblems, um die optimalen Hyperebenenparameter zu finden.

Siehe die Abbildung unten. In einer zweidimensionalen Umgebung können die Punkte R, S, G und andere Punkte in der Nähe der mittleren schwarzen Linie als Unterstützungsvektoren betrachtet werden. Sie können die spezifischen Parameter des Klassifikators bestimmen Linie.

Unterstützungsvektoren und Hyperebenen sind Kernkonzepte im SVM-Algorithmus (Support Vector Machine). Im Folgenden werde ich diese beiden Konzepte im Detail erläutern:

In der Mathematik ist eine Hyperebene ein linearer Unterraum, der eine Dimension niedriger ist als der Raum, in dem er sich befindet. Beispielsweise ist eine Hyperebene im zweidimensionalen Raum eine gerade Linie; im dreidimensionalen Raum ist sie immer noch eine lineare Grenze, aber es kann schwierig sein, sie intuitiv zu verstehen.

In SVM wird Hyperebene verwendet, um Daten in verschiedene Kategorien zu klassifizieren. Für einen zweidimensionalen Raum können Sie sich eine Hyperebene als eine gerade Linie vorstellen, die den Raum in zwei Teile teilt, wobei jeder Teil eine Kategorie von Datenpunkten enthält. Für höherdimensionale Räume ist eine Hyperebene eine höherdimensionale lineare Grenze, die auch Datenpunkte trennt.

Unterstützungsvektoren sind die Datenpunkte, die der Hyperebene am nächsten liegen. Sie sind die wichtigsten Datenpunkte, die SVM während des Trainings verwendet, um die Position der Hyperebene zu bestimmen. Wenn Sie einen dieser Punkte entfernen, ändert sich die Position und Ausrichtung der Hyperebene.

Unterstützungsvektoren sind wichtig, da sie die Grenzen (d. h. Intervalle) zwischen Datenpunkten definieren. Das Ziel von SVM besteht darin, eine Hyperebene zu finden, die den Abstand (Intervall) zwischen den nächstgelegenen Unterstützungsvektoren (d. h. den Datenpunkten, die der Hyperebene am nächsten liegen) und der Hyperebene maximiert. Die Größe dieses Intervalls ist ein wichtiger Indikator für die Generalisierungsfähigkeit des Modells.

In realen Anwendungen sind die Daten möglicherweise nicht linear trennbar. Zu diesem Zeitpunkt kann SVM Kernel-Techniken verwenden, um nichtlineare Probleme zu lösen. Die Kernelfunktion kann die Originaldaten einem höherdimensionalen Raum zuordnen und im neuen Raum eine linear trennbare Hyperebene finden. Zu den häufig verwendeten Kernelfunktionen gehören lineare Kernel, Polynomkernel, Radialbasisfunktionskerne (RBF) usw.

Beim Umgang mit realen Daten ist es möglicherweise nicht möglich, eine perfekte Hyperebene zu finden, die alle Datenpunkte vollständig trennt. Zu diesem Zeitpunkt führte SVM das Konzept des Soft Margin ein, das die Fehlklassifizierung einiger Datenpunkte im Austausch für bessere Generalisierungsfähigkeiten ermöglichte. Gleichzeitig wird die Komplexität des Modells durch den Regularisierungsterm (normalerweise die Norm des Normalenvektors) gesteuert, um eine Überanpassung zu vermeiden.

Die Punkt-zu-Hyperebene-Abstandsformel wird verwendet, um den kürzesten Abstand von einem Punkt zu einer bestimmten Hyperebene zu berechnen. Die Hyperebene kann durch die folgende Gleichung im n-dimensionalen Raum ausgedrückt werden:

In:

w ist ein n-dimensionaler Normalenvektor senkrecht zur Hyperebene.

x ist ein n-dimensionaler Punkt im Raum.

b ist der Bias-Term der Hyperebene.

Der vertikale Abstand d vom Punkt x zu dieser Hyperebene kann mit der folgenden Formel berechnet werden:

这个公式的几何意义是:从点 𝑥 向超平面作垂线,垂足到点 𝑥的距离就是𝑑这个距离也代表了点 𝑥到超平面的“间隔”。在支持向量机中,间隔的大小是非常重要的,因为它与模型的泛化能力有关。SVM的目标是找到这样一个超平面,使得间隔最大化,即所有数据点到这个超平面的距离之和最大。

Optimierungsmodell im linear trennbaren Fall

Wenn die Daten linear trennbar sind, also eine Hyperebene vorhanden ist, die verschiedene Kategorien von Datenpunkten perfekt trennen kann, besteht das Ziel von SVM darin, eine Hyperebene zu finden, bei der die beiden nächstgelegenen Datenpunkte (d. h. Unterstützungsvektoren) zur Hyperebene liegen Distanz maximieren. Dieser Abstand wird Marge genannt.

Die Hyperebene kann ausgedrückt werden als:

Problem der maximalen Margenoptimierung

Die Zielfunktion von SVM besteht darin, das Intervall zu maximieren, was ausgedrückt werden kann als:

Einführung von Lagrange-Multiplikatoren

Einführung von Lagrange-Multiplikatoren

Doppelproblem

In Support-Vektor-Maschinen (SVM) sind Slack-Variablen (Slack-Variablen) ein eingeführter Mechanismus, um mit nichtlinearen trennbaren Situationen in Datensätzen umzugehen. Im Idealfall, wenn die Daten linear trennbar sind, kann SVM eine Hyperebene finden, die verschiedene Klassen von Datenpunkten vollständig trennt und gleichzeitig den Spielraum maximiert. In der realen Welt sind jedoch viele Datensätze nicht vollständig linear trennbar, was die Verwendung von Slack-Variablen erfordert, um eine Fehlklassifizierung einiger Datenpunkte zu ermöglichen und dadurch die Generalisierungsfähigkeit des Modells zu verbessern.

这里的 𝐶是一个正的调节参数,用于控制模型对误分类的惩罚程度。𝐶的值越大,模型对误分类的惩罚越重,越倾向于找到没有误分类的解;𝐶的值越小,模型对误分类的容忍度越高,越容易找到间隔更大的解,即使这意味着更多的误分类。

Selbst im Fall nichtlinearer Trennbarkeit kann SVM mithilfe des Kernel-Tricks zum Zuordnen der Daten in einen hochdimensionalen Raum in Kombination mit Slack-Variablen immer noch die Hyperebene mit dem maximalen Spielraum finden.

Die Kernelfunktion ist ein wichtiges Werkzeug in der Support Vector Machine (SVM), das es der SVM ermöglicht, nichtlineare Probleme im hochdimensionalen Raum effektiv zu bewältigen. Die Grundidee der Kernelfunktion besteht darin, die Originaldaten durch Zuordnung von einem niedrigdimensionalen Raum auf einen hochdimensionalen Raum abzubilden und die lineare Trennbarkeit der Daten in diesem hochdimensionalen Raum zu ermitteln.