2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Diese Woche habe ich einen Artikel mit dem Titel „Chasing Fairness in Graphs: A GNN Architecture Perspective“ gelesen. In diesem Artikel wird ein faires Message-Passing-Schema (FMP) vorgeschlagen, das von einem einheitlichen Optimierungsframework des Graph Neural Network (GNN) geleitet wird und darauf abzielt, die Fairness der Graphdatenverarbeitung zu verbessern. Dieser Ansatz wird durch zwei Kernschritte erreicht: Zuerst werden Diagrammdaten aggregiert und dann wird explizit die Darstellung des Zentrums jeder statistischen Grundgesamtheit angestrebt, um Verzerrungen zu reduzieren. Diese Methode erstellt ein Optimierungsproblem, das sowohl Fairness als auch Datenglätte berücksichtigt, und verwendet konjugierte Fenchel- und Gradientenabstiegstechniken in Kombination mit Softmax-Funktionsmerkmalen, um es effizient zu lösen und eine Knotendarstellung zu generieren, die sowohl fair als auch informativ ist. Dieses Schema ist direkt in GNN eingebettet, um die Fairness und Genauigkeit von Knotenklassifizierungsaufgaben ohne Datenvorverarbeitung zu verbessern. Experimentelle Ergebnisse zeigen, dass FMP bei realen Datensätzen eine bessere Leistung erbringt als mehrere Basismodelle und seine Wirksamkeit im Hinblick auf Modellarchitektur, Effizienz und Nutzung sensibler Attribute vollständig bestätigt.

Die Wochenzeitung dieser Woche entschlüsselt den Artikel mit dem Titel „Chasing Fairness in Graphs: A GNN Architecture Perspective“. Dieser Artikel stellt ein Fair Message Passing (FMP)-Schema vor, das von einem einheitlichen Optimierungsrahmen von Graph Neural Networks (GNNs) geleitet wird und darauf abzielt, die Fairness bei der Verarbeitung von Graphdaten zu verbessern. Das FMP erreicht dies durch zwei Kernschritte: zunächst die Aggregation von Graphdaten und dann das explizite Streben, die Zentren verschiedener statistischer Gruppen darzustellen, um Verzerrungen zu verringern. Dieser Ansatz formuliert ein Optimierungsproblem, das sowohl Fairness als auch Datenglätte berücksichtigt, und nutzt Fenchel-Dualitäts- und Gradientenabstiegstechniken in Kombination mit den Eigenschaften der Softmax-Funktion, um das Problem effizient zu lösen und faire und informative Knotendarstellungen zu generieren. Dieses Schema ist direkt in GNNs eingebettet, um die Fairness und Genauigkeit von Knotenklassifizierungsaufgaben zu verbessern, ohne dass eine Datenvorverarbeitung erforderlich ist. Experimentelle Ergebnisse mit realen Datensätzen zeigen, dass FMP mehrere Basismodelle übertrifft, was seine Wirksamkeit aus den Perspektiven der Modellarchitektur, Effizienz und der Nutzung sensibler Attribute umfassend bestätigt.

Titel: Auf der Suche nach Fairness in Graphen: Eine GNN-Architekturperspektive

Von: Zhimeng Jiang1, Xiaotian Han1, Chao Fan2, Zirui Liu3, Na Zou4, Ali Mostafavi1, Xia Hu3

freigeben:Band 38, Nr. 19: AAAI-24

Link: https://doi.org/10.1609/aaai.v38i19.30115

Dieser Artikel zielt darauf ab, durch das neue GNN-Framework eine bessere Fairness zu erreichen, und schlägt daher vor, innerhalb des einheitlichen Optimierungsframeworks von GNN zu entwerfenFaire Nachrichtenübermittlung (FMP) .Es ist erwähnenswert, dass FMP verwendet wirdKreuzentropieverlustPräsentieren Sie explizit die Verwendung sensibler Attribute im Vorwärtsdurchlauf für KnotenklassifizierungsaufgabenKeine Datenvorverarbeitung erforderlich .Im FMP, ErsteinsatzPolymerisationum Nachbarinformationen auszunutzen, und dannVoreingenommenheitsminderung Die Schritte schieben das Knotendarstellungszentrum der Datenstatistikgruppe explizit zusammen. Auf diese Weise kann das FMP-Schema nützliche Informationen von Nachbarn sammeln und Vorurteile abmildern, um eine bessere Fairness und Prognose-Kompromissleistung zu erreichen.KnotenklassifizierungExperimente zu dieser Aufgabe zeigen, dass das vorgeschlagene FMP mehrere Basislinien in Bezug auf Fairness und Genauigkeit bei drei realen Datensätzen übertrifft.

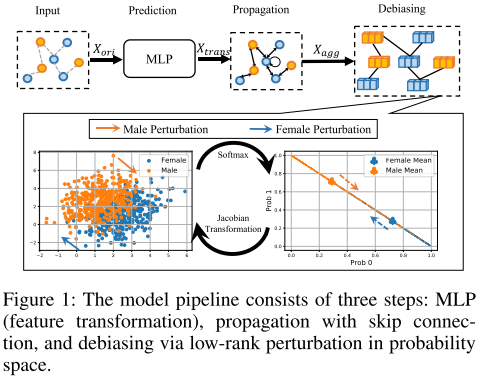

FMP kann aus Sicht des Modell-Backbones faire Vorhersagen treffen. Insbesondere wird Fair Messaging als Optimierungsproblem formuliert, um gleichzeitig Glätte und faire Knotendarstellung zu erreichen. In Kombination mit effektiven und effizienten Optimierungsalgorithmen werden geschlossene, faire Nachrichten abgeleitet. Schließlich wird das vorgeschlagene FMP in drei Phasen in ein faires GNN integriert, einschließlich Transformations-, Aggregations- und Debiasing-Schritten, wie in Abbildung 1 dargestellt. Diese drei Stufen übernehmen jeweils Knotenmerkmale, Diagrammtopologie und sensible Attribute.

min F λ s 2 tr ( FTT ~ F ) 1 2 ∣ ∣ F − X trans ∣ ∣ F 2 λ f ∣ ∣ Δ s SF ( F ) ∣ ∣ 1 (1) min_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T tilde {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{trans}||^2_F lambda_f||Delta_sSF(mathbf F)||_1 tag{1}FMindest2λSTR(FTT~F) 21∣∣F−XTReinS∣∣F2 λF∣∣ΔSSF(F)∣∣1(1)

$tilde L stellt die normalisierte Laplace-Matrix dar, stellt die normalisierte Laplace-Matrix dar,stellt die normalisierte Laplace-Matrix dar,h_s(·)$ und hf ( ⋅ ) h_f(·)HF(⋅) Stellt Glätte- und Fairnessziele dar, X trans ∈ R n × dout X_{trans} in R^{n×d_{out}}XTReinS∈RN×DÖSieT ist das Verwandelte dot d_{out}DÖSieTMerkmale des Dimensionsknotens. F ∈ R n × dout F in R^{n×d_{out}}F∈RN×DÖSieT sind aggregierte Knotenmerkmale derselben Matrixgröße.

Die ersten beiden Terme bewahren die Ähnlichkeit verbundener Knotendarstellungen und verbessern so die Glätte des Diagramms. Der letzte Term erzwingt eine faire Knotendarstellung, sodass die durchschnittliche vorhergesagte Wahrscheinlichkeit zwischen verschiedenen sensiblen Attributgruppen konstant bleiben kann.

Die Regularisierungskoeffizienten λs und λf steuern adaptiv den Kompromiss zwischen Glätte und Fairness des Graphen.

hs ( F ) = min F λ s 2 tr ( FTT ~ F ) 1 2 ∣ ∣ F − X trans ∣ ∣ F 2 h_s(mathbf F)=min_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T tilde {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{trans}||^2_FHS(F)=FMindest2λSTR(FTT~F) 21∣∣F−XTReinS∣∣F2

Glätteziel hs(·): Adjazenzmatrizen in bestehenden Graph-Messaging-Schemata werden normalisiert, um die numerische Stabilität zu verbessern und eine bessere Leistung zu erzielen.Aus einer kantenzentrierten Perspektive erzwingt das Glättungsziel, dass die Darstellungen verbundener Knoten ähnlich sind, weil

tr (FTT ~ F) = ∑ (vi, vj) ∈ E ∣ ∣ F idi 1 − F idj 1 ∣ ∣ F 2 (2) tr(mathbf F^T tilde {mathbf T}mathbf F)=sum_{(v_i,v_j)in {Epsilon}}||frac{mathbf F_i}{sqrt {d_i 1}}-frac{mathbf F_i}{sqrt{d_j 1}}||^2_F tag{2}TR(FTT~F)=(gegenichchchch,gegenJ)∈E∑∣∣Dichchchch 1Fichchchch−DJ 1Fichchchch∣∣F2(2)

Fairnessziel hf(·): Das Fairnessziel misst die Abweichung der Knotendarstellung nach der Aggregation. Der sensible Attribut-Ereignisvektor Δs stellt die sensible Attributgruppe und Gruppengröße durch Summierung von Vorzeichen und Absolutwert dar.Der sensible Attribut-Ereignisvektor ist

Δ s = 1