プライベートな連絡先の最初の情報

送料メール:

2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

今週、私は「Chasing Fairness in Graphs: A GNN Architecture Perspective」というタイトルの論文を読みました。本稿では、グラフデータ処理の公平性を向上させることを目的として、グラフニューラルネットワーク(GNN)の統合最適化フレームワークに基づく公平なメッセージパッシングスキーム(FMP)を提案する。このアプローチは、2 つの主要なステップを通じて実現されます。まず、グラフ データを集約し、次に偏りを減らすために各統計母集団の中心の表現を明示的に追求します。この方法では、公平性とデータの平滑性の両方を考慮した最適化問題を構築し、フェンケル共役および勾配降下法をソフトマックス関数の特性と組み合わせて使用して効率的に解決し、公平かつ有益なノード表現を生成します。このスキームは GNN に直接組み込まれており、データの前処理を行わずにノード分類タスクの公平性と精度を向上させます。実験結果は、実際のデータセットでは、FMP が複数のベースライン モデルよりも優れたパフォーマンスを示し、モデル アーキテクチャ、効率、機密属性の利用の観点からその有効性を完全に検証したことを示しています。

今週の週刊新聞は、「グラフの公平性の追求: GNN アーキテクチャの観点」と題する論文を解読します。この論文では、グラフ データ処理の公平性を高めることを目的とした、グラフ ニューラル ネットワーク (GNN) の統合最適化フレームワークによって導かれる公平メッセージ パッシング (FMP) スキームを紹介します。FMP は、2 つのコア ステップを通じてこれを実現します。まず、グラフ データを集約し、次にさまざまな統計グループの中心を明示的に表現して偏りを軽減します。このアプローチでは、公平性とデータの滑らかさの両方を考慮した最適化問題を定式化し、フェンチェルの双対性と勾配降下法をソフトマックス関数の特性と組み合わせて活用することで、問題を効率的に解決し、公平で有益なノード表現を生成します。このスキームは GNN に直接埋め込まれ、データの前処理を必要とせずに、ノード分類タスクの公平性と精度を向上させます。 実際のデータセットでの実験結果では、FMP が複数のベースライン モデルよりも優れていることが示されており、モデル アーキテクチャ、効率性、機密属性の利用の観点からその有効性が包括的に検証されています。

テーマ:グラフの公平性の追求:GNN アーキテクチャの観点

著者:Zhimeng Jiang1、Xiaotian Han1、Chao Fan2、Zirui Liu3、Na Zou4、Ali Mostafavi1、Xia Hu3

リリース:第38巻第19号: AAAI-24

リンク: https://doi.org/10.1609/aaai.v38i19.30115

この記事は、新しい GNN フレームワークを通じてより優れた公平性を実現することを目的としているため、GNN の統合最適化フレームワーク内で設計することを提案しています。フェアメッセージング (FMP) 。FMP が使用していることは注目に値します。クロスエントロピー損失ノード分類タスクのフォワードパスで機密属性の使用を明示的に示します。データの前処理は必要ありません 。FMP では、最初に使用します重合近隣情報を悪用し、バイアスの軽減このステップでは、データ統計グループのノード表現センターを明示的にまとめます。このように、FMP スキームは近隣からの有用な情報を集約し、バイアスを軽減して、より優れた公平性と予測のトレードオフ パフォーマンスを実現できます。ノードの分類このタスクに関する実験では、提案された FMP が 3 つの現実世界のデータセットにおける公平性と精度の点で複数のベースラインよりも優れていることが示されています。

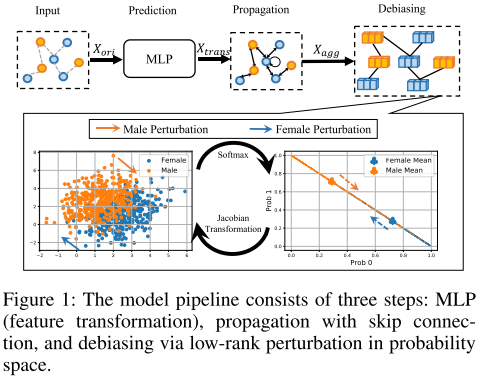

FMP はモデル バックボーンの観点から公平な予測を実現します。具体的には、公平なメッセージングを最適化問題として定式化し、滑らかさと公平なノード表現を同時に追求します。効果的かつ効率的な最適化アルゴリズムと組み合わせることで、クローズドフォームの公平なメッセージングが導き出されます。最後に、提案された FMP は、図 1 に示すように、変換、集約、バイアス除去のステップを含む 3 つの段階で公平な GNN に統合されます。これら 3 つのステージでは、それぞれノード機能、グラフ トポロジ、機密属性が採用されます。

min F λ s 2 tr ( FTT ~ F ) 1 2 ∣ ∣ F − X trans ∣ ∣ F 2 λ f ∣ ∣ Δ s SF ( F ) ∣ ∣ 1 (1) min_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T チルダ {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{trans}||^2_F lambda_f||Delta_sSF(mathbf F)||_1 tag{1}ふ分2λstr(ふTT~ふ) 21∣∣ふ−バツtrのs∣∣ふ2 λふ∣∣ΔsSF(ふ)∣∣1(1)

$チルダL は正規化されたラプラシアン行列を表し、 は正規化されたラプラシアン行列を表し、は正規化されたラプラシアン行列を表し、h_s(・)$と hf ( ⋅ ) h_f(·)hふ(⋅) 滑らかさと公平性の目標を表します。 X トランス ∈ R n × dout X_{trans} は R^{n×d_{out}} にあります。バツtrのs∈Rん×doあなたt 変身したものです アウト d_{out}doあなたtディメンションノードの特性。 F ∈ R n × dout F は R^{n×d_{out}} にありますふ∈Rん×doあなたtは、同じマトリックス サイズの集約されたノード フィーチャです。

最初の 2 つの項は、接続されたノード表現の類似性を維持するため、グラフの滑らかさが向上します。最後の項は、平均予測確率が異なる機密属性グループ間で一定に保たれるように、公平なノード表現を強制します。

正則化係数 λs と λf は、グラフの滑らかさと公平性の間のトレードオフを適応的に制御します。

hs ( F ) = min F λ s 2 tr ( FTT ~ F ) 1 2 ∣ ∣ F − X trans ∣ ∣ F 2 h_s(mathbf F)=min_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T チルダ {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{trans}||^2_Fhs(ふ)=ふ分2λstr(ふTT~ふ) 21∣∣ふ−バツtrのs∣∣ふ2

平滑性目標 hs(・): 既存のグラフ メッセージング スキームの隣接行列は、数値安定性を向上させ、優れたパフォーマンスを達成するために正規化されます。エッジ中心の観点から見ると、平滑化目的により、接続されたノード表現が類似するように強制されます。

tr ( FTT ~ F ) = ∑ ( vi , vj ) ∈ E ∣ ∣ F idi 1 − F idj 1 ∣ ∣ F 2 (2) tr(mathbf F^T チルダ {mathbf T}mathbf F)=sum_{(v_i,v_j)in {Epsilon}}||frac{mathbf F_i}{sqrt {d_i 1}}-frac{mathbf F_i}{sqrt{d_j 1}}||^2_F タグ{2}tr(ふTT~ふ)=(ヴ私,ヴじ)∈え∑∣∣d私 1ふ私−dじ 1ふ私∣∣ふ2(2)

公平性目標 hf(・): 公平性目標は、集約後のノード表現の偏差を測定します。センシティブ属性イベント ベクトル Δs は、センシティブ属性グループとグループ サイズを符号と絶対値の和で表します。機密属性のイベント ベクトルは次のとおりです。

Δs = 1