내 연락처 정보

우편메소피아@프로톤메일.com

2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

이번 주에 나는 Chasing Fairness in Graphs: A GNN Architecture Perspective라는 제목의 논문을 읽었습니다. 본 논문에서는 그래프 데이터 처리의 공정성 향상을 목표로 그래프 신경망(GNN)의 통합 최적화 프레임워크를 기반으로 하는 공정한 메시지 전달 방식(FMP)을 제안합니다. 이 접근 방식은 두 가지 핵심 단계를 통해 달성됩니다. 먼저 그래프 데이터를 집계한 다음 편향을 줄이기 위해 각 통계 모집단의 중심 표현을 명시적으로 추구합니다. 이 방법은 공정성과 데이터 매끄러움을 모두 고려한 최적화 문제를 구성하고, 이를 소프트맥스 함수 특성과 결합한 Fenchel 공액 및 경사하강법을 사용하여 효율적으로 해결함으로써 공정하고 유익한 노드 표현을 생성합니다. 이 체계는 GNN에 직접 내장되어 데이터 전처리 없이 노드 분류 작업의 공정성과 정확성을 향상시킵니다. 실험 결과에 따르면 실제 데이터 세트에서 FMP는 여러 기본 모델보다 더 나은 성능을 발휘하며 모델 아키텍처, 효율성 및 민감한 속성 활용의 관점에서 효율성을 완전히 검증합니다.

이번 주 주간 신문은 그래프에서 공정성 추구: GNN 아키텍처 관점이라는 제목의 논문을 디코딩합니다. 이 논문은 그래프 신경망(GNN)의 통합 최적화 프레임워크에 따라 안내되는 공정한 메시지 전달(FMP) 방식을 소개하여 그래프 데이터 처리의 공정성을 향상시키는 것을 목표로 합니다. FMP는 두 가지 핵심 단계를 통해 이를 달성합니다. 첫째, 그래프 데이터를 집계한 다음, 다양한 통계 그룹의 중심을 표현하여 편향을 완화하기 위해 명시적으로 노력합니다. 이 접근 방식은 공정성과 데이터 부드러움을 모두 고려하는 최적화 문제를 공식화하고, 소프트맥스 함수의 속성과 결합된 펜첼 이중성과 경사 하강 기술을 활용하여 문제를 효율적으로 해결하고 공정하고 유익한 노드 표현을 생성합니다. 이 방식은 데이터 전처리 없이도 노드 분류 작업의 공정성과 정확성을 개선하기 위해 GNN에 직접 내장됩니다. 실제 데이터 세트에 대한 실험 결과는 FMP가 여러 기준 모델보다 성능이 뛰어나 모델 아키텍처, 효율성 및 민감한 속성 활용의 관점에서 효과를 종합적으로 검증한다는 것을 보여줍니다.

태그: 그래프에서 공정성 추구: GNN 아키텍처 관점

저자: Zhimeng Jiang1, Xiaotian Han1, Chao Fan2, Zirui Liu3, Na Zou4, Ali Mostafavi1, Xia Hu3

풀어 주다:제38권 제19호: AAAI-24

링크: https://doi.org/10.1609/aaai.v38i19.30115

이 글은 새로운 GNN 프레임워크를 통해 더 나은 공정성을 달성하는 것을 목표로 하므로 GNN의 통합된 최적화 프레임워크 내에서 설계할 것을 제안합니다.공정한 메시지 전달(FMP) .FMP가 사용한다는 점은 주목할 가치가 있습니다.교차 엔트로피 손실노드 분류 작업을 위한 정방향 전달에서 민감한 속성의 사용을 명시적으로 제시하는 반면,데이터 전처리가 필요하지 않습니다. .FMP에서 먼저 사용중합이웃 정보를 활용하고,편견 완화 단계에서는 데이터 통계 그룹 노드 표현 센터를 명시적으로 함께 푸시합니다. 이러한 방식으로 FMP 체계는 이웃으로부터 유용한 정보를 수집하고 편향을 완화하여 더 나은 공정성과 예측 균형 성능을 달성할 수 있습니다.노드 분류작업에 대한 실험에서는 제안된 FMP가 세 가지 실제 데이터 세트의 공정성과 정확성 측면에서 여러 기준선보다 성능이 우수하다는 것을 보여줍니다.

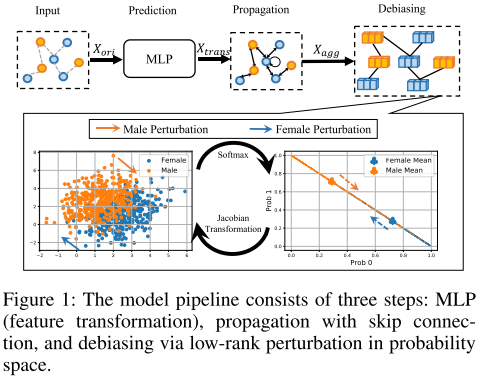

FMP는 모델 백본의 관점에서 공정한 예측을 달성할 수 있습니다. 구체적으로 공정한 메시징은 부드러움과 공정한 노드 표현을 동시에 추구하기 위한 최적화 문제로 공식화됩니다. 효과적이고 효율적인 최적화 알고리즘과 결합하여 폐쇄형 공정 메시징이 파생됩니다. 마지막으로 제안된 FMP는 그림 1과 같이 변환, 집계 및 편향성 제거 단계를 포함한 세 단계를 거쳐 공정한 GNN에 통합됩니다. 이 세 단계는 각각 노드 기능, 그래프 토폴로지 및 민감한 속성을 사용합니다.

min F λ s 2 tr ( FTT ~ F ) 1 2 ∣ ∣ F − X 트랜스 ∣ ∣ F 2 λ f ∣ ∣ Δ s SF ( F ) ∣ ∣ 1 (1) min_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T 틸드 {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{트랜스}||^2_F 람다_f||델타_sSF(mathbf F)||_1 태그{1}에프분2λ에스티아르 자형(에프티티~에프) 21∣∣에프−엑스티아르 자형하나에스∣∣에프2 λ에프∣∣Δ에스샌프란시스코(에프)∣∣1(1)

$틸데 L 정규화된 라플라시안 행렬을 나타내고, 정규화된 라플라시안 행렬을 나타내며,정규화된 라플라시안 행렬을 나타내며,h_s(·)$ 및 hf ( ⋅ ) h_f(·)시간에프(⋅) 부드러움과 공정성 목표를 나타냅니다. X trans ∈ R n × dout X_{trans} in R^{n×d_{out}}엑스티아르 자형하나에스∈아르 자형N×디영형유티 변형된 것입니다 두트 디_{아웃}디영형유티차원 노드 특성. F ∈ R n × dout F in R^{n×d_{out}}에프∈아르 자형N×디영형유티는 동일한 행렬 크기의 집계된 노드 기능입니다.

처음 두 항은 연결된 노드 표현의 유사성을 유지하여 그래프의 매끄러움을 향상시킵니다. 마지막 항은 평균 예측 확률이 서로 다른 민감한 속성 그룹 간에 일정하게 유지될 수 있도록 공정한 노드 표현을 시행합니다.

정규화 계수 람다와 람다f는 그래프 매끄러움과 공정성 사이의 균형을 적응적으로 제어합니다.

hs(F) = 최소 F λ s 2 tr(FTT ~ F) 1 2 ∣ ∣ F − X 트랜스 ∣ ∣ F 2 h_s(mathbf F) = 최소_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T 틸드 {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{트랜스}||^2_F시간에스(에프)=에프분2λ에스티아르 자형(에프티티~에프) 21∣∣에프−엑스티아르 자형하나에스∣∣에프2

Smoothness target hs(·): 수치적 안정성을 향상시키고 우수한 성능을 달성하기 위해 기존 그래프 메시징 방식의 인접 행렬을 정규화합니다.모서리 중심 관점에서 평활화 목표는 연결된 노드 표현을 유사하게 만듭니다.

tr(FTT ~ F) = ∑(vi, vj) ∈ E ∣ ∣ F idi 1 − F idj 1 ∣ ∣ F 2 (2) tr(mathbf F^T 틸드 {mathbf T}mathbf F) = sum_{(v_i,v_j)in {엡실론}}||frac{mathbf F_i}{sqrt{d_i 1}}-frac{mathbf F_i}{sqrt{d_j 1}}||^2_F 태그{2}티아르 자형(에프티티~에프)=(V나,V제이)∈이자형∑∣∣디나 1에프나−디제이 1에프나∣∣에프2(2)

공정성 목표 hf(·): 공정성 목표는 집계 후 노드 표현의 편차를 측정합니다. 민감한 속성 이벤트 벡터 Δs는 부호와 절대값의 합으로 민감한 속성 그룹과 그룹 크기를 나타냅니다.민감한 속성 이벤트 벡터는 다음과 같습니다.

Δ 초 = 1