моя контактная информация

Почтамезофия@protonmail.com

2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

На этой неделе я прочитал статью под названием «В погоне за справедливостью в графах: взгляд на архитектуру GNN». В этой статье предлагается схема справедливой передачи сообщений (FMP), основанная на единой системе оптимизации графовой нейронной сети (GNN), с целью повышения справедливости обработки графовых данных. Этот подход достигается за счет двух основных шагов: сначала агрегирование графических данных, а затем явное представление центра каждой статистической совокупности для уменьшения систематической ошибки. Этот метод создает задачу оптимизации, которая учитывает как справедливость, так и гладкость данных, и использует методы сопряжения Фенчела и градиентного спуска в сочетании с характеристиками функции softmax для эффективного ее решения, генерируя представление узла, которое является одновременно справедливым и информативным. Эта схема напрямую встроена в GNN для повышения справедливости и точности задач классификации узлов без предварительной обработки данных. Экспериментальные результаты показывают, что на реальных наборах данных FMP работает лучше, чем несколько базовых моделей, полностью подтверждая свою эффективность с точки зрения архитектуры модели, эффективности и использования конфиденциальных атрибутов.

Еженедельная газета этой недели расшифровывает статью под названием Chasing Fairness in Graphs: A GNN Architecture Perspective. В этой статье представлена схема Fair Message Passing (FMP), управляемая унифицированной оптимизационной структурой графовых нейронных сетей (GNN), направленная на повышение справедливости в обработке графовых данных. FMP достигает этого посредством двух основных шагов: во-первых, агрегации графовых данных, а затем явного стремления представить центры различных статистических групп для смягчения смещения. Этот подход формулирует задачу оптимизации, которая учитывает как справедливость, так и гладкость данных, и использует методы дуальности Фенхеля и градиентного спуска в сочетании со свойствами функции softmax для эффективного решения проблемы и создания справедливых и информативных представлений узлов. Эта схема напрямую встроена в GNN для повышения справедливости и точности задач классификации узлов без необходимости предварительной обработки данных. Экспериментальные результаты на реальных наборах данных показывают, что FMP превосходит несколько базовых моделей, всесторонне подтверждая свою эффективность с точки зрения архитектуры модели, производительности и использования чувствительных атрибутов.

Подробнее: В погоне за справедливостью в графах: перспектива архитектуры GNN

В ролях: Чжимэн Цзян1, Сяотянь Хань1, Чао Фань2, Цзыруй Лю3, На Цзоу4, Али Мостафави1, Ся Ху3

выпускать:Том 38 № 19: AAAI-24

Ссылка: https://doi.org/10.1609/aaai.v38i19.30115

Эта статья направлена на достижение большей справедливости с помощью новой структуры GNN, поэтому она предлагает проектировать в рамках единой структуры оптимизации GNN.Честный обмен сообщениями (FMP) .Стоит отметить, что FMP используетперекрестная потеря энтропииЯвно представить использование конфиденциальных атрибутов при прямом проходе для задач классификации узлов, в то время какНе требуется предварительная обработка данных .В FMP сначала используйтеполимеризацияиспользовать информацию о соседях, а затемСмягчение предвзятости Эти шаги явно объединяют центр представления узла группы статистики данных. Таким образом, схема FMP может собирать полезную информацию от соседей и смягчать предвзятости для достижения большей справедливости и эффективности прогнозирования компромисса.Классификация узловЭксперименты над этой задачей показывают, что предлагаемый FMP превосходит несколько базовых показателей с точки зрения справедливости и точности на трех реальных наборах данных.

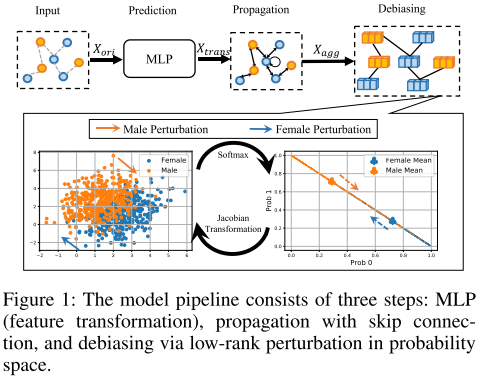

FMP может обеспечить достоверные прогнозы с точки зрения базовой модели. В частности, честный обмен сообщениями формулируется как задача оптимизации для одновременного достижения гладкости и справедливого представления узлов. В сочетании с эффективными и действенными алгоритмами оптимизации получается честный обмен сообщениями в закрытой форме. Наконец, предлагаемый FMP интегрируется в справедливую GNN в три этапа, включая этапы преобразования, агрегирования и устранения смещений, как показано на рисунке 1. На этих трех этапах используются функции узла, топология графа и конфиденциальные атрибуты соответственно.

мин F λ s 2 tr ( FTT ~ F ) 1 2 ∣ ∣ F − X trans ∣ ∣ F 2 λ f ∣ ∣ Δ s SF ( F ) ∣ ∣ 1 (1) мин_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T тильда {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{trans}||^2_F lambda_f||Delta_sSF(mathbf F)||_1 тег{1}Фмин2λстр(ФТТ~Ф) 21∣∣Ф−Икстрас∣∣Ф2 λф∣∣ΔсСФ(Ф)∣∣1(1)

$тильда L представляет нормализованную матрицу Лапласа, представляет нормализованную матрицу Лапласа,представляет собой нормализованную матрицу Лапласа,h_s(·)$ и hf ( ⋅ ) h_f(·)часф(⋅) представляет цели гладкости и справедливости, X транс ∈ R n × dout X_{транс} в R^{n×d_{out}}Икстрас∈рн×готыт это преобразованный dout d_{out}готытХарактеристики узла измерения. F ∈ R n × dout F в R^{n×d_{out}}Ф∈рн×готыт — это агрегированные узлы одного и того же размера матрицы.

Первые два члена сохраняют сходство представлений связанных узлов, тем самым повышая гладкость графа. Последний термин обеспечивает справедливое представление узла, так что средняя прогнозируемая вероятность может оставаться постоянной между различными группами чувствительных атрибутов.

Коэффициенты регуляризации λs и λf адаптивно управляют компромиссом между гладкостью и справедливостью графа.

hs ( F ) = min F λ s 2 tr ( FTT ~ F ) 1 2 ∣ ∣ F − X trans ∣ ∣ F 2 h_s(mathbf F)=min_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T тильда {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{trans}||^2_Fчасс(Ф)=Фмин2λстр(ФТТ~Ф) 21∣∣Ф−Икстрас∣∣Ф2

Целевой показатель гладкости hs(·): матрицы смежности в существующих графовых схемах обмена сообщениями нормализуются для повышения числовой стабильности и достижения превосходной производительности.С точки зрения ребра, цель сглаживания заставляет представления связанных узлов быть похожими, потому что

tr ( FTT ~ F ) = ∑ ( vi , vj ) ∈ E ∣ ∣ F idi 1 − F idj 1 ∣ ∣ F 2 (2) tr(mathbf F^T тильда {mathbf T}mathbf F)=sum_{(v_i,v_j)in {Эпсилон}}||frac{mathbf F_i}{sqrt {d_i 1}}-frac{mathbf F_i}{sqrt{d_j 1}}||^2_F тег{2}тр(ФТТ~Ф)=(вя,вдж)∈Э∑∣∣гя 1Фя−гдж 1Фя∣∣Ф2(2)

Цель справедливости hf(·): Цель справедливости измеряет отклонение представления узла после агрегирования. Вектор событий конфиденциального атрибута Δs представляет группу чувствительных атрибутов и размер группы путем суммирования знака и абсолютного значения.Вектор событий чувствительного атрибута:

Δс = 1