Mi informacion de contacto

Correo[email protected]

2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Esta semana leí un artículo titulado Persiguiendo la equidad en gráficos: una perspectiva de arquitectura GNN. Este artículo propone un esquema de paso de mensajes justo (FMP) guiado por un marco de optimización unificado de red neuronal de gráficos (GNN), con el objetivo de mejorar la equidad del procesamiento de datos de gráficos. Este enfoque se logra mediante dos pasos principales: primero agregar datos gráficos y luego buscar explícitamente la representación del centro de cada población estadística para reducir el sesgo. Este método construye un problema de optimización que considera tanto la equidad como la suavidad de los datos, y utiliza técnicas de descenso de gradiente y conjugado de Fenchel combinadas con características de la función softmax para resolverlo de manera eficiente, generando una representación de nodo que es justa e informativa. Este esquema está directamente integrado en GNN para mejorar la equidad y precisión de las tareas de clasificación de nodos sin preprocesamiento de datos. Los resultados experimentales muestran que en conjuntos de datos reales, FMP funciona mejor que múltiples modelos de referencia, verificando completamente su efectividad desde las perspectivas de la arquitectura del modelo, la eficiencia y la utilización de atributos sensibles.

El periódico semanal de esta semana descifra el artículo titulado Chasing Fairness in Graphs: A GNN Architecture Perspective. Este artículo presenta un esquema de Paso de Mensajes Justos (FMP) guiado por un marco de optimización unificado de Redes Neuronales de Gráficos (GNN), con el objetivo de mejorar la equidad en el procesamiento de datos de gráficos. El FMP logra esto a través de dos pasos principales: primero, agregando datos de gráficos y luego esforzándose explícitamente por representar los centros de varios grupos estadísticos para mitigar el sesgo. Este enfoque formula un problema de optimización que considera tanto la equidad como la suavidad de los datos, y aprovecha las técnicas de dualidad de Fenchel y descenso de gradiente, combinadas con las propiedades de la función softmax, para resolver eficientemente el problema y generar representaciones de nodos justas e informativas. Este esquema está directamente integrado en las GNN para mejorar la equidad y la precisión de las tareas de clasificación de nodos, sin la necesidad de preprocesamiento de datos. Los resultados experimentales en conjuntos de datos del mundo real muestran que FMP supera a múltiples modelos de referencia, validando de manera integral su efectividad desde las perspectivas de la arquitectura del modelo, la eficiencia y la utilización de atributos sensibles.

Tema: En busca de la equidad en los gráficos: una perspectiva de la arquitectura GNN

Actores: Zhimeng Jiang1, Xiaotian Han1, Chao Fan2, Zirui Liu3, Na Zou4, Ali Mostafavi1, Xia Hu3

liberar:Volumen 38 Núm. 19: AAAI-24

Enlace: https://doi.org/10.1609/aaai.v38i19.30115

Este artículo tiene como objetivo lograr una mayor equidad a través del nuevo marco GNN, por lo que propone diseñar dentro del marco de optimización unificado de GNN.Mensajería justa (FMP) .Vale la pena señalar que FMP utilizapérdida de entropía cruzadaPresentar explícitamente el uso de atributos sensibles en el paso directo para tareas de clasificación de nodos, mientrasNo se requiere preprocesamiento de datos .En FMP, primer usopolimerizaciónpara explotar la información del vecino, y luegoMitigación de sesgos Los pasos unen explícitamente el centro de representación de nodos del grupo de estadísticas de datos. De esta manera, el esquema FMP puede agregar información útil de los vecinos y mitigar los sesgos para lograr una mejor equidad y un desempeño de compensación de predicción.Clasificación de nodosLos experimentos sobre la tarea muestran que el FMP propuesto supera múltiples líneas de base en términos de equidad y precisión en tres conjuntos de datos del mundo real.

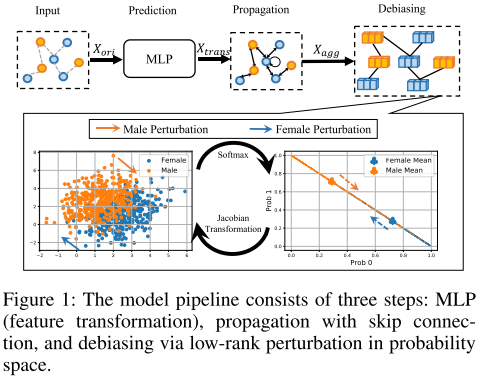

FMP puede lograr predicciones justas desde la perspectiva de la columna vertebral del modelo. Específicamente, la mensajería justa se formula como un problema de optimización para perseguir simultáneamente la fluidez y la representación justa de los nodos. Combinado con algoritmos de optimización eficaces y eficientes, se derivan mensajes justos de formato cerrado. Finalmente, el FMP propuesto se integra en una GNN justa en tres etapas, que incluyen pasos de transformación, agregación y eliminación de sesgos, como se muestra en la Figura 1. Estas tres etapas emplean características de nodo, topología de gráficos y atributos sensibles, respectivamente.

mín F λ s 2 tr ( FTT ~ F ) 1 2 ∣ ∣ F − X trans ∣ ∣ F 2 λ f ∣ ∣ Δ s SF ( F ) ∣ ∣ 1 (1) min_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T tilde {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{trans}||^2_F lambda_f||Delta_sSF(mathbf F)||_1 etiqueta{1}Fmín.2λsaa(Fyoyo~F) 21∣∣F−Xaauns∣∣F2 λF∣∣ΔsSF(F)∣∣1(1)

tilde L representa la matriz laplaciana normalizada, representa la matriz laplaciana normalizada,representa la matriz laplaciana normalizada,h_s(·)$ y hf ( ⋅ ) h_f(·)yoF(⋅) representa objetivos de suavidad y equidad, X trans ∈ R n × dout X_{trans} en R^{n×d_{out}}Xaauns∈Rnorteorte×dotúa es el transformado duda d_{fuera}dotúaCaracterísticas del nodo de dimensión. F ∈ R n × dosalida F en R^{n×d_{salida}}F∈Rnorteorte×dotúaSon características de nodos agregados del mismo tamaño de matriz.

Los dos primeros términos preservan la similitud de las representaciones de los nodos conectados, mejorando así la suavidad del gráfico. El último término impone una representación de nodo justa para que la probabilidad promedio predicha pueda permanecer constante entre diferentes grupos de atributos sensibles.

Los coeficientes de regularización λs y λf controlan de forma adaptativa el equilibrio entre la suavidad y la equidad del gráfico.

hs ( F ) = min F λ s 2 tr ( FTT ~ F ) 1 2 ∣ ∣ F − X trans ∣ ∣ F 2 h_s(mathbf F)=min_{mathbf F}frac{lambda_s}{2}tr(mathbf F^T tilde {mathbf T}mathbf F) frac12||mathbf F-mathbf X_{trans}||^2_Fyos(F)=Fmín.2λsaa(Fyoyo~F) 21∣∣F−Xaauns∣∣F2

Objetivo de suavidad hs(·): Las matrices de adyacencia en los esquemas de mensajería de gráficos existentes se normalizan para mejorar la estabilidad numérica y lograr un rendimiento superior.Desde una perspectiva centrada en los bordes, el objetivo de suavizado obliga a que las representaciones de los nodos conectados sean similares porque

tr ( FTT ~ F ) = ∑ ( vi , vj ) ∈ E ∣ ∣ F idi 1 − F idj 1 ∣ ∣ F 2 (2) tr(F^T tilde {T}F)=suma_{(v_i,v_j)en {Épsilon}}||frac{F_i}{sqrt {d_i 1}}-frac{F_i}{sqrt{d_j 1}}||^2_F etiqueta{2}aa(Fyoyo~F)=(eni,enyo)∈mi∑∣∣di 1Fi−dyo 1Fi∣∣F2(2)

Objetivo de equidad hf(·): El objetivo de equidad mide la desviación de la representación del nodo después de la agregación. El vector de eventos de atributos sensibles Δs representa el grupo de atributos sensibles y el tamaño del grupo mediante la suma del signo y el valor absoluto.El vector de eventos de atributos sensibles es

Δs = 1