2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Inhaltsverzeichnis

Über eine einzelne randomisierte kontrollierte Studie hinaus

Aggregieren von Mittelwertdifferenzschätzern

Kontinuierliches X und der Propensity Score

Eine der einfachsten Erweiterungen randomisierter Studien ist die uneingeschränkte Schätzung von Interventionseffekten. Qualitativ gesehen ist Unbegrenztheit relevant, wenn wir einen Behandlungseffekt abschätzen wollen, der nicht zufällig, sondern so gut wie zufällig ist, sobald wir eine Reihe von Kovariaten Xi kontrollieren.

Der Zweck dieser Vorlesung besteht darin, die Identifizierung und Schätzung durchschnittlicher Interventionseffekte unter dieser unbegrenzten Annahme zu diskutieren. Wie zuvor werden wir einen nichtparametrischen Ansatz verfolgen: Wir gehen nicht von einer guten Spezifikation eines parametrischen Modells aus und die Identifizierung durchschnittlicher Behandlungseffekte wird vollständig durch das Design bestimmt (d. h. bedingte Unabhängigkeitsansprüche in Bezug auf potenzielle Interventionsergebnisse und Behandlungen).

Wir definieren den kausalen Effekt einer Behandlung über ihr mögliches Interventionsergebnis. Für eine binäre Intervention w∈{0, 1} definieren wir mögliche Ergebnisse Yi(1) und Yi(0), die den Ergebnissen entsprechen, die das i-te Subjekt erleben würde, wenn es die Intervention erhält bzw. nicht erhält. Wir gehen davon aus, dass SUTVA,und möchten den durchschnittlichen Interventionseffekt abschätzen

In der ersten Vorlesung gingen wir von einer zufälligen Interventionszuweisung aus,und mehrere √n konsistente Schätzer von ATE werden untersucht.

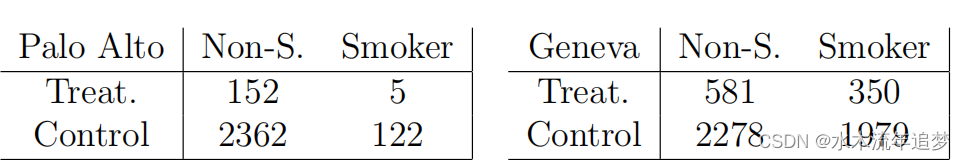

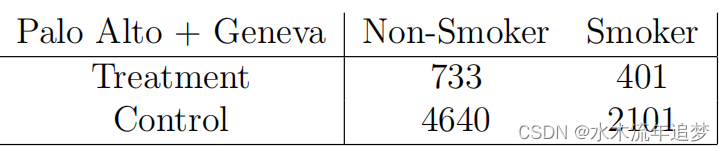

Der einfachste Weg, über einen RCT hinauszugehen, besteht darin, zwei RCTs in Betracht zu ziehen. Nehmen wir als konkretes Beispiel an, dass wir daran interessiert sind, Teenagern Geldprämien zu geben, um sie vom Rauchen abzuhalten. Fünf Prozent der Jugendlichen in Palo Alto, Kalifornien, und 20 Prozent der Jugendlichen in Genf, Schweiz, waren zur Teilnahme an der Studie berechtigt.

In jeder Stadt führten wir randomisierte kontrollierte Studien durch, und es war tatsächlich leicht zu erkennen, dass die Intervention half. Die Betrachtung aggregierter Daten kann jedoch irreführend sein und den Eindruck erwecken, dass ein Eingriff Schaden anrichtet. Dies ist ein Beispiel für das, was manchmal als Simpson-Paradoxon bezeichnet wird: Nachdem wir die Daten zusammengefasst hatten, handelte es sich hierbei nicht mehr um eine RCT, da Genfer unabhängig davon, ob sie eine Behandlung erhielten, sowohl häufiger in Behandlung waren als auch häufiger rauchten. Um konsistente ATE-Schätzungen zu erhalten, müssen wir den Interventionseffekt für jede Stadt separat schätzen:

Nachdem wir die Daten zusammengefasst hatten, handelte es sich hierbei nicht mehr um eine RCT, da Genfer unabhängig davon, ob sie eine Behandlung erhielten, sowohl häufiger in Behandlung waren als auch häufiger rauchten. Um konsistente ATE-Schätzungen zu erhalten, müssen wir den Interventionseffekt für jede Stadt separat schätzen:

Was sind die statistischen Eigenschaften dieses Schätzers? Wie lässt sich diese Idee auf aufeinanderfolgende x verallgemeinern?

Angenommen, die Kovariate Xi nimmt Werte im diskreten Raum Xi∈X an, . Nehmen wir weiter an, dass die Behandlungszuteilung eine zufällige Zuteilung ist, die von Xi abhängig ist (d. h. jede Gruppe hat einen RCT, der durch die x-Ebene definiert ist):

Definieren Sie den durchschnittlichen Behandlungseffekt innerhalb der Gruppe als

Dann können wir, wie oben erwähnt, ATE τ schätzen, indem wir Behandlungseffektschätzungen auf Gruppenebene aggregieren.

In ,

. Wie gut ist diese Schätzung?Intuitiv müssen wir schätzen

„Parameter“, also könnten wir erwarten, dass die Varianz linear mit p ist?

Um diese Schätzung zu untersuchen, können wir sie wie folgt schreiben. Definieren Sie zunächst für jede Gruppe mit der Kovariate x e(x) als die Wahrscheinlichkeit, in dieser Gruppe eine Behandlung zu erhalten. , und notiert

Darüber hinaus gem Ohne uns auf die vereinfachenden Annahmen von w zu verlassen, können wir erhalten

Als nächstes werden wir für den Ensembleschätzer Folgendes tun definiert als

Der Anteil der Beobachtungen wird sein

Definiert als erwarteter Wert, den wir erhalten können

Wenn wir diese Teile zusammenfügen, erhalten wir

Es ist erwähnenswert, dass die asymptotische Varianz VAGG nicht von der Anzahl der Gruppen abhängt Wie wir später sehen werden, spielt diese Tatsache eine Schlüsselrolle bei der effizienten Erstellung semiparametrischer Schlussfolgerungen über durchschnittliche Interventionseffekte in Beobachtungsstudien.

Oben haben wir den Fall betrachtet, in dem X diskret ist und die Anzahl der Ebenen begrenzt ist und die Behandlung Wi so zufällig ist wie die Bedingung Xi = x in (2.1). In diesem Fall stellen wir fest, dass ATE immer noch genau geschätzt werden kann, indem Schätzungen des Behandlungseffekts innerhalb der Gruppe aggregiert werden und die genaue Anzahl der Gruppen |X = p keinen Einfluss auf die Genauigkeit der Schlussfolgerung hat. Dieses Ergebnis gilt jedoch nicht direkt, wenn X stetig ist (oder wenn die Chi-Quadrat-Zahl von τ (x) wie in definiert ist.

Um unsere Analyse über den Fall des diskreten X hinaus zu verallgemeinern, können wir nicht mehr einfach versuchen, τ(x) für jeden Wert von zu schätzen Dazu müssen wir zunächst die Hypothese verallgemeinern, dass es für jede Gruppe einen RCT gibt.Formal schreiben wir einfach das Gleiche

Obwohl Xi nun eine beliebige Zufallsvariable sein kann, muss diese Aussage möglicherweise mit größerer Vorsicht interpretiert werden. Aus qualitativer Sicht besteht ein Verständnis von (2.6) darin, dass wir genügend Kovariaten gemessen haben, um jede Abhängigkeit zwischen Wi und dem potenziellen Ergebnis zu erfassen, sodass Wi bei gegebenem Xi nicht „Peep“{Yi(0), Yi(1)} kann. .Wir nennen diese HypotheseUnbefangenheit.

Annahme (2.6) scheint in der Praxis schwierig anzuwenden, da sie Bedingungen für kontinuierliche Zufallsvariablen beinhaltet.Allerdings, wie Rosenbaum und Rubin (1983) betonen, durch Berücksichtigung des Propensity Score

Statistisch gesehen besteht eine Schlüsseleigenschaft des Propensity-Scores darin, dass es sich um einen ausgeglichenen Score handelt: Wenn (2.6) gilt, dann tatsächlich

Das heißt, Sie müssen eigentlich nur e(X) und nicht X kontrollieren, um die Verzerrung zu beseitigen, die mit der nicht zufälligen Zuordnung zur Intervention verbunden ist. Wir können diese Aussage überprüfen durch:

Die Implikation aus (2.8) ist, dass wir dies können, wenn wir die Beobachtungen in Gruppen mit (fast) konstanten Werten des Propensity Scores e(x) einteilen können Varianten der konsistenten Schätzung des durchschnittlichen Interventionseffekts.