le mie informazioni di contatto

Posta[email protected]

2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

19 luglio 2023: Meta ha rilasciato il modello commerciale open source Llama 2.

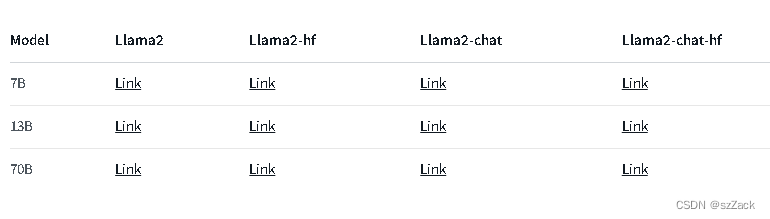

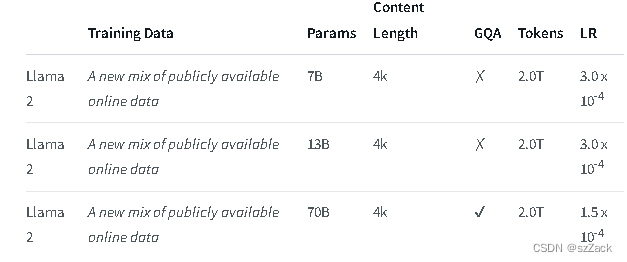

Llama 2 è una raccolta di modelli di testo generativi preaddestrati e ottimizzati di dimensioni variabili da 7 miliardi a 70 miliardi di parametri.

Gli LLM ottimizzati, chiamati Llama-2-Chat, sono ottimizzati per casi d'uso conversazionali. Il modello Llama-2-Chat supera i modelli di chat open source nella maggior parte dei benchmark che abbiamo testato ed è alla pari con alcuni popolari modelli closed source come ChatGPT e PaLM nelle valutazioni umane di utilità e sicurezza.

LLaMA-2-chat è quasi l'unico modello open source che esegue RLHF. Dopo 5 round di RLHF, LLaMA-2 ha mostrato prestazioni migliori rispetto a ChatGPT sotto la valutazione del modello di ricompensa di Meta e di GPT-4.

https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

indirizzo:

https://github.com/facebookresearch/llama

indirizzo:

https://huggingface.co/meta-llama

Chat di Llama2:

Per altri modelli consultare:

https://huggingface.co/meta-llama

La lunghezza del contesto è 4K.

Gratuito per uso commerciale

Richiesta domanda di registrazione

https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

https://github.com/facebookresearch/llama

https://huggingface.co/meta-llama