2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

२०२३ तमस्य वर्षस्य जुलैमासस्य १९ दिनाङ्के मेटा इत्यनेन मुक्तस्रोतव्यापारिकमाडलं ल्लामा २ इति प्रदर्शितम् ।

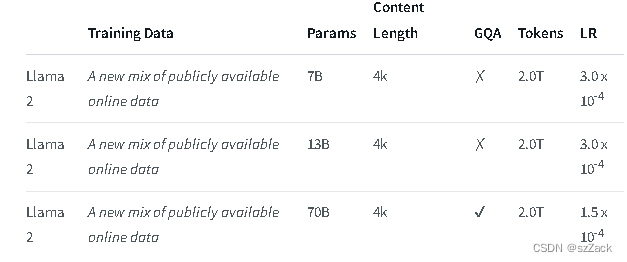

ल्लामा २ ७ अरबतः ७० अरबपर्यन्तं मापदण्डपर्यन्तं पूर्वप्रशिक्षितानां सूक्ष्मतया च जननात्मकपाठप्रतिमानानाम् एकः संग्रहः अस्ति ।

Llama-2-Chat इति नामकं सूक्ष्म-समायोजनं LLMs संभाषण-उपयोग-प्रकरणानाम् अनुकूलनं भवति । Llama-2-Chat मॉडल् अस्माभिः परीक्षितेषु अधिकांशेषु बेन्चमार्केषु मुक्तस्रोतचैट मॉडल् इत्यस्मात् अधिकं प्रदर्शनं करोति, तथा च उपयोगितायाः सुरक्षायाश्च मानवीयमूल्यांकनेषु ChatGPT तथा PaLM इत्यादिषु केषुचित् लोकप्रियेषु बन्दस्रोतमाडलयोः सममूल्यम् अस्ति

LLaMA-2-chat इति प्रायः एकमात्रं मुक्तस्रोतप्रतिरूपं यत् RLHF करोति । RLHF इत्यस्य ५ दौरस्य अनन्तरं मेटा इत्यस्य स्वस्य पुरस्कारप्रतिरूपस्य GPT-4 इत्यस्य च मूल्याङ्कनस्य अन्तर्गतं LLaMA-2 इत्यनेन ChatGPT इत्यस्मात् उत्तमं प्रदर्शनं दर्शितम् ।

https://ai.meta.com/research/publications/llama-2-ओपन-फाउंडेशन-एण्ड-फाइन-ट्यून्ड-चैट-माडल/

पत्रसङ्केतः:

https://github.com/facebookresearch/llama इति वृत्तान्तः इति वृत्तान्तः

पत्रसङ्केतः:

https://huggingface.co/मेटा-लामा

ल्लमा२-चर्चा: २.

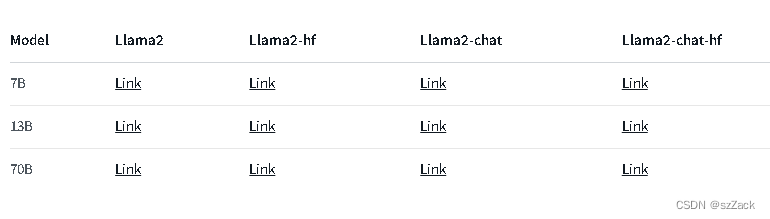

अन्येषां मॉडलानां कृते कृपया पश्यन्तु:

https://huggingface.co/मेटा-लामा

सन्दर्भदीर्घता 4K अस्ति ।

व्यावसायिकप्रयोगाय निःशुल्कम्

पञ्जीकरण आवेदन आवश्यक

https://ai.meta.com/research/publications/llama-2-ओपन-फाउंडेशन-एण्ड-फाइन-ट्यून्ड-चैट-माडल/

https://github.com/facebookresearch/llama इति वृत्तान्तः इति वृत्तान्तः

https://huggingface.co/मेटा-लामा