내 연락처 정보

우편메소피아@프로톤메일.com

2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

2023년 7월 19일: Meta가 오픈소스 상용 모델 Llama 2를 출시했습니다.

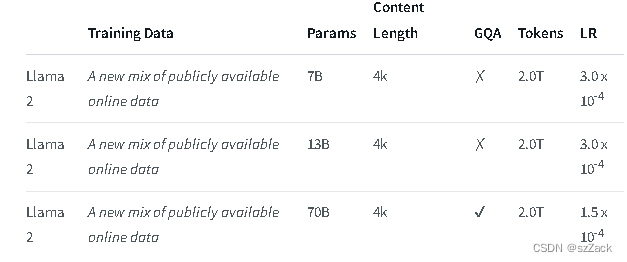

Llama 2는 70억에서 700억 개의 매개변수 크기에 이르는 사전 학습되고 미세 조정된 생성 텍스트 모델 모음입니다.

Llama-2-Chat이라고 하는 미세 조정된 LLM은 대화 사용 사례에 최적화되어 있습니다. Llama-2-Chat 모델은 우리가 테스트한 대부분의 벤치마크에서 오픈 소스 채팅 모델보다 성능이 뛰어나며 유용성과 보안에 대한 인간 평가에서 ChatGPT 및 PaLM과 같은 인기 있는 일부 비공개 소스 모델과 동등합니다.

LLaMA-2-chat은 RLHF를 수행하는 거의 유일한 오픈 소스 모델입니다. RLHF 5회 진행 후 Meta 자체 보상 모델과 GPT-4 평가 결과 LLaMA-2가 ChatGPT보다 좋은 성능을 보였습니다.

https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

주소:

https://github.com/facebookresearch/llama

주소:

https://huggingface.co/meta-llama

라마2채팅:

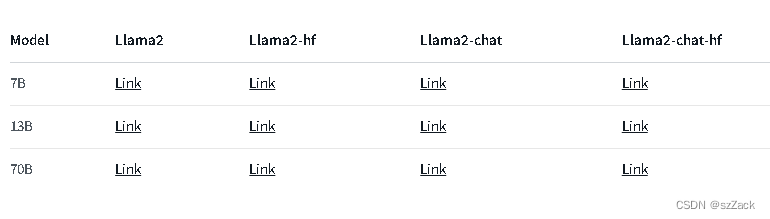

다른 모델의 경우 다음을 확인하십시오.

https://huggingface.co/meta-llama

컨텍스트 길이는 4K입니다.

상업적 용도로는 무료

등록 신청이 필요합니다

https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

https://github.com/facebookresearch/llama

https://huggingface.co/meta-llama