私の連絡先情報

郵便メール:

2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

2023 年 7 月 19 日: Meta がオープンソース商用モデル Llama 2 をリリースしました。

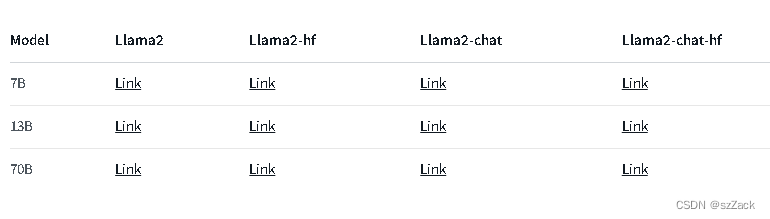

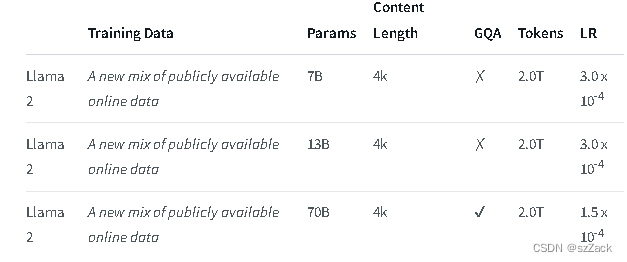

Llama 2 は、事前トレーニングされ、微調整された生成テキスト モデルのコレクションであり、そのサイズは 70 億から 700 億のパラメーターに及びます。

Llama-2-Chat と呼ばれる微調整された LLM は、会話のユースケース向けに最適化されています。 Llama-2-Chat モデルは、テストしたほとんどのベンチマークでオープンソース チャット モデルを上回り、有用性とセキュリティに関する人による評価では、ChatGPT や PaLM などの人気のあるクローズド ソース モデルと同等です。

LLaMA-2-chat は、RLHF を実行するほぼ唯一のオープンソース モデルです。 5 ラウンドの RLHF の後、Meta 独自の報酬モデルと GPT-4 の評価では、LLaMA-2 が ChatGPT よりも優れたパフォーマンスを示しました。

https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

住所:

https://github.com/facebookresearch/llama

住所:

https://huggingface.co/meta-llama

Llama2チャット:

他のモデルについては、以下をご確認ください。

https://huggingface.co/meta-llama

コンテキスト長は 4K です。

商用利用は無料

登録申請が必要です

https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

https://github.com/facebookresearch/llama

https://huggingface.co/meta-llama