2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

19 juillet 2023 : Meta publie le modèle commercial open source Llama 2.

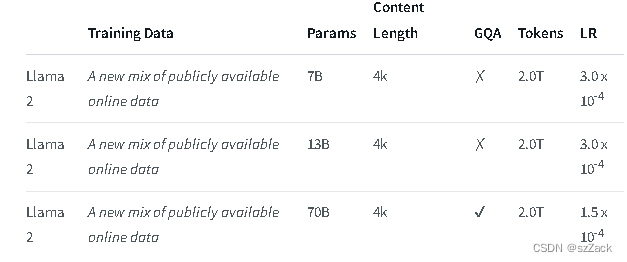

Llama 2 est une collection de modèles de texte génératifs pré-entraînés et affinés dont la taille varie de 7 milliards à 70 milliards de paramètres.

Les LLM affinés, appelés Llama-2-Chat, sont optimisés pour les cas d'utilisation conversationnels. Le modèle Llama-2-Chat surpasse les modèles de discussion open source sur la plupart des tests que nous avons testés et est à égalité avec certains modèles fermés populaires comme ChatGPT et PaLM dans les évaluations humaines de l'utilité et de la sécurité.

LLaMA-2-chat est presque le seul modèle open source qui effectue le RLHF. Après 5 tours de RLHF, LLaMA-2 a montré de meilleures performances que ChatGPT sous l'évaluation du propre modèle de récompense de Meta et de GPT-4.

https://ai.meta.com/research/publications/llama-2-open-foundation-et-fine-tuned-chat-models/

adresse:

https://github.com/facebookresearch/llama

adresse:

https://huggingface.co/meta-llama

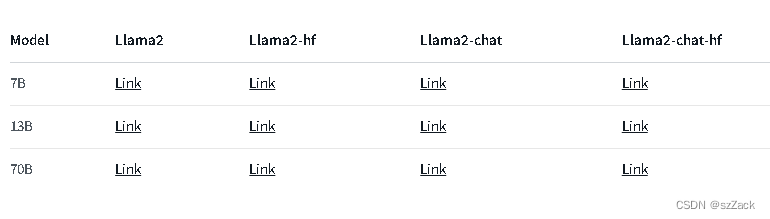

Chat Llama2 :

Pour les autres modèles, veuillez vérifier :

https://huggingface.co/meta-llama

La longueur du contexte est de 4K.

Gratuit pour un usage commercial

Demande d'inscription obligatoire

https://ai.meta.com/research/publications/llama-2-open-foundation-et-fine-tuned-chat-models/

https://github.com/facebookresearch/llama

https://huggingface.co/meta-llama