τα στοιχεία επικοινωνίας μου

Ταχυδρομείο[email protected]

2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Σήμερα, με την ταχεία ανάπτυξη της τεχνητής νοημοσύνης, η αναζήτηση αποτελεσματικών και εξαιρετικών μοντέλων γλώσσας ώθησε την ομάδα του Google DeepMind να αναπτύξει το πρωτοποριακό μοντέλο RecurrentGemma. Αυτό το νέο μοντέλο, που περιγράφεται λεπτομερώς στην εργασία "RecurrentGemma: Efficient Open Language Models Beyond Transformers", υπόσχεται να επαναπροσδιορίσει τα πρότυπα επεξεργασίας γλώσσας συνδυάζοντας μηχανισμούς γραμμικής αναδρομής και τοπικής προσοχής.

Η αρχιτεκτονική του μοντέλου RecurrentGemma είναι ο πυρήνας της αποτελεσματικής απόδοσής του. Βασίζεται στην αρχιτεκτονική Griffin που προτείνεται από την Google DeepMind. Όταν εμβαθύνουμε στην αρχιτεκτονική μοντέλων του RecurrentGemma, πρέπει πρώτα να κατανοήσουμε τη βάση της αρχιτεκτονικής Griffin και πώς το RecurrentGemma καινοτομεί και βελτιστοποιεί στη βάση της.

Το RecurrentGemma κάνει μια βασική τροποποίηση στην αρχιτεκτονική Griffin, η οποία περιλαμβάνει την επεξεργασία των ενσωματώσεων εισόδου. Η ενσωμάτωση εισόδου του μοντέλου πολλαπλασιάζεται με μια σταθερά ίση με την τετραγωνική ρίζα του πλάτους του μοντέλου. Αυτή η επεξεργασία προσαρμόζει την πλευρά εισόδου του μοντέλου, αλλά δεν αλλάζει την πλευρά εξόδου, επειδή η ενσωμάτωση εξόδου δεν εφαρμόζει αυτόν τον συντελεστή πολλαπλασιασμού. Αυτή η προσαρμογή επιτρέπει στο μοντέλο να επεξεργάζεται πληροφορίες πιο αποτελεσματικά, διατηρώντας παράλληλα τη συνέπεια στα πλάτη του μοντέλου. Αυτή η τροποποίηση παίζει σημαντικό ρόλο στη μαθηματική έκφραση και τη ροή πληροφοριών του μοντέλου. Όχι μόνο βελτιστοποιεί την αρχική επεξεργασία δεδομένων εισόδου από το μοντέλο, αλλά βοηθά επίσης το μοντέλο να αποτυπώνει και να αναπαριστά καλύτερα τα χαρακτηριστικά της γλώσσας προσαρμόζοντας την κλίμακα της ενσωμάτωσης.

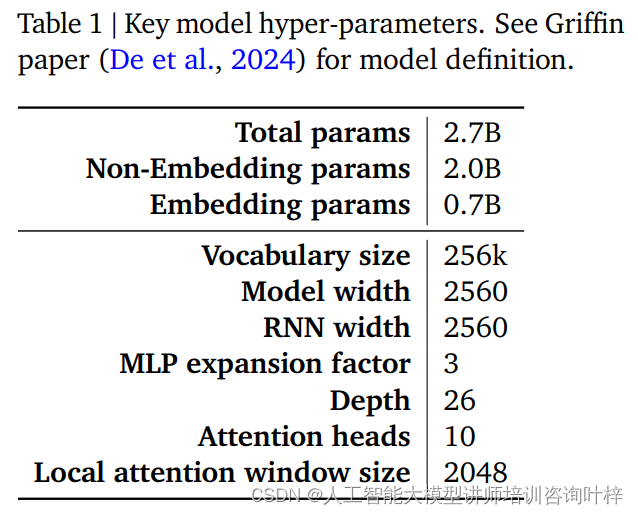

Η απόδοση και η αποδοτικότητα ενός μοντέλου RecurrentGemma καθορίζονται σε μεγάλο βαθμό από τις υπερπαράμετρές του. Αυτές οι υπερπαράμετροι αποτελούν βασικό μέρος του ορισμού του μοντέλου και περιλαμβάνουν, αλλά δεν περιορίζονται σε αυτές, τις ακόλουθες πτυχές:

Ο Πίνακας 1 παρέχει μια περίληψη αυτών των βασικών υπερπαραμέτρων και ένας πιο λεπτομερής ορισμός του μοντέλου μπορεί να βρεθεί στο έγγραφο Griffin από τους De et al. Μαζί, αυτές οι υπερπαράμετροι αποτελούν τη βάση του μοντέλου RecurrentGemma, επιτρέποντάς του να επιτύχει αποτελεσματική επεξεργασία μεγάλων ακολουθιών διατηρώντας παράλληλα ένα μικρό αποτύπωμα μνήμης.

Μέσω προσεκτικών τροποποιήσεων στην αρχιτεκτονική Griffin και προσεκτικής προσαρμογής των υπερπαραμέτρων, το μοντέλο RecurrentGemma όχι μόνο αποδεικνύει την πρόοδό του στη θεωρία, αλλά αποδεικνύει επίσης την αποτελεσματικότητά του και τις ισχυρές του δυνατότητες επεξεργασίας γλώσσας σε πρακτικές εφαρμογές.

Η προ-εκπαίδευση του RecurrentGemma-2B χρησιμοποιεί 2 τρισεκατομμύρια μάρκες Αν και αυτή η ποσότητα δεδομένων είναι μικρότερη από τα 3 τρισεκατομμύρια μάρκες που χρησιμοποιεί η Gemma-2B, εξακολουθεί να αποτελεί ένα τεράστιο σύνολο δεδομένων και παρέχει πλούσιες γλωσσικές πληροφορίες για το μοντέλο.

Οι πηγές δεδομένων για την προεκπαίδευση είναι κυρίως αγγλικά ηλεκτρονικά έγγραφα, μαθηματικά και κωδικοί. Αυτά τα δεδομένα όχι μόνο καλύπτουν ένα ευρύ φάσμα θεμάτων και περιοχών, αλλά φιλτράρονται και καθαρίζονται προσεκτικά για να μειωθεί το ανεπιθύμητο ή μη ασφαλές περιεχόμενο και να αποκλειστούν προσωπικά ή ευαίσθητα δεδομένα. Επιπλέον, για να διασφαλιστεί η δίκαιη αξιολόγηση, όλα τα σετ αξιολόγησης εξαιρούνται από το σύνολο δεδομένων πριν από την εκπαίδευση.

Το RecurrentGemma-2B χρησιμοποιεί πρώτα ένα μεγάλο μείγμα γενικών δεδομένων στην προ-εκπαίδευση και στη συνέχεια μετακινείται σε μικρότερα αλλά υψηλότερης ποιότητας σύνολα δεδομένων για περαιτέρω εκπαίδευση. Αυτή η σταδιακή προσέγγιση εκπαίδευσης βοηθά το μοντέλο να μάθει μια γενική αναπαράσταση γλώσσας σε ένα ευρύ φάσμα δεδομένων και στη συνέχεια να την τελειοποιήσει και να τη βελτιστοποιήσει με πιο εξειδικευμένα δεδομένα.

Μετά την προεκπαίδευση, το RecurrentGemma-2B βελτιστοποιήθηκε μέσω του συντονισμού εντολών και του αλγόριθμου RLHF. Αυτή η διαδικασία στοχεύει στη βελτιστοποίηση του μοντέλου ώστε να μπορεί να ακολουθεί καλύτερα τις οδηγίες και να δημιουργεί απαντήσεις με υψηλές ανταμοιβές.

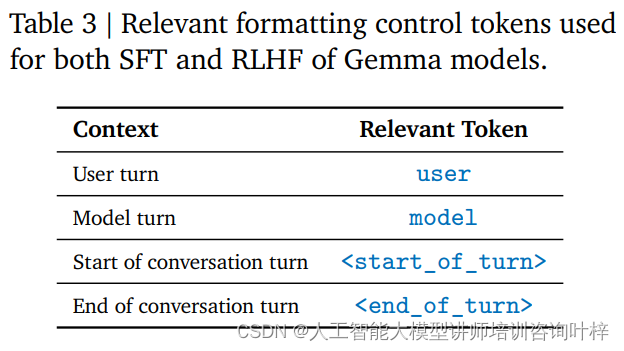

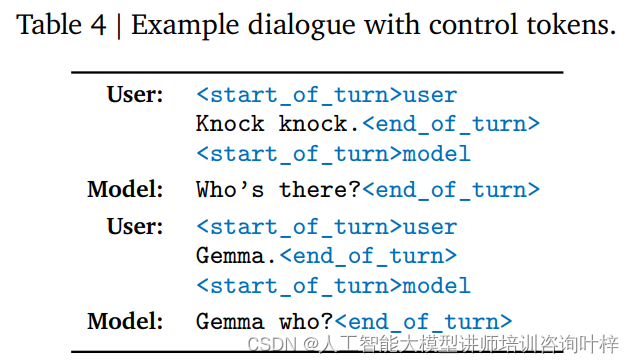

Το Instruction Tuning είναι μια μέθοδος εκπαίδευσης που επιτρέπει σε ένα μοντέλο να κατανοήσει και να ανταποκριθεί σε μια συγκεκριμένη μορφή εντολών. Το RecurrentGemma-2B έχει εκπαιδευτεί να προσκολλάται σε μια συγκεκριμένη μορφή συνομιλίας, η οποία ορίζεται από συγκεκριμένες ετικέτες ελέγχου, όπως η είσοδος χρήστη και η έξοδος μοντέλου προσδιορίζονται με διαφορετικές ετικέτες.

Ο αλγόριθμος RLHF είναι μια προηγμένη τεχνική μικρορύθμισης που βελτιστοποιεί την έξοδο του μοντέλου μέσω ενός πλαισίου ενισχυτικής μάθησης. Στο RLHF, η απόδοση του μοντέλου αξιολογείται με βάση την ανθρώπινη ανατροφοδότηση και προσαρμόζεται με βάση τα αποτελέσματα της αξιολόγησης για τη βελτίωση της ποιότητας της παραγωγής και των ανταμοιβών. Αυτός ο αλγόριθμος επιτρέπει στο μοντέλο να μάθει πώς να δημιουργεί πιο κατάλληλες αποκρίσεις σε διαφορετικά περιβάλλοντα.

Μέσω της προσαρμογής εντολών και της μικρορύθμισης RLHF, το RecurrentGemma-2B όχι μόνο είναι σε θέση να παράγει υψηλής ποιότητας έξοδο γλώσσας, αλλά επίσης αποδίδει καλά στη συνομιλία και ακολουθώντας τις οδηγίες. Αυτή η μέθοδος εκπαίδευσης παρέχει στο μοντέλο ευελιξία και προσαρμοστικότητα, επιτρέποντάς του να λειτουργεί σε διάφορα σενάρια εφαρμογής.

Με αυτόν τον τρόπο, το RecurrentGemma-2B γίνεται ένα ισχυρό μοντέλο γλώσσας ικανό να παρέχει αποτελεσματική και ακριβή επεξεργασία γλώσσας σε ποικίλες εργασίες και περιβάλλοντα.

Η αυτοματοποιημένη συγκριτική αξιολόγηση είναι το πρώτο βήμα για την αξιολόγηση της απόδοσης του RecurrentGemma-2B. Αυτά τα τεστ καλύπτουν μια ποικιλία δημοφιλών εργασιών κατάντη, συμπεριλαμβανομένων, ενδεικτικά, της απάντησης σε ερωτήσεις, της σύνοψης κειμένου, του γλωσσικού συλλογισμού και άλλων. Η απόδοση του RecurrentGemma-2B σε αυτές τις εργασίες συγκρίνεται με το Gemma-2B και τα αποτελέσματα δείχνουν ότι παρόλο που το RecurrentGemma-2B εκπαιδεύεται σε μικρότερο αριθμό διακριτικών, η απόδοσή του είναι συγκρίσιμη με το Gemma-2B.

Η απόδοση του RecurrentGemma-2B σε πολλαπλά ακαδημαϊκά σημεία αναφοράς, όπως το MMLU 5-shot, HellaSwag 0-shot, PIQA 0-shot, κ.λπ. είναι παρόμοια με το Gemma-2B, γεγονός που αποδεικνύει την ευελιξία και την αποτελεσματικότητά του σε διαφορετικές εργασίες. Αυτά τα αποτελέσματα δοκιμών όχι μόνο καταδεικνύουν τη σε βάθος κατανόηση της γλώσσας του μοντέλου, αλλά αντικατοπτρίζουν επίσης τις δυνατότητές του σε πρακτικές εφαρμογές.

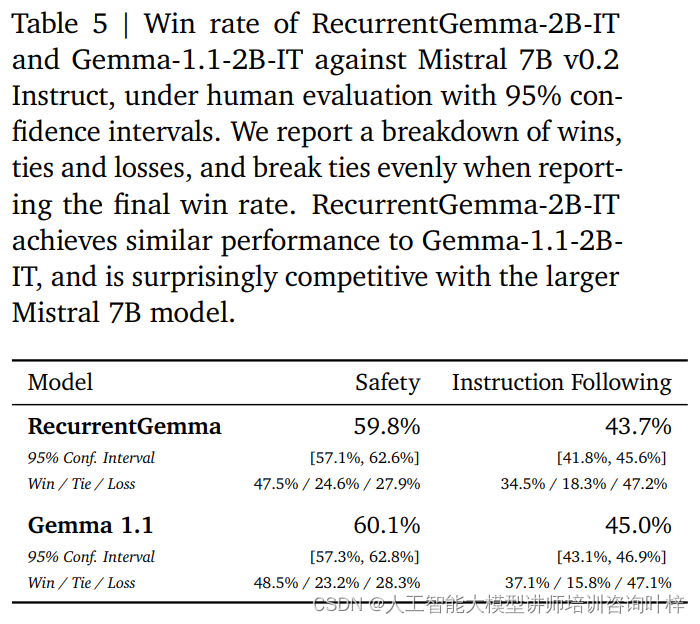

Εκτός από τα αυτοματοποιημένα σημεία αναφοράς, το RecurrentGemma-2B έχει δοκιμαστεί έναντι ανθρώπινης αξιολόγησης. Η ανθρώπινη αξιολόγηση είναι ένα κρίσιμο βήμα για την αξιολόγηση του εάν ένα γλωσσικό μοντέλο μπορεί να δημιουργήσει απαντήσεις που ανταποκρίνονται στις ανθρώπινες προσδοκίες. Σε αυτή τη διαδικασία, μια παραλλαγή του RecurrentGemma-2B (RecurrentGemma-2B-IT) που έχει συντονιστεί με οδηγίες συγκρίθηκε με το μοντέλο Mistral 7B v0.2 Instruct.

Οι ανθρώπινες αξιολογήσεις χρησιμοποιούν μια συλλογή περίπου 1.000 οδηγιών που πρέπει να ακολουθηθούν για εργασίες δημιουργικής γραφής και κωδικοποίησης. Το RecurrentGemma-2B-IT απέδωσε εντυπωσιακά σε αυτό το σετ, επιτυγχάνοντας ποσοστό νίκης 43,7%, ελαφρώς χαμηλότερο από το 45,0% της Gemma-1.1-2B-IT. Αυτό το αποτέλεσμα καταδεικνύει ότι η ικανότητα του RecurrentGemma-2B να κατανοεί και να εκτελεί πολύπλοκες οδηγίες είναι συγκρίσιμη με τα υπάρχοντα προηγμένα μοντέλα.

Το RecurrentGemma-2B-IT αξιολογήθηκε επίσης σε μια συλλογή περίπου 400 προτροπών που δοκιμάζουν βασικά πρωτόκολλα ασφαλείας, επιτυγχάνοντας ποσοστό νίκης 59,8%, αποδεικνύοντας την υπεροχή του μοντέλου όσον αφορά την τήρηση των κατευθυντήριων οδηγιών ασφαλείας.

Η απόδοση του RecurrentGemma-2B δοκιμάστηκε διεξοδικά μέσω ενός συνδυασμού αυτοματοποιημένων σημείων αναφοράς και ανθρώπινης αξιολόγησης. Οι αυτοματοποιημένες δοκιμές παρέχουν μια ποσοτική αξιολόγηση της απόδοσης του μοντέλου σε διάφορες γλωσσικές εργασίες, ενώ η ανθρώπινη αξιολόγηση παρέχει μια ποιοτική κατανόηση της ποιότητας της παραγωγής του μοντέλου. Αυτή η ολοκληρωμένη προσέγγιση αξιολόγησης διασφαλίζει ότι το RecurrentGemma-2B όχι μόνο αποδίδει καλά στη θεωρία, αλλά παρέχει επίσης παραγωγή γλωσσών υψηλής ποιότητας και κατανόηση σε πρακτικές εφαρμογές.

Η ταχύτητα εξαγωγής συμπερασμάτων είναι μία από τις βασικές μετρήσεις για τη μέτρηση της χρησιμότητας ενός γλωσσικού μοντέλου, ειδικά όταν πρόκειται για δεδομένα μεγάλης ακολουθίας. Η βελτιστοποίηση της ταχύτητας συμπερασμάτων του RecurrentGemma-2B είναι ένα χαρακτηριστικό που το διακρίνει από το παραδοσιακό μοντέλο Transformer. Στο παραδοσιακό μοντέλο Transformer, για αποτελεσματική επεξεργασία ακολουθίας, το μοντέλο πρέπει να ανακτήσει και να φορτώσει την κρυφή μνήμη κλειδιού-τιμής (KV) στη μνήμη της συσκευής. Καθώς το μήκος της ακολουθίας αυξάνεται, το μέγεθος της κρυφής μνήμης KV θα αυξάνεται επίσης γραμμικά, γεγονός που όχι μόνο αυξάνει τη χρήση της μνήμης, αλλά περιορίζει επίσης την ικανότητα του μοντέλου να χειρίζεται μεγάλες ακολουθίες. Αν και το μέγεθος της κρυφής μνήμης μπορεί να μειωθεί μέσω μηχανισμών τοπικής προσοχής, αυτό συνήθως έρχεται σε βάρος ορισμένων επιδόσεων.

Το RecurrentGemma-2B λύνει τα παραπάνω προβλήματα μέσω του καινοτόμου αρχιτεκτονικού σχεδιασμού του. Συμπιέζει την ακολουθία εισόδου σε μια κατάσταση σταθερού μεγέθους αντί να βασίζεται σε μια κρυφή μνήμη KV που μεγαλώνει με το μήκος της ακολουθίας. Αυτός ο σχεδιασμός μειώνει σημαντικά τη χρήση της μνήμης και επιτρέπει στο μοντέλο να διατηρεί αποτελεσματική ταχύτητα συμπερασμάτων κατά την επεξεργασία μεγάλων ακολουθιών.

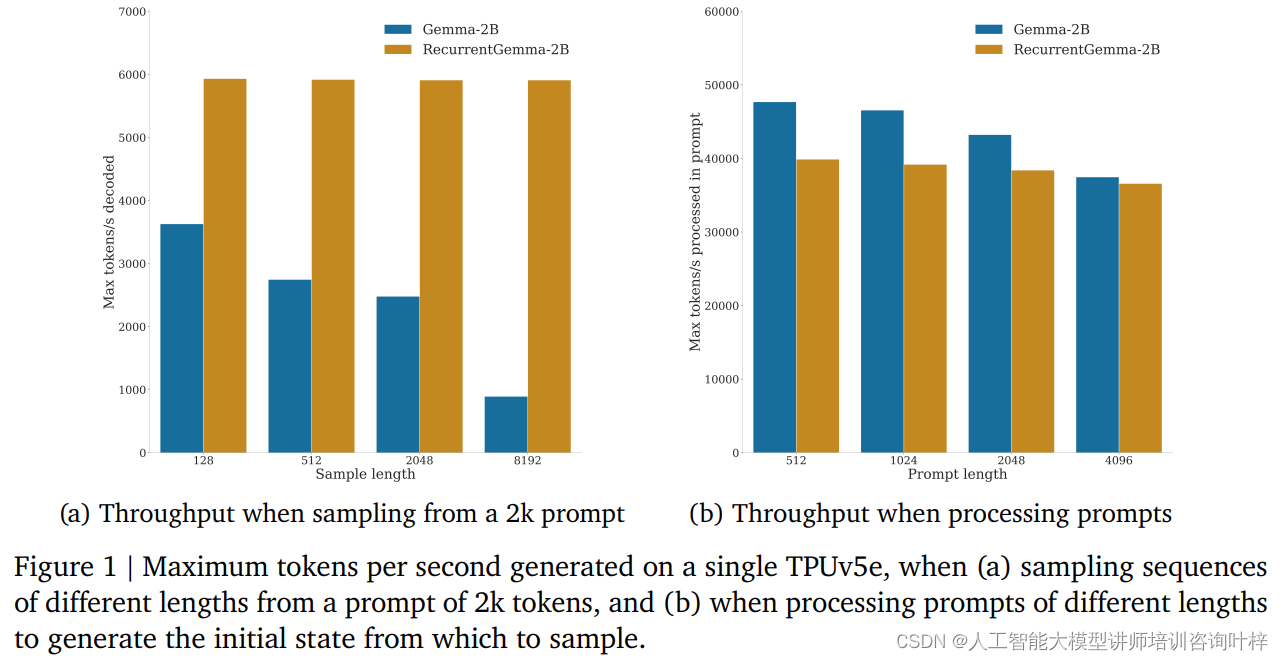

Σε δοκιμές αναφοράς, το RecurrentGemma-2B έδειξε σημαντικά πλεονεκτήματα απόδοσης. Όπως φαίνεται στο Σχήμα 1α, σε μια μεμονωμένη συσκευή TPUv5e, το RecurrentGemma-2B είναι σε θέση να επιτύχει απόδοση έως και 6k tokens ανά δευτερόλεπτο κατά τη δειγματοληψία ακολουθιών διαφορετικού μήκους από μια υπόδειξη 2k tokens, ενώ το μοντέλο Gemma μεγαλώνει καθώς η κρυφή μνήμη μεγαλώνει. Η απόδοση μειώνεται.

Το σταθερό μέγεθος κατάστασης του RecurrentGemma-2B είναι το κλειδί για την αποτελεσματική εξαγωγή του. Σε σύγκριση με το μοντέλο Gemma, η κατάσταση του RecurrentGemma-2B δεν αυξάνεται με το μήκος της ακολουθίας, πράγμα που σημαίνει ότι μπορεί να δημιουργήσει ακολουθίες οποιουδήποτε μήκους χωρίς να περιορίζεται από το μέγεθος της μνήμης του κεντρικού υπολογιστή. Αυτό είναι ιδιαίτερα σημαντικό στην επεξεργασία μακράς ακολουθίας, καθώς επιτρέπει στο μοντέλο να επεξεργάζεται μεγαλύτερα δεδομένα κειμένου διατηρώντας παράλληλα υψηλή απόδοση.

Η βελτίωση της ταχύτητας συλλογιστικής δεν έχει μόνο μεγάλη σημασία στη θεωρία, αλλά δείχνει και την αξία της σε πρακτικές εφαρμογές. Σε περιβάλλοντα με περιορισμένους πόρους, όπως κινητές συσκευές ή υπολογιστικές συσκευές αιχμής, η υψηλή απόδοση και το χαμηλό αποτύπωμα μνήμης του RecurrentGemma-2B το καθιστούν ιδανική επιλογή. Επιπλέον, η αποτελεσματική ταχύτητα συμπερασμάτων επιτρέπει επίσης στο μοντέλο να ανταποκρίνεται στα αιτήματα των χρηστών πιο γρήγορα και να παρέχει μια πιο ομαλή διαδραστική εμπειρία.

Στον τομέα της τεχνητής νοημοσύνης, η ανάπτυξη μοντέλων δεν είναι μόνο η υλοποίηση της τεχνολογίας, αλλά και η ανάληψη ασφάλειας και ηθικών ευθυνών. Η στρατηγική ανάπτυξης του RecurrentGemma-2B αντικατοπτρίζει πλήρως την έμφαση σε αυτούς τους βασικούς παράγοντες.

Πριν από την ανάπτυξη του μοντέλου, το RecurrentGemma-2B υποβλήθηκε σε μια σειρά τυπικών κριτηρίων αξιολόγησης ακαδημαϊκής ασφάλειας που σχεδιάστηκαν για την αξιολόγηση πιθανής ανάρμοστης συμπεριφοράς ή μεροληψίας από το μοντέλο. Μέσω αυτών των δοκιμών, η ομάδα ανάπτυξης είναι σε θέση να εντοπίσει και να μετριάσει πιθανούς κινδύνους, διασφαλίζοντας ότι το μοντέλο είναι ασφαλές για δημόσια χρήση.

Εκτός από την αυτοματοποιημένη συγκριτική αξιολόγηση ασφαλείας, το RecurrentGemma-2B υποβλήθηκε σε αξιολόγηση δεοντολογίας και ασφάλειας από μια ανεξάρτητη ομάδα. Αυτή η διαδικασία περιλαμβάνει μια ολοκληρωμένη αναθεώρηση του μοντέλου, συμπεριλαμβανομένης, ενδεικτικά, της δικαιοσύνης του σε συγκεκριμένες ομάδες, της ικανότητάς του να αποφεύγει επιβλαβή αποτελέσματα και της προστασίας του απορρήτου των χρηστών.

Παρά τις αυστηρές δοκιμές και αξιολόγηση, η ομάδα ανάπτυξης τονίζει ότι είναι αδύνατο να καλυφθούν όλες οι πιθανές περιπτώσεις χρήσης, δεδομένου ότι το RecurrentGemma-2B μπορεί να εφαρμοστεί σε πολλά διαφορετικά σενάρια. Ως εκ τούτου, συνιστούν σε όλους τους χρήστες να πραγματοποιούν πρόσθετες δοκιμές ασφαλείας με βάση τις συγκεκριμένες περιπτώσεις χρήσης τους πριν από την ανάπτυξη μοντέλων. Αυτή η σύσταση αντικατοπτρίζει την έμφαση στην ευθύνη του χρήστη για να διασφαλιστεί ότι κάθε ανάπτυξη είναι καλά μελετημένη και προσαρμοσμένη.

Η υπεύθυνη ανάπτυξη περιλαμβάνει επίσης διαφάνεια σχετικά με την απόδοση και τους περιορισμούς του μοντέλου. Η ομάδα ανάπτυξης παρέχει λεπτομερείς λεπτομέρειες αρχιτεκτονικής και εκπαίδευσης μοντέλων για να μπορέσουν οι χρήστες και οι ερευνητές να κατανοήσουν πώς λειτουργεί το μοντέλο και πιθανούς περιορισμούς. Επιπλέον, η ομάδα έχει δεσμευτεί για συνεχή παρακολούθηση και βελτίωση του μοντέλου για την αντιμετώπιση αναδυόμενων κινδύνων και προκλήσεων.

Η υπεύθυνη ανάπτυξη περιλαμβάνει επίσης συνεργασία με την ευρύτερη κοινότητα τεχνητής νοημοσύνης και πολλούς ενδιαφερόμενους φορείς. Μοιράζοντας τα αποτελέσματα της έρευνας, συμμετέχοντας σε ανοιχτές συζητήσεις και αποδεχόμενοι εξωτερικά σχόλια, η ομάδα ανάπτυξης του RecurrentGemma αποδεικνύει τη δέσμευσή της στην ανοιχτή επιστήμη και τη συνεργασία.

Καθώς ο τομέας της τεχνητής νοημοσύνης συνεχίζει να επεκτείνεται, το RecurrentGemma χρησιμεύει ως μοντέλο που συνδυάζει καινοτόμες ιδέες αρχιτεκτονικού σχεδιασμού, αυστηρές διαδικασίες εκπαίδευσης και αξιολόγησης, επιδεικνύοντας τη δυνατότητα να ωθήσει τα όρια του τι είναι δυνατό στην κατανόηση και τη δημιουργία γλωσσών.

Σύνδεσμος χαρτιού: https://arxiv.org/abs/2404.07839