2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Vector datorum nucleus pars cognitionis hodiernae magnae-exemplaris basis retrievalis praxis

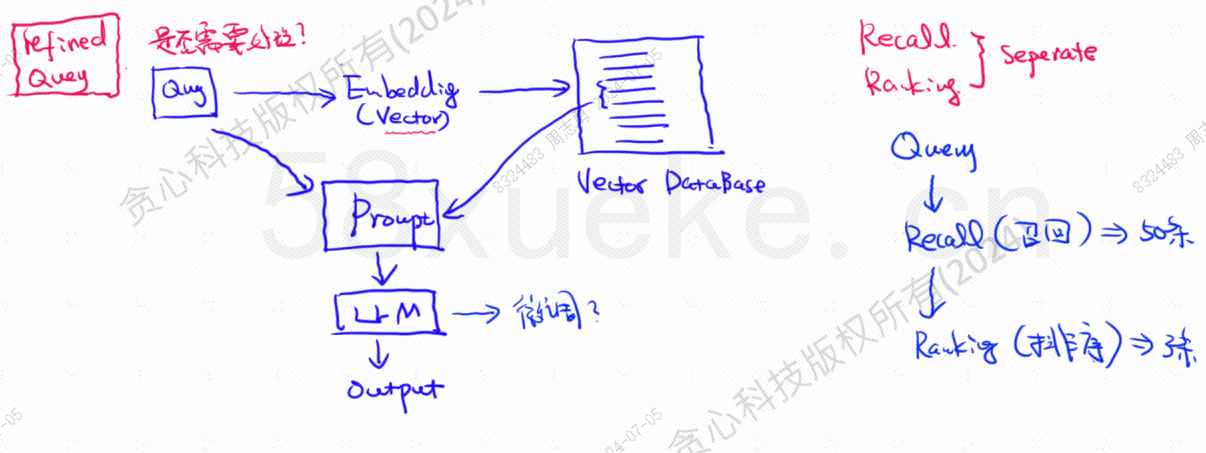

Similitudo inter interrogationis notae vectoris et interrogationis qualitatem prompti directe afficit. Hic articulus brevius introducet vectorem databases existentium in foro, ac deinde methodos indices in eis adhibitos explicabimus, incluso indice inverso, KNN, Approximato KNN, Producto Quantization, HSNW, etc., notiones et methodos horum algorithmorum designabit.

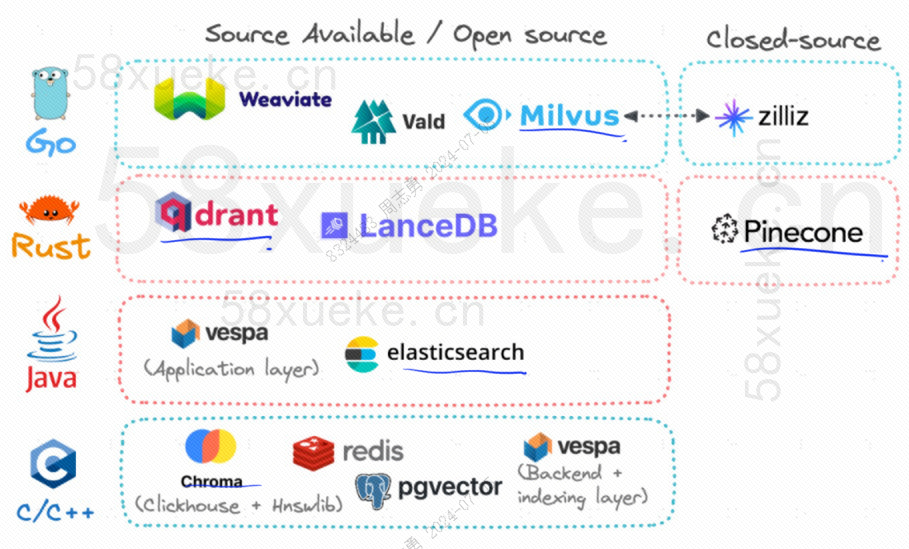

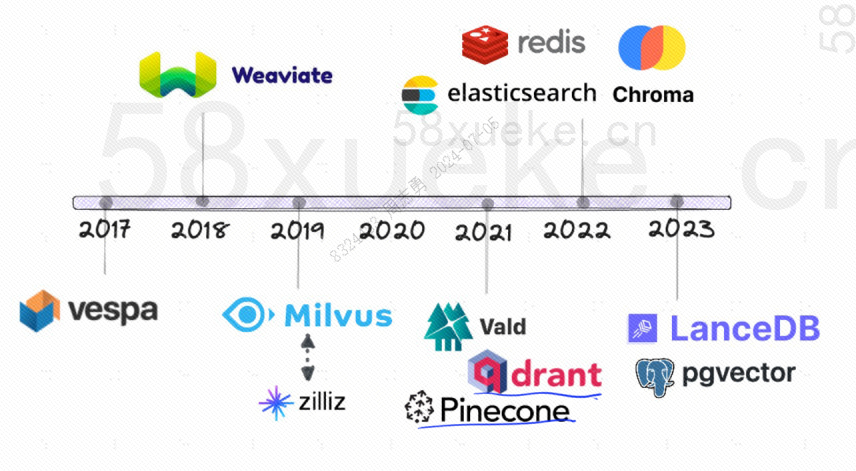

Nunc, tres vector databases populares aperti sunt Chroma, Milvus et Weaviate. Puto hunc articulum de eorum introductione et differentiis bonum esse.Competition in tribus maioribus vector databases fons aperto。

Sequens est historia evolutionis databases aperti fontis vectoris:

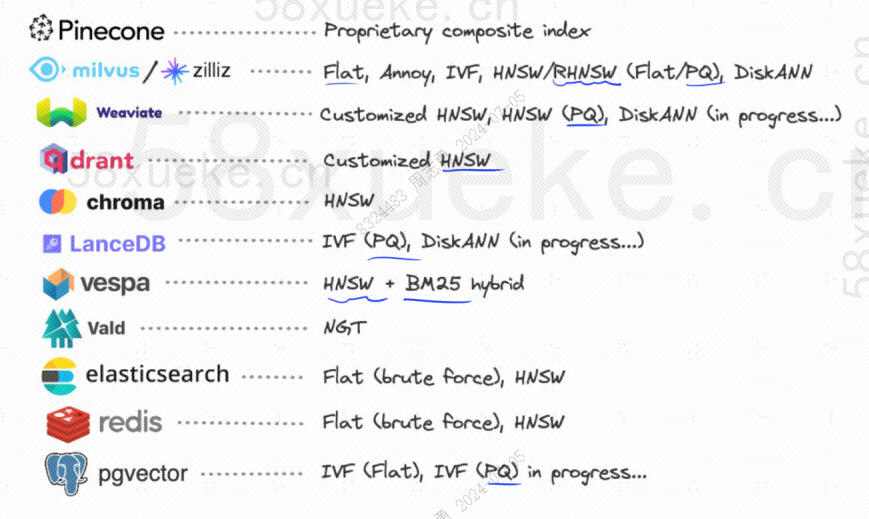

Modi indexing quibus utantur sunt hae:

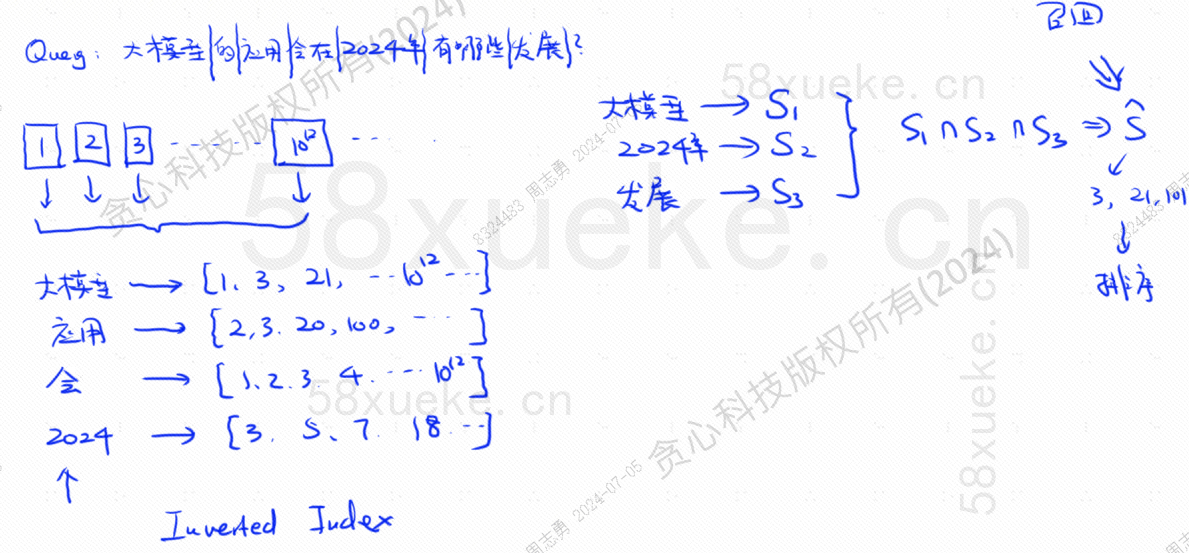

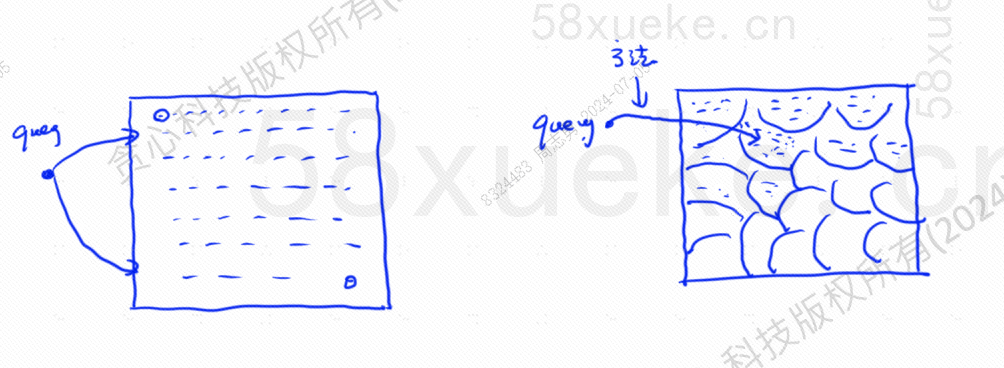

Si nunc habes database quod inverso indice utitur, qui indicem notarum 10^12 reponit, cum notitias in datorum reponemus, notitias scindemus, tum verba verbis scindendi respondentia memorabimus positionibus?

Esto nunc mihi quaesitum: Quas explicationes applicatio exemplorum magnorum in 2024 habebit?

Database interrogationis nostrae enuntiationem in tria verba clavis clavis dividit: magnum exemplar, 2024, evolutionis.Tunc quaesitum est indicem coniunctionis singulis verbis respondentem et intersectionem invenirerevocemus.

Hoc tempore notitia cum interrogatione consociata nacti sumus, sed similitudo inter haec data et interrogationis enuntiatio alia est.

Sed hoc genus interrogationis quae cum indice notitiae textui directe respondet, non est valde efficax.

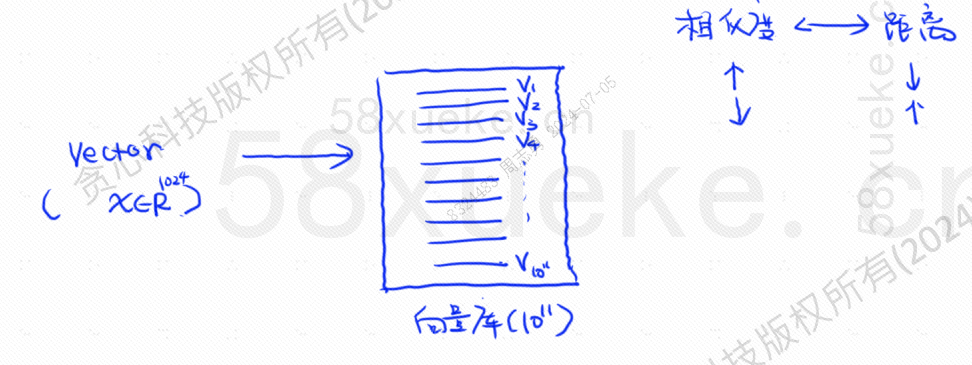

Hoc tempore, vectorizata retrievalis apparuit, data in vectores convertens et vector computanssimilitudoetproculQuaere duobus modis:

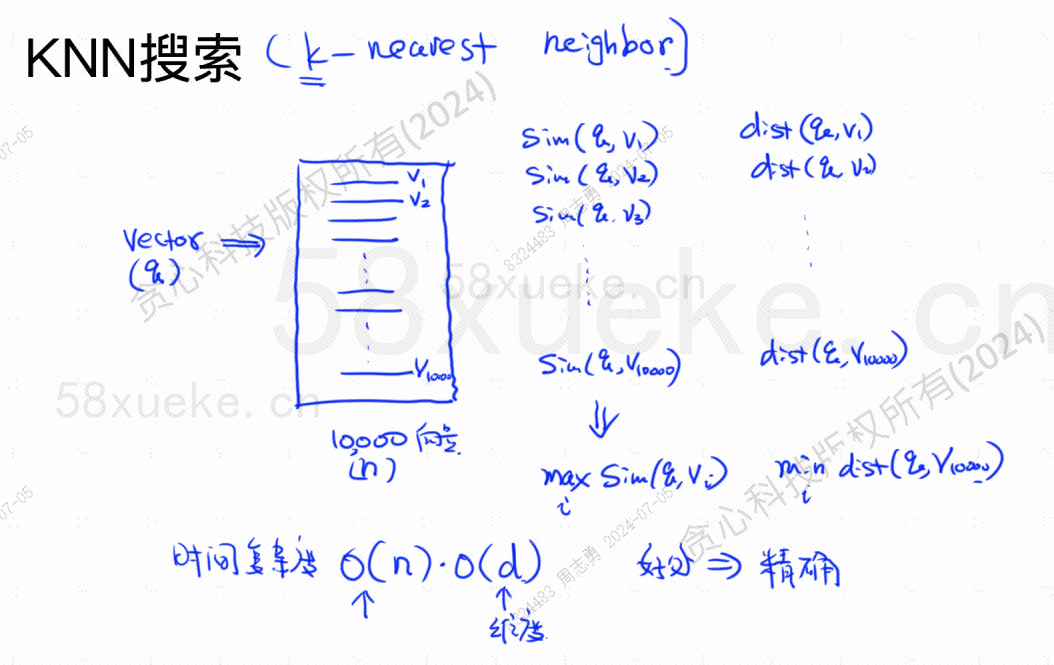

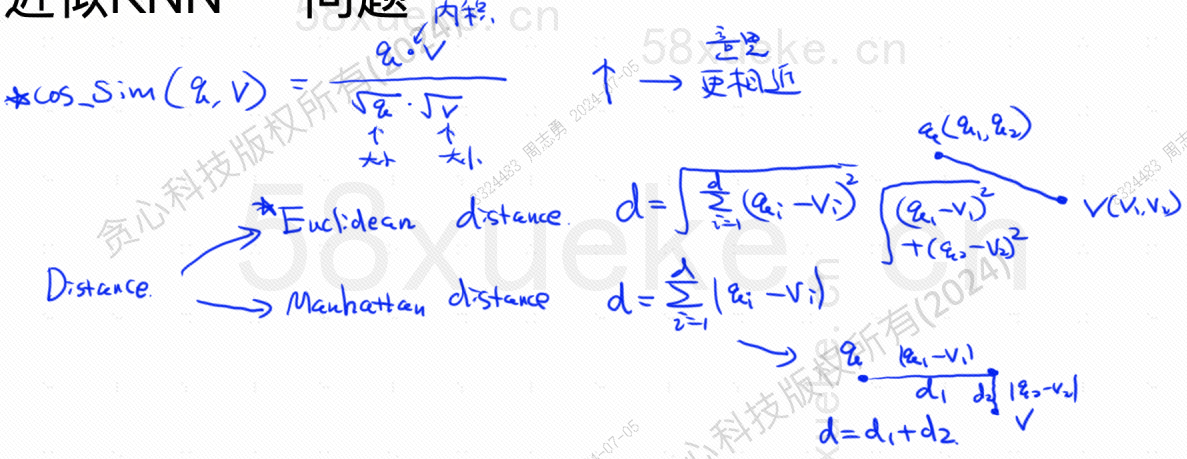

KNN quaesitum dicitur K quaesitum vicinum proximum. Is enuntiationem interrogationis in vectorem vertit, ac deinde vector et vector in datorum invenit.Similitudo summa et maxima distantiavector posuit.

Tempus multiplicitatis est O(N)*O(d), d dimensio est, et notitia dimensiva plerumque fixa est. Pone quod 10,000 vector data in datorum reposita sunt, et dimensiones omnes 1024, tunc quaesitum est maxSim(q,v)(similitudo summa)minDist(q,v)Tempus complexionis vectoris est O(10000)*O (1024).

Commodum huius retrievalis methodi est quod notitia valde accurata inventa est, sed incommodum est quod tarda est.

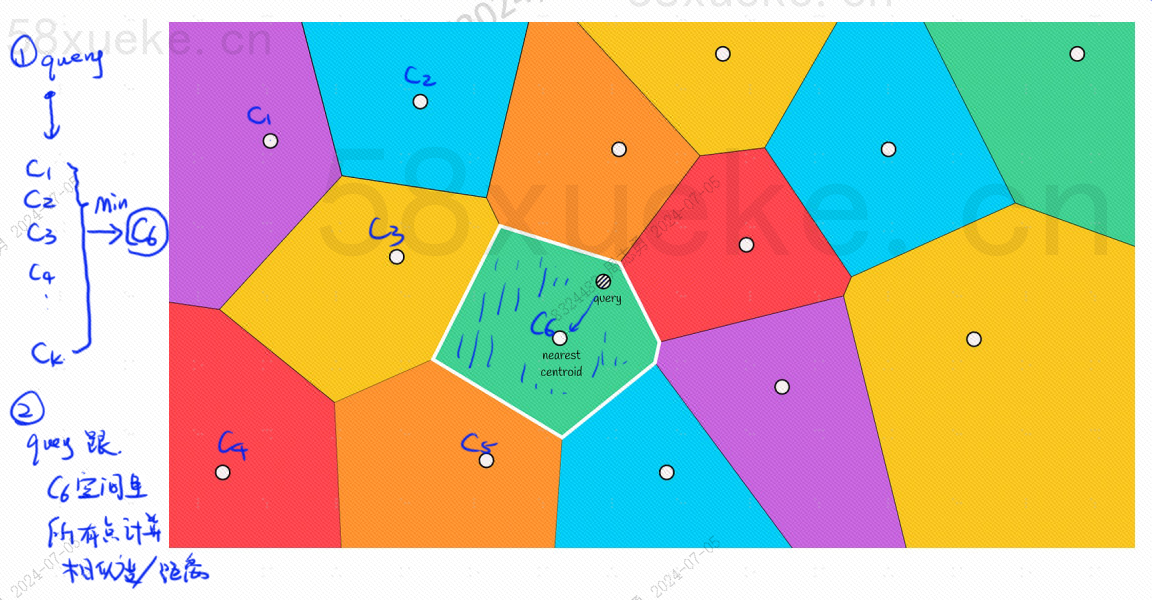

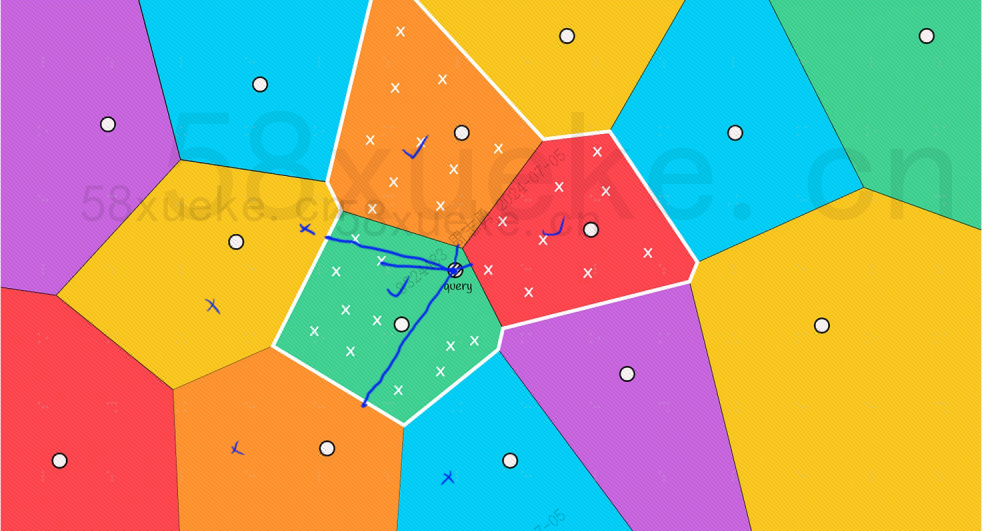

Investigatio approximata KNN est quaerere spatium a punctis ad caudices mutare. Primum truncum arctissimum determinare, deinde punctum artissimum cum summa similitudine in spatio rapido invenire approximare.

Centrum punctum in quolibet stipite erit. Distantiam inter punctum interrogationis et scandalum computare distantiam a puncto interrogationis ad punctum centri cuiusque scandali;

Exempli causa, vestigia interrogationis in imagine superiore sunt hae:

Sed oculis nudo videre possumus quod, licet centra puncta rubri et aurei caudices longe absunt a puncto interrogationis, puncta in caudices appropinquant ad punctum interrogationis inquisitionis scandalum:

Haec algorithmus est formula summae similitudinis et artissimae distantiae inveniendae. Summa similitudo (COS_SIM) per cosinum computatur :

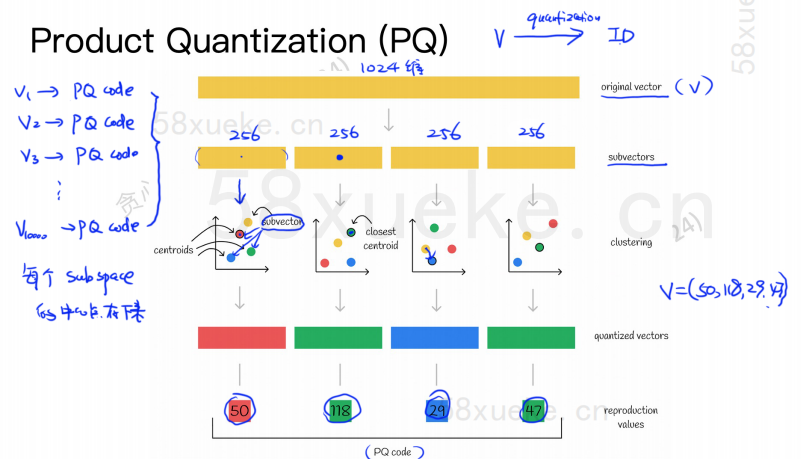

Algorithmus PQ primus omnes vectores in subspatia multiplex dividit.

Tunc summus dimensivus vector originalis in multiplices vectores subvectores humiles dimensionales scindetur, et centrum punctum proximum subvector adhibebitur ut PQ ID vectoris subvectionis componi ex pluribus PQ IDs, quae spatio valde compresso.

Verbi gratia, 1024-dimensionalis vector in superiore figura scinditur in quattuor 256 vectores sub-dimensionales, et proximiores centri horum quattuor subvectionum sunt: 50, 118, 29, 47; Ergo vector dimensiva 1024 per V=(50,118,29,47) repraesentari potest), eiusque PQ code quoque est (50,118,29,47).

Vector igitur database utens algorithmus PQ debet salvare informationes omnium punctorum centri et PQ codicem omnium vectorum summus dimensivarum.

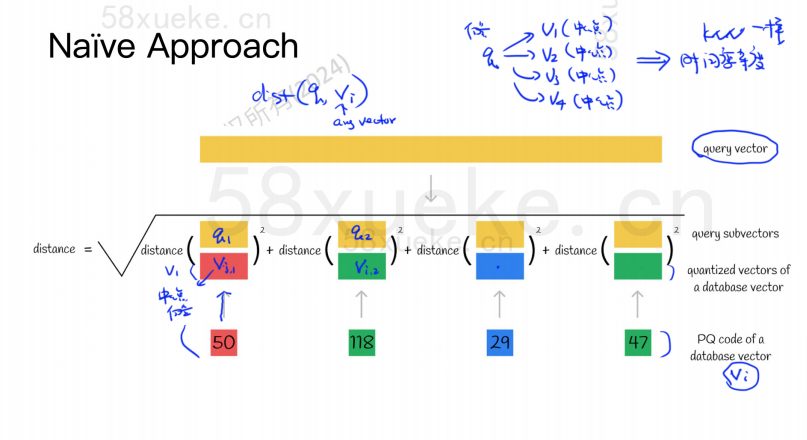

Esto nunc nobis interrogationi enuntiatum, quod vector cum summa similitudine vectoris datorum requirere debet.

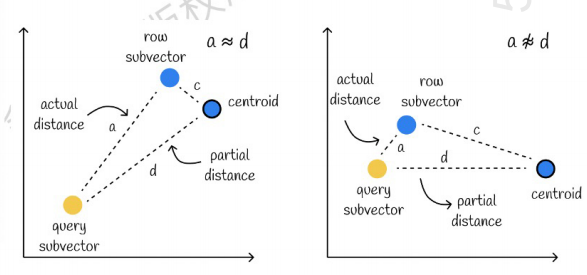

Alter a sinistris est ubi error minimus est, et alter a dextra est ubi error magnus est.

Uti caching accelerare calculations

Si vector et PQ codice primigenii cuiusque sub-vectoris exigunt distantiam calculi, non multum interest ab algorithmo approximato KNN algorithmus quid est? Estne justum ad compressionem et spatium repono reducens?

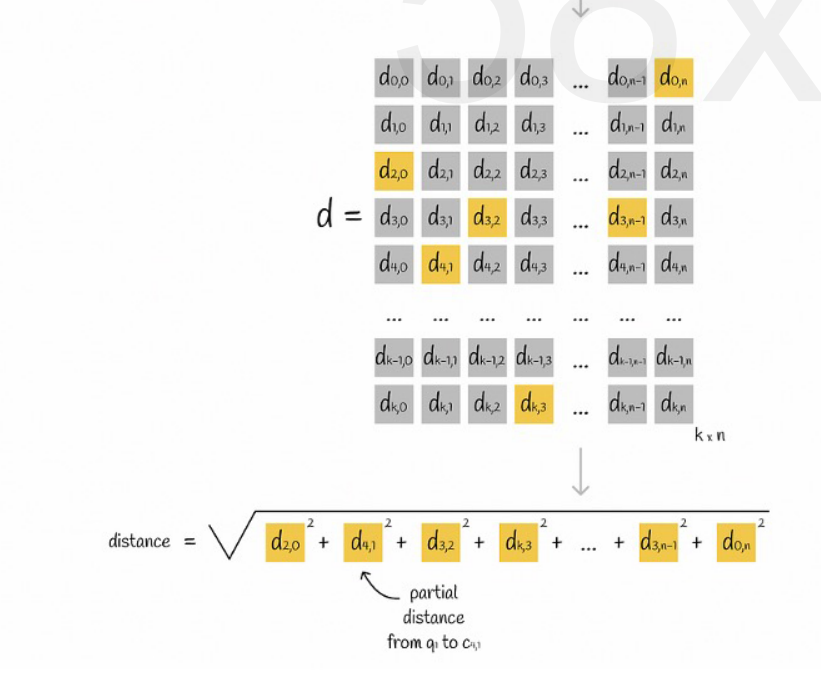

Pone omnes vectores in subspatia K dividi, et in singulis subspatiis puncta sunt n. correspondentiam investigare possumus distantiam ab unoquoque subvectio ad punctum centrum directe a matrice, ut in sequenti figura ostensum est:

Denique tantum opus est addere radices quadratas distantiarum cuiusque sub-vectoris.

Proximus KNN cum PQ algorithmo coniungitur

Haec duo algorithms non pugnant. Primum uti KNN approximatis uti potes ad omnes vectores in subspaces plures dividere, deinde vectorem interrogationi sub spatio respondente collocare.

Hoc modo algorithmus PQ adhibetur in spatio sub spatio ad calculum accelerandum.

In data vectoris statuto, K vectores (K-Proximi, KNN) qui prope vectorem quaesitum sunt, secundum certam mensurae modum restituit proximi, proximi (Proxime, Nearest).

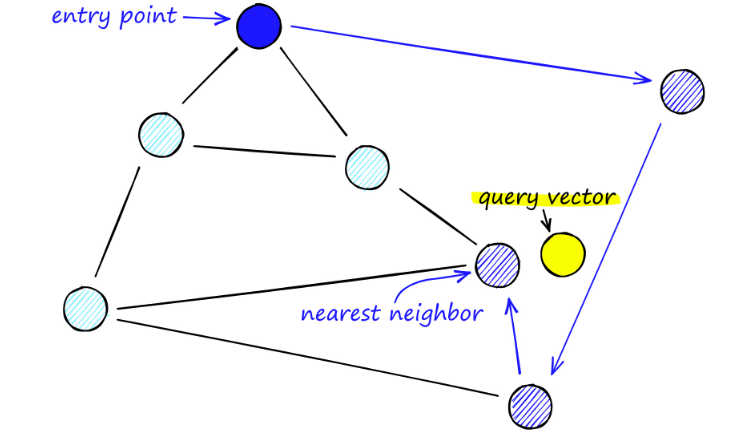

Cum pictura componens, passim NSW puncta eligit et ad picturam addit. Singulis diebus punctum additur, puncta m quaeruntur vicinis suis ad margines add. Postrema structura formatur ut in figura infra ostendetur;

Cum tabulas NSW quaerimus, ab ingressu praefinitis punctis incipimus. Hic aculeus pluribus vicinis vertices iungitur. Statuimus uter horum vertices proximus sit interrogationi nostrae vectoris et ibi moveatur.

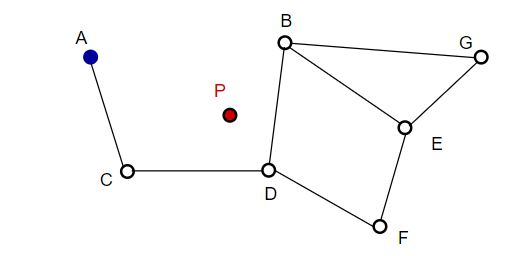

Exempli gratia, ab A, puncto A finitimo C propius ad P renovatur. Tunc punctum D vicinum ipsius C appropinquat ipsi P, et puncta vicina B, F ipsius D non sunt propinquiora, et progressio cessat, quod est punctum D.

Aliquam lacinia purus a massa suscipit consequat. Semel in grapho algorithmus avide percurrit margines ad inveniendum proximum ef vicinum vectori q inseruimus - hoc tempore ef = 1 .

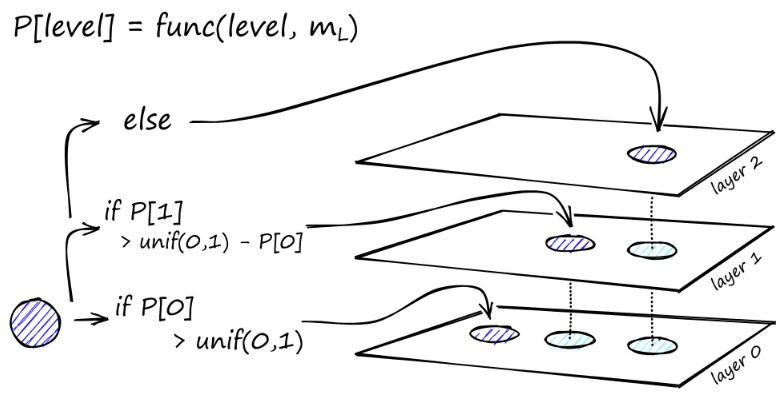

Cum minimum locale inventum est, ad gradum proximum descendit (sicut factum est in inquisitione). Hoc processum iterare donec ad insertionem electionis nostrae perveniat. Incipit secunda pars constructionis.

Valor ef augetur ad efConstructionem parametri constituendi, quae significat viciniores proximiores reddetur. In secundo gradu, hi proximi vicini candidati sunt nexus elementi noviter inserti q et puncta in altera tabulato ingressu inserviunt.

Post multas iterationes, duo plures parametri sunt considerandi nexus additi. M_max, quod maximum numerum nexuum verticem habere potest, et M_max0, quod maximum numerum nexuum pro vertice in lamina 0 definit.

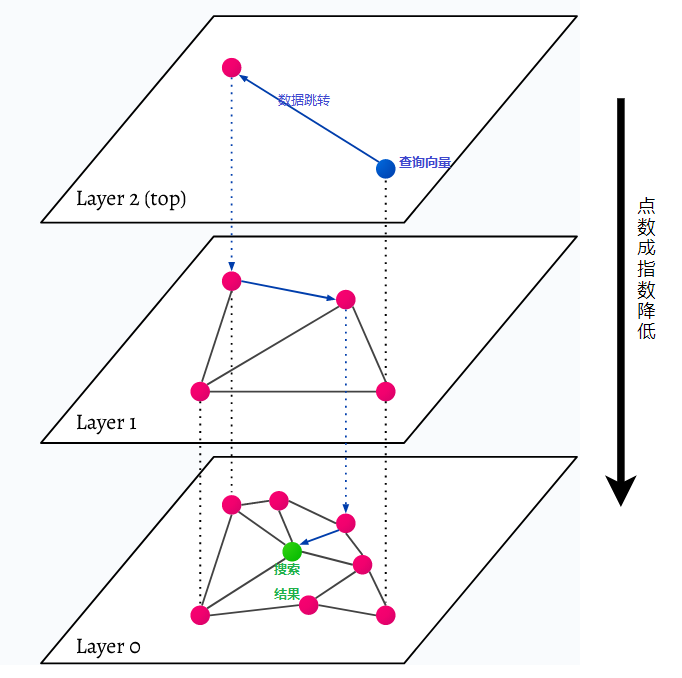

HNSW stands for Hierarchicus Navigabilis Orbis Parvus, graphi multi-strati. Omne objectum datorum in ultimo (gradu 0 in pictura) capitur. Haec notitia rerum optime connexa sunt. In unoquoque tabulato supra imum stratum, pauciora puncta data repraesentantur. Haec puncta data inferioribus stratis aequant, sed in singulis stratis superiori puncta pauciora sunt exponentialiter. Si quaesitum est, maxima notitia punctorum in summo gradu invenientur. In exemplo infra, hoc solum unum punctum notitiae. Deinde pergit unum gradum altius ac notitias arctissimas invenit a primo qui in summo gradu invenit et inde proximos perquirit. In profundissimo gradu, notitia actualis obiecti proxima inquisitionis quaerendae invenietur.

HNSW velocissima est et memoria efficientis similitudinis quaerendi methodum, quia sola tabulata suprema (top iacuit) conservata est in cella quam omnia puncta in infimo iacuit. Tantum puncta notitiae proximae investigationi quaestioni onerata sunt, postquam a superioribus stratis petita sunt, tantum parvae memoriae copia reservandum est.