2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Am 3. Juli 2024 veröffentlichten das Shanghai Artificial Intelligence Laboratory und SenseTime zusammen mit der Chinese University of Hong Kong und der Fudan University offiziell die neue Generation des großen Sprachmodells Puyu 2.5 (InternLM2.5). Im Vergleich zum Modell der Vorgängergeneration weist InternLM2.5 drei herausragende Highlights auf:

Die Argumentationsfähigkeit wurde erheblich verbessert, führt inländische und ausländische Open-Source-Modelle in der gleichen Größenordnung an und übertrifft Llama3-70B in einigen Dimensionen sogar um das Zehnfache.

Unterstützt 1 Million Token-Kontext und kann Millionen von Wörtern langen Text verarbeiten;

Es verfügt über leistungsstarke unabhängige Planungs- und Tool-Aufruffunktionen. Es kann beispielsweise Hunderte von Webseiten durchsuchen und integrierte Analysen für komplexe Probleme durchführen.

Das InternLM2.5-7B-Modell ist heute als Open Source verfügbar, größere und kleinere Modelle werden in naher Zukunft veröffentlicht. Das Shanghai Artificial Intelligence Laboratory hält an dem Konzept fest, „Innovationen durch kontinuierlich hochwertige Open-Source-Modelle zu ermöglichen“, während es der Community weiterhin qualitativ hochwertige Open-Source-Modelle zur Verfügung stellt, aber auch weiterhin an der kostenlosen kommerziellen Lizenzierung festhält.

GitHub-Link:GitHub - InternLM/InternLM: Offizielle Veröffentlichung von InternLM2.5 7B-Basis- und Chatmodellen. 1M-Kontextunterstützung HuggingFace-Modell:https://huggingface.co/internlm

Scholar·Puyu-Homepage:Gelehrter·Puyu

Mit der rasanten Entwicklung großer Modelle werden auch die von Menschen gesammelten Daten schnell verbraucht. Die effiziente Verbesserung der Modellleistung ist derzeit zu einer großen Herausforderung geworden. Zu diesem Zweck haben wir ein neues synthetisches Daten- und Modellschwungrad entwickelt. Einerseits nutzen wir synthetische Daten, um den Mangel an qualitativ hochwertigen Daten vor Ort auszugleichen Fehlerbeseitigung durch Selbstiteration des Modells, wodurch InternLM2.5 die Iterationen erheblich beschleunigt.

Für unterschiedliche Datenmerkmale haben wir verschiedene Lösungen für die Datensynthesetechnologie entwickelt, um die Qualität verschiedener Arten synthetischer Daten sicherzustellen, einschließlich regelbasierter Datenkonstruktion, modellbasierter Datenerweiterung und rückkopplungsbasierter Datengenerierung.

Während des Entwicklungsprozesses wird das Modell selbst kontinuierlich zur Modelliteration verwendet. Basierend auf dem aktuellen Modell haben wir einen Multiagenten für das Screening, die Auswertung und die Annotation von Daten entwickelt, der die Qualität und Vielfalt der Daten erheblich verbessert hat. Gleichzeitig wird das Modell auch zur Erstellung und Verfeinerung neuer Korpusse verwendet, sodass das Modell die während des Trainingsprozesses entdeckten Probleme beheben kann.

Eine leistungsstarke Denkfähigkeit ist eine wichtige Grundlage für große Modelle, um zu allgemeiner künstlicher Intelligenz zu führen. InternLM2.5 optimiert die Denkfähigkeit als Kernfähigkeit des Modells und bietet eine gute Grundlage für die Anwendung komplexer Szenarien.

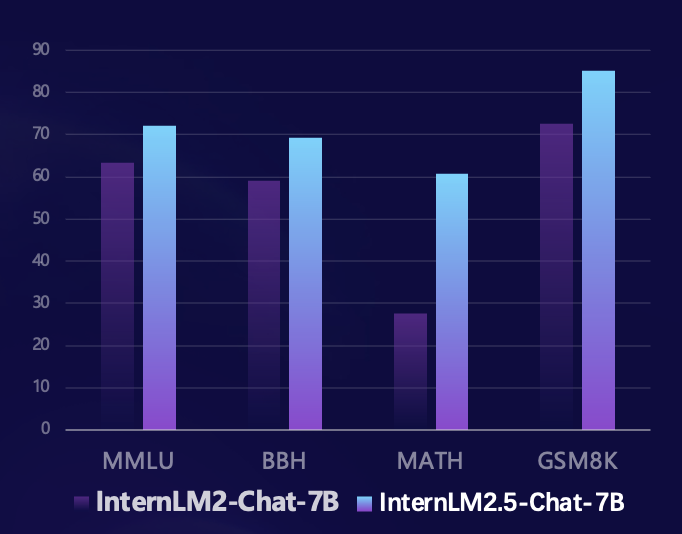

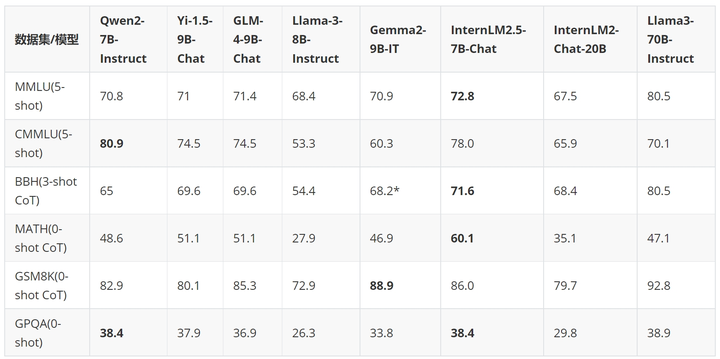

Basierend auf dem Open-Source-Bewertungsframework Sinan OpenCompass nutzte das Forschungsteam eine einheitliche und reproduzierbare Bewertungsmethode, um Bewertungen für mehrere maßgebliche Bewertungssätze von Argumentationsfähigkeiten durchzuführen. Im Vergleich zum Modell der vorherigen Generation hat InternLM2.5 erhebliche Leistungsverbesserungen bei mehreren maßgeblichen Bewertungssätzen der Argumentationsfähigkeiten erzielt. Insbesondere wurde der aus Wettbewerbsproblemen bestehende Mathematikbewertungssatz MATH um 100 % verbessert und erreichte 60 % mit 7B-Parametern Die Genauigkeitsrate (die das Niveau der GPT-4 Turbo 1106-Version erreicht) zeigt voll und ganz die hervorragende Leistung des Modells im mathematischen Denken.

In den letzten Monaten hat sich die Open-Source-Community für große Modelle rasant entwickelt und eine große Anzahl hervorragender Modelle ist entstanden. Im Vergleich zu den neuesten Open-Source-Modellen im In- und Ausland liegt InternLM2.5-7B-Chat in den meisten Inferenzbewertungssätzen vor Modellen der gleichen Größenordnung In einigen Fällen übertrifft es in seinen Abmessungen sogar das zehnmal größere Llama3-70B-Instruct.

Anhand eines Beispiels demonstrieren wir die hervorragenden Argumentationsfähigkeiten von InternLM2.5.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

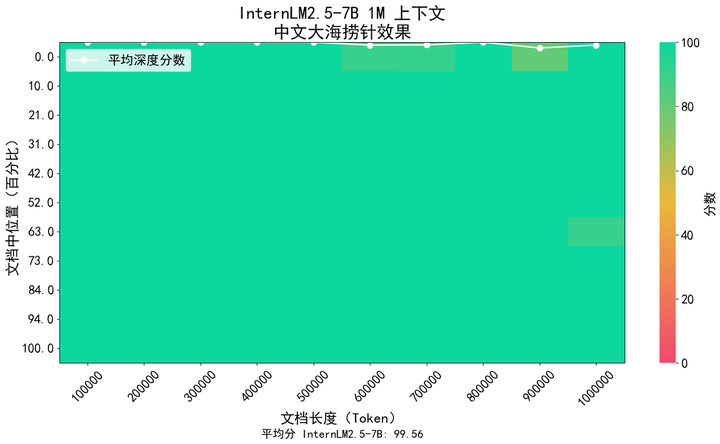

In Anwendungsszenarien wie langem Dokumentverständnis und komplexer Agenteninteraktion stellt die Kontextlängenunterstützung des Modells höhere Anforderungen. InternLM2.5 schlägt eine Lösung vor, die die Kontextlänge von 200 KB im Modell InternLM2 der vorherigen Generation auf 1 Million (ca. 1,2 Millionen chinesische Zeichen) erhöht und so das Potenzial des Modells für Anwendungen mit extrem langen Texten weiter freisetzt. Beim Vortraining des Modells haben wir 256K-Token-Längentexte aus dem natürlichen Korpus herausgefiltert. Gleichzeitig haben wir es mit synthetischen Daten ergänzt, um eine Domänenverschiebung zu vermeiden, die durch zu einzelne Korpustypen verursacht wird kann den Kontext erweitern, während seine Fähigkeiten so weit wie möglich erhalten bleiben.

Wir haben die in der Branche beliebte „Nadel im Heuhaufen“-Methode verwendet, um den Rückrufinhalt von Langtextinformationen des Modells zu bewerten. Die folgende Abbildung zeigt, dass InternLM 2.5 innerhalb des 1-M-Token-Bereichs eine nahezu perfekte Nadel im Heuhaufen erreicht hat, was einen extrem starken Langtext zeigt Verarbeitungsmöglichkeiten.

Darüber hinaus haben wir zur Bewertung auch das weit verbreitete Langtextverständnis-Bewertungsset LongBench verwendet. Die Ergebnisse zeigten, dass InternLM2.5 die beste Leistung erzielte.

| GLM4-9B-Chat-1M | Qwen2-7B-Anweisung | Yi1.5-9B-Chat | InternLM2.5-7B-Chat-1M | |

| Langbank | 46.5 | 41.2 | 37.2 | 47.4 |

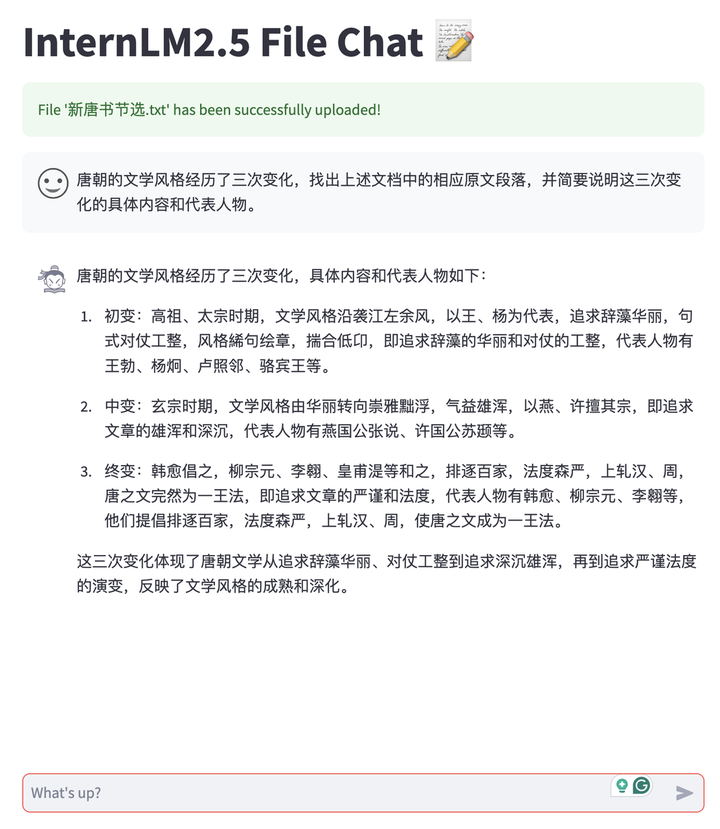

Basierend auf den Langtextfunktionen von InternLM2.5 haben wir eine Dokumentkonversationsanwendung entwickelt, die das privatisierte Bereitstellungsmodell der Benutzer und das kostenlose Hochladen von Dokumenten zur Konversation unterstützt. Und das gesamte System ist Open Source mit allen Links, sodass Benutzer es einfach mit einem Klick erstellen können, einschließlich LMDeploy-Backend-Unterstützung für Langtextbegründung, MinerU-Funktionen zum Parsen und Konvertieren mehrerer Dokumenttypen sowie Streamlit-basierten Front-End-Konversationserlebnistools , usw. Derzeit unterstützt es TXT-, Markdown- und PDF-Dokumente und wird auch in Zukunft verschiedene Office-Dokumenttypen wie Word und PPT unterstützen.

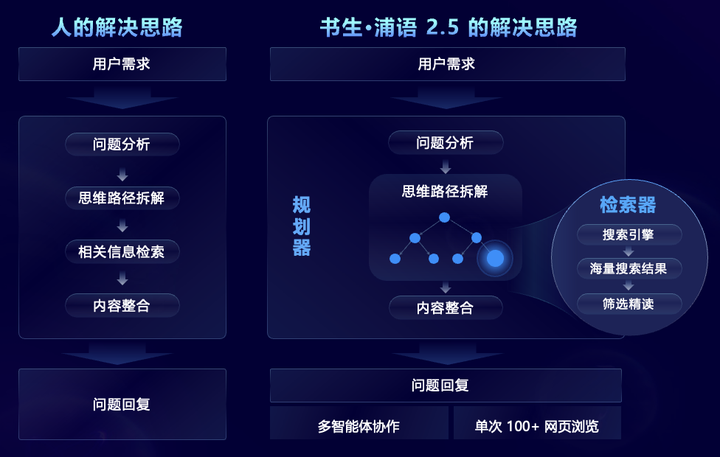

InternLM2.5 zielt auf komplexe Problemszenarien ab, die eine umfassende Suche und Integration komplexer Informationen erfordern, und schlägt auf innovative Weise das MindSearch-Multi-Agent-Framework vor, das den menschlichen Denkprozess simuliert und Aufgabenplanung, Aufgabenzerlegung, groß angelegte Websuche und Multi-Agenten einführt Zusammenfassung der Quellinformationen und andere Schritte zur effektiven Integration von Netzwerkinformationen. Unter anderem konzentriert sich der Planer auf die Aufgabenplanung, -zerlegung und -induktion, nutzt die Diagrammstrukturprogrammierung zur Planung und erweitert sich dynamisch entsprechend dem Aufgabenstatus. Der Sucher ist für die abweichende Suche und die Zusammenfassung der Netzwerksuchergebnisse verantwortlich, sodass das gesamte Framework dies kann basieren auf dem Filtern, Durchsuchen und Integrieren von Informationen aus Hunderten von Webseiten.

Dank erweiterter zielgerichteter Funktionen kann InternLM2.5 Informationen aus Hunderten von Webseiten effektiv filtern, durchsuchen und integrieren, um komplexe berufliche Probleme zu lösen, wodurch die Arbeit an der Zusammenfassung von Recherchen, die Menschen drei Stunden benötigen, auf drei Minuten verkürzt wird. Wie im Video unten gezeigt, kann das Modell bei mehrstufigen komplexen Problemen Benutzeranforderungen analysieren, zunächst nach den technischen Schwierigkeiten von Chang'e 6 suchen, dann nach entsprechenden Lösungen für jede technische Schwierigkeit suchen und dann nach der Mission suchen Ziele, technische Mittel, wissenschaftlich Vergleichen Sie den Mondlandeplan von Apollo 11 unter vier Aspekten: Ergebnisse und internationale Zusammenarbeit, und fassen Sie abschließend den Beitrag unseres Landes zum Erfolg der Monderkundung zusammen.

Scholar·Puyu 2.5 ist Open Source und setzt neue Maßstäbe in Sachen Denkfähigkeit

Zusätzlich zu Open-Source-Modellen hat Shusheng Puyu seit Juli letzten Jahres ein vollständiges Open-Source-Toolsystem für die Entwicklung und Anwendung großer Modelle eingeführt, das die sechs Hauptverbindungen Daten, Vorschulung, Feinabstimmung, Bereitstellung, Bewertung usw. abdeckt. und Anwendung. Diese Tools erleichtern Benutzern die Innovation und Anwendung großer Modelle und fördern den Wohlstand und die Entwicklung des Open-Source-Ökosystems für große Modelle. Mit der Veröffentlichung von InternLM2.5 wurde auch das gesamte Kettenwerkzeugsystem aktualisiert, die Anwendungsverknüpfungen erweitert und neue Werkzeuge für unterschiedliche Anforderungen bereitgestellt, darunter:

HuixiangDou Domain Knowledge Assistant (GitHub - InternLM/HuixiangDou: HuixiangDou: Gruppenchat-Szenarien mit LLM-basierter technischer Unterstützung bewältigen), speziell für die Bewältigung komplexer technischer Probleme in Gruppenchats entwickelt. Es ist für WeChat, Feishu, DingTalk und andere Plattformen geeignet. Es bietet vollständige Front-End- und Back-End-Web-, Android- und Algorithmus-Quellcodes und unterstützt industrietaugliche Anwendungen.

Intelligentes Datenextraktionstool MinerU (GitHub – opendatalab/MinerU: MinerU ist ein umfassendes, hochwertiges Open-Source-Datenextraktionstool, das die Extraktion von PDFs/Webseiten/E-Books unterstützt.), das für die Analyse multimodaler Dokumente entwickelt wurde, kann nicht nur multimodale PDF-Dokumente, einschließlich Bilder, Tabellen, Formeln usw., präzise in ein klares und leicht zu analysierendes Markdown-Format konvertieren, sondern auch verschiedene Störinformationen wie Werbung entfernen. Analysieren und extrahieren Sie schnell formale Inhalte aus Webseiten

Zusätzlich zum selbst entwickelten Full-Chain-Open-Source-Toolsystem unterstützt InternLM2.5 aktiv die Community, ist mit einer Vielzahl gemeinschaftlicher ökologischer Projekte kompatibel und „fängt alle“ Mainstream-Open-Source-Projekte ab.

Das Shanghai Artificial Intelligence Laboratory startete im Dezember letzten Jahres das Scholar·Puyu Large Model Practical Camp, das von der Community einstimmig gelobt wurde. In den letzten sechs Monaten haben insgesamt 150.000 Menschen an der Schulung und an mehr als 600 ökologischen Projekten teilgenommen sind geschlüpft. Anlässlich der Veröffentlichung von InternLM2.5 haben wir außerdem offiziell bekannt gegeben, dass das Shusheng·Puyu Large Model Practical Camp offiziell zum Scholar Large Model Practical Camp aufgewertet wurde und nach und nach weitere Scholar Large Model System-Kurse und praktische Übungen hinzugefügt werden Vom Einstieg bis zum Fortgeschrittenen. Im Modellzeitalter gibt es keine Wanderung.

Die dritte Phase des Scholars Large Model Practical Camp wird vom 10. Juli bis 10. August offiziell gestartet. Im Praxiscamp werden alle Schritt für Schritt angeleitet, das InternLM2.5-Modell zu verfeinern und einzusetzen Assistenten werden Sie während des gesamten Prozesses begleiten und ein maßgebliches offizielles Zertifikat erhalten Sie schnellMelden Sie sich anLerne es!

Anmeldelink:https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu fördert Innovationen durch kontinuierlich hochwertiges Open Source, hält an Open Source und kostenloser kommerzieller Nutzung fest und stellt bessere Modelle und Toolketten für praktische Anwendungsszenarien bereit.