2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

3. heinäkuuta 2024 Shanghai Artificial Intelligence Laboratory ja SenseTime julkaisivat yhdessä Hongkongin kiinalaisen yliopiston ja Fudanin yliopiston kanssa virallisesti uuden sukupolven suuren kielimallin Puyu 2.5 (InternLM2.5). Verrattuna edellisen sukupolven malliin InternLM2.5:llä on kolme erinomaista kohokohtaa:

Päättelykykyä on parannettu huomattavasti, johtaen samansuuruisia kotimaisia ja ulkomaisia avoimen lähdekoodin malleja ja jopa ylittäen Llama3-70B:n kymmenkertaisesti joissain mitoissa;

Tukee 1M tokenin kontekstia ja pystyy käsittelemään miljoonia sanoja pitkää tekstiä;

Siinä on tehokkaat itsenäiset suunnittelu- ja työkalukutsut. Se voi esimerkiksi tehdä hakuja sadoilta verkkosivuilta ja suorittaa integroituja analyyseja monimutkaisten ongelmien varalta.

InternLM2.5-7B-malli on saatavana avoimena lähdekoodina tänään, ja suurempia ja pienempiä malleja julkaistaan lähitulevaisuudessa. Shanghai Artificial Intelligence Laboratory noudattaa käsitettä "mahdollistaa innovaatiot jatkuvalla korkealaatuisella avoimella lähdekoodilla".

GitHub-linkki: GitHub – InternLM/InternLM: InternLM2.5 7B -perus- ja chat-mallien virallinen julkaisu. 1M kontekstin tuki HuggingFace malli:https://huggingface.co/internlm

Scholar·Puyu kotisivu:Tietäjä·Puyu

Suurten mallien nopean kehityksen myötä ihmisten keräämä data kuluu nopeasti myös Mallin suorituskyvyn tehostamisesta on tullut suuri haaste tällä hetkellä. Tätä varten olemme kehittäneet uuden synteettisen datan ja mallin vauhtipyörän. Toisaalta käytämme synteettistä dataa korvataksemme alan korkealaatuisen tiedon puutteen vian korjaaminen mallin itseiteroinnin avulla, mikä nopeuttaa huomattavasti iteraatioita.

Olemme kehittäneet erilaisille dataominaisuuksille erilaisia datan synteesiteknologiaratkaisuja varmistaaksemme erityyppisten synteettisten tietojen laadun, mukaan lukien sääntöpohjaisen datan rakentamisen, mallipohjaisen tiedonlaajennuksen ja palautepohjaisen tiedon luomisen.

Kehitysprosessin aikana itse mallia käytetään jatkuvasti mallin iterointiin. Nykyisen mallin pohjalta rakensimme moniagentin tietojen seulomiseen, arviointiin ja huomautuksiin, mikä paransi huomattavasti tiedon laatua ja monimuotoisuutta. Samanaikaisesti mallin avulla tuotetaan ja jalostetaan myös uusia korpussia, jotta malli pystyy korjaamaan koulutusprosessin aikana havaitut ongelmat.

Tehokas päättelykyky on tärkeä perusta suurille malleille, jotka johtavat yleiseen tekoälyyn. InternLM2.5 optimoi päättelykyvyn mallin ydinkykynä ja tarjoaa hyvän pohjan monimutkaisten skenaarioiden soveltamiseen.

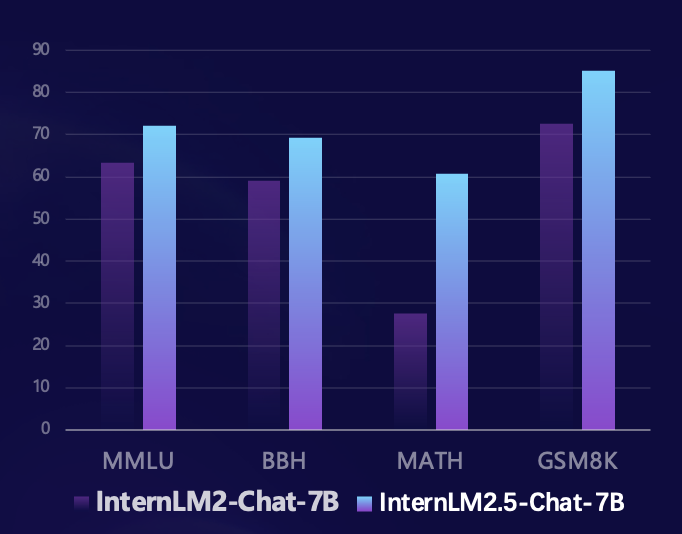

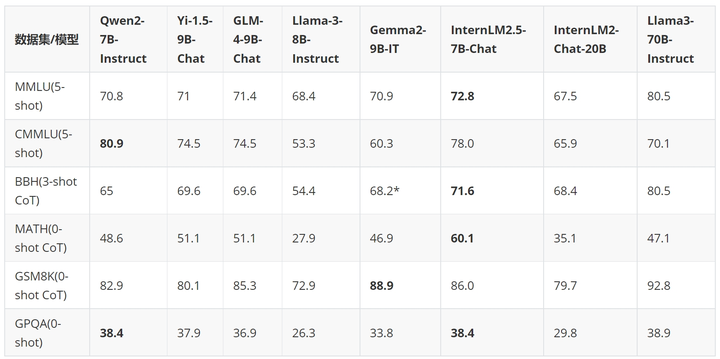

Sinan OpenCompass avoimen lähdekoodin arviointikehykseen perustuen tutkimusryhmä käytti yhtenäistä ja toistettavaa arviointimenetelmää useiden arvovaltaisten päättelykykyjen arviointisarjojen arvioinnissa. Verrattuna edellisen sukupolven malliin, InternLM2.5 on saavuttanut merkittäviä suorituskyvyn parannuksia useiden arvovaltaisten päättelykykyjen arviointisarjoissa. Erityisesti se on parantunut 100 % matematiikan arviointijoukossa MATH, joka koostuu kilpailuongelmista, saavuttaen 60 % 7B-parametreilla. Tarkkuusaste (joka saavuttaa GPT-4 Turbo 1106 -version tason) osoittaa täysin mallin erinomaisen suorituskyvyn matemaattisessa päättelyssä.

Viime kuukausien aikana laaja avoimen lähdekoodin malliyhteisö on kehittynyt nopeasti ja erinomaisia malleja on syntynyt suuri määrä. Verrattuna uusimpiin avoimen lähdekoodin malleihin kotimaassa ja ulkomailla, InternLM2.5-7B-Chat on edellä samansuuruisia malleja useimmissa päätelmien arviointisarjoissa Verrattuna edellisen sukupolven malliin, se on saavuttanut ylivoimaisen suorituskyvyn joissakin tapauksissa se ylittää mitoiltaan jopa kymmenen kertaa suuremman Llama3-70B-Instructin.

Käytämme esimerkkiä osoittaaksemme InternLM2.5:n erinomaiset päättelyominaisuudet.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

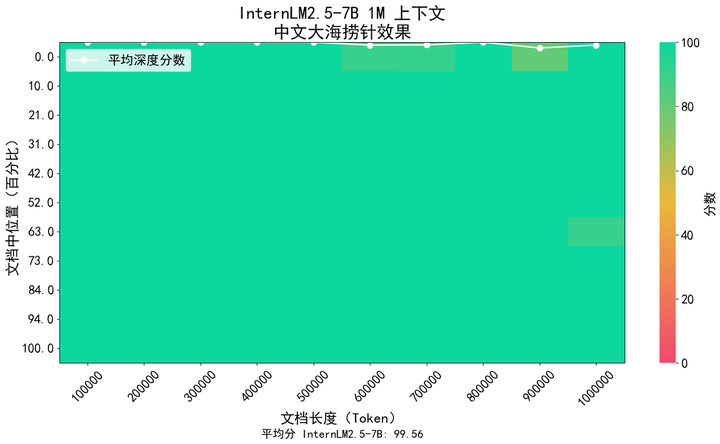

Sovellusskenaarioissa, kuten pitkän asiakirjan ymmärtäminen ja monimutkainen agenttivuorovaikutus, mallin kontekstipituuden tuella on korkeammat vaatimukset. InternLM2.5 ehdottaa ratkaisua, joka kasvattaa kontekstin pituuden edellisen sukupolven mallin InternLM2 200 kt:sta 1 miljoonaan (noin 1,2 miljoonaa kiinalaista merkkiä), mikä vapauttaa mallin potentiaalia entisestään erittäin pitkissä tekstisovelluksissa. Mallin esikoulutuksessa seuloimme luonnollisista korpuksista 256K Token-pituisia tekstejä. Samalla, jotta vältytään liian yhdentyyppisestä korpustyypistä, täydensimme sitä synteettisellä tiedolla, jotta malli. voi laajentaa kontekstia samalla kun sen ominaisuudet voidaan säilyttää mahdollisimman paljon.

Käytimme alalla suosittua "neula heinäsuovasta" -menetelmää arvioidaksemme mallin pitkän tekstin tietojen palautussisältöä Alla olevasta kuvasta näkyy, että InternLM 2.5 saavutti lähes täydellisen neulan heinäsuovasta 1M-merkkialueella, mikä osoittaa erittäin vahvaa pitkää tekstiä. käsittelyominaisuudet.

Lisäksi käytimme arvioinnissa laajalti käytettyä pitkän tekstin ymmärtämisen arviointisarjaa LongBench, ja tulokset osoittivat, että InternLM2.5 saavutti parhaan suorituskyvyn.

| GLM4-9B-Chat-1M | Qwen2-7B-Ohje | Yi1.5-9B-chat | InternLM2.5-7B-Chat-1M | |

| Pitkäpenkki | 46.5 | 41.2 | 37.2 | 47.4 |

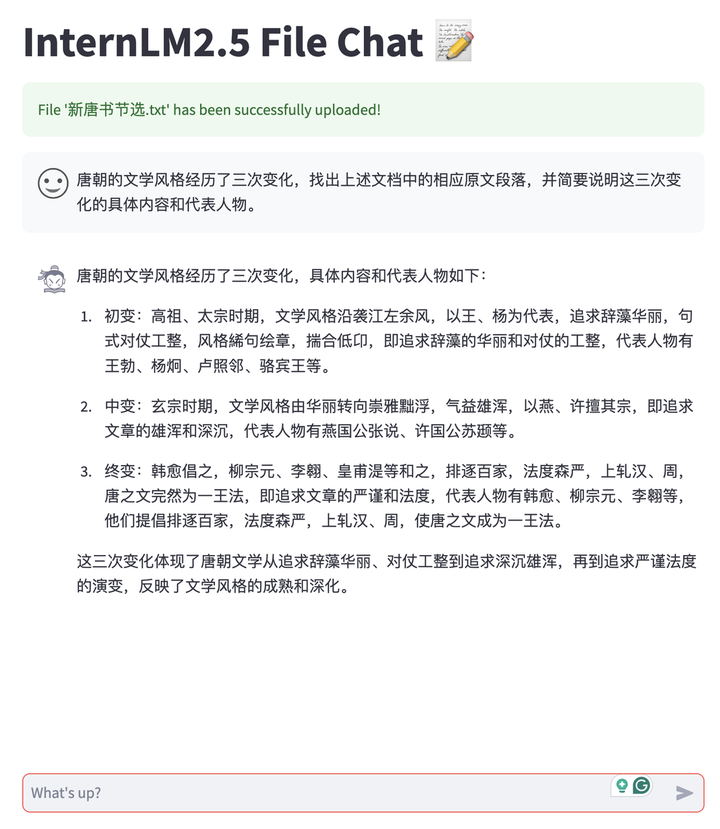

InternLM2.5:n pitkän tekstin ominaisuuksiin tukeutuen kehitimme dokumenttikeskustelusovelluksen, joka tukee käyttäjien yksityistettyä käyttöönottomallia ja asiakirjojen ilmaista lataamista keskustelua varten. Ja koko järjestelmä on avoimen lähdekoodin kaikki linkit, joten käyttäjien on helppo rakentaa se yhdellä napsautuksella, mukaan lukien LMDeploy pitkän tekstin perustelujen taustatuki, MinerU:n monityyppiset asiakirjan jäsennys- ja muunnosominaisuudet, Streamlit-pohjaiset käyttöliittymän keskustelukokemuksen työkalut. , jne. Tällä hetkellä se tukee TXT-, Markdown- ja PDF-dokumentteja, ja se tukee jatkossakin erilaisia toimistoasiakirjatyyppejä, kuten Wordia ja PPT:tä.

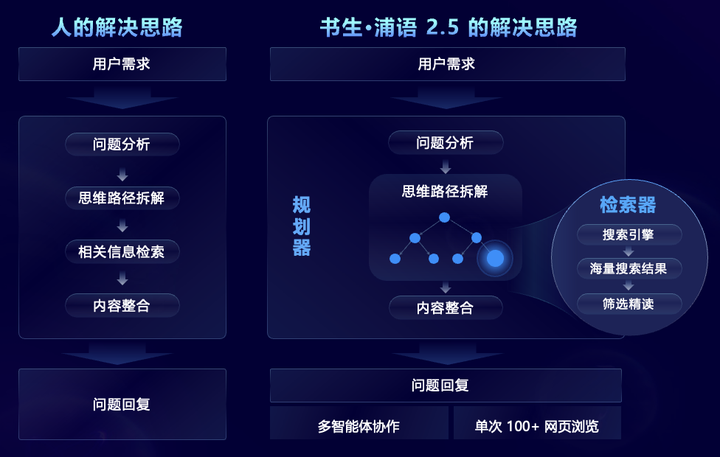

InternLM2.5 tähtää monimutkaisiin ongelmaskenaarioihin, jotka edellyttävät laajamittaista monimutkaista tiedonhakua ja integrointia, ja se ehdottaa innovatiivisesti MindSearch-moniagenttikehystä, joka simuloi ihmisen ajatteluprosessia ja esittelee tehtäväsuunnittelun, tehtävien purkamisen, laajan verkkohaun ja multi-agenttikehyksen. -lähdetietojen yhteenveto ja muut vaiheet verkkotietojen tehokkaaksi integroimiseksi. Niistä suunnittelija keskittyy tehtävien suunnitteluun, purkamiseen ja tiedon induktioon, käyttää graafisen rakenteen ohjelmointia suunnitteluun ja laajenee dynaamisesti tehtävän tilan mukaan perustua Suodata, selaa ja integroi tietoja sadoilta verkkosivuilta.

Parannettujen kohdennettujen ominaisuuksien jälkeen InternLM2.5 voi tehokkaasti suodattaa, selata ja integroida tietoja sadoilta verkkosivuilta monimutkaisten ammatillisten ongelmien ratkaisemiseksi, mikä lyhentää ihmisiltä 3 tuntia kestävän tutkimuksen yhteenvetotyön 3 minuuttiin. Kuten alla olevasta videosta näkyy, monivaiheisissa monimutkaisissa ongelmissa malli voi analysoida käyttäjien tarpeita, etsiä ensin Chang'e 6:n teknisiä ongelmia ja sitten etsiä vastaavia ratkaisuja kullekin tekniselle ongelmalle ja sitten etsiä tehtävää. tavoitteet, tekniset keinot, tieteellinen Vertaa Apollo 11:n kuuhun laskeutumissuunnitelmaa neljästä näkökulmasta: tuloksista ja kansainvälisestä yhteistyöstä, ja lopuksi tee yhteenveto maamme panoksesta kuuntutkimuksen menestyksessä.

Scholar·Puyu 2.5 on avoimen lähdekoodin versio, joka asettaa uuden mittapuun päättelykyvylle

Avoimen lähdekoodin mallien lisäksi Shusheng Puyu on viime vuoden heinäkuusta lähtien julkaissut täyden ketjun avoimen lähdekoodin työkalujärjestelmän suurten mallien kehittämiseen ja sovelluksiin, jotka kattavat kuusi tärkeintä datalinkkiä, esikoulutuksen, hienosäädön, käyttöönoton, arvioinnin, ja sovellus. Nämä työkalut helpottavat käyttäjien innovointia ja suurten mallien soveltamista sekä edistävät suuren mallin avoimen lähdekoodin ekosysteemin vaurautta ja kehitystä. InternLM2.5:n julkaisun myötä koko ketjutyökalujärjestelmä on myös päivitetty, sovelluslinkkejä on laajennettu ja uusia työkaluja on tarjottu erilaisiin tarpeisiin, mm.

HuixiangDou Domain Knowledge Assistant (GitHub – InternLM/HuixiangDou: HuixiangDou: Ryhmäkeskustelutilanteiden voittaminen LLM-pohjaisen teknisen tuen avulla), joka on erityisesti suunniteltu käsittelemään monimutkaisia teknisiä ongelmia ryhmäkeskusteluissa. Se sopii WeChatille, Feishulle, DingTalkille ja muille alustoille. Se tarjoaa täydelliset verkko-, Android- ja algoritmilähdekoodit ja tukee teollisuustason. sovellukset.

MinerU älykäs tiedonpoimintatyökalu (GitHub - opendatalab/MinerU: MinerU on yhden luukun, avoimen lähdekoodin, korkealaatuinen tiedonpoimintatyökalu, tukee PDF-/verkkosivujen/e-kirjojen purkamista.), joka on rakennettu multimodaalista asiakirjojen jäsennystä varten, ei vain voi muuntaa tarkasti multimodaalisia PDF-dokumentteja, kuten kuvia, taulukoita, kaavoja jne. selkeään ja helposti analysoitavaan Markdown-muotoon, vaan myös poistaa erilaisia häiriötietoja, kuten mainoksia. Jäsennä ja poimi muodollinen sisältö nopeasti verkkosivuilta

Itsekehittämän täyden ketjun avoimen lähdekoodin työkalujärjestelmän lisäksi InternLM2.5 ottaa aktiivisesti vastaan yhteisön, on yhteensopiva useiden yhteisön ekologisten projektien kanssa ja "saattaa kaikki" valtavirran avoimen lähdekoodin projektit.

Shanghai Artificial Intelligence Laboratory käynnisti viime vuoden joulukuussa Scholar·Puyu Large Model Practical Camp -leirin, joka sai yhteisöltä yksimielisen kiitosta. on kuoriutunut. InternLM2.5:n julkaisun yhteydessä ilmoitimme myös virallisesti, että Shusheng·Puyu Large Model Practical Camp on virallisesti päivitetty Scholar Large Model Practical Camp -leiriksi ja lisää vähitellen lisää Scholar Large Model System -kursseja ja käytännön harjoituksia. vie sinut pääsystä edistyneeseen mallien aikakaudella ei ole vaellusta.

Scholars Large Model Practical Camp -leirin kolmas vaihe käynnistetään virallisesti 10. heinäkuuta - 10. elokuuta avustajat ovat mukanasi koko prosessin ajan, samoin kuin arvovaltainen virallinen todistus, tulevat nopeastiKirjauduOpiskele sitä!

Ilmoittautumislinkki:https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu mahdollistaa innovaation jatkuvalla korkealaatuisella avoimella lähdekoodilla, noudattaa avointa lähdekoodia ja ilmaista kaupallista käyttöä ja tarjoaa parempia malleja ja työkaluketjuja käytännön sovelluksiin.