моя контактная информация

Почтамезофия@protonmail.com

2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

3 июля 2024 года Шанхайская лаборатория искусственного интеллекта и компания SenseTime совместно с Китайским университетом Гонконга и Фуданьским университетом официально выпустили новое поколение большой языковой модели Puyu 2.5 (InternLM2.5). По сравнению с моделью предыдущего поколения InternLM2.5 имеет три выдающихся особенности:

Способность к рассуждению была значительно улучшена, опережая отечественные и зарубежные модели с открытым исходным кодом того же уровня и даже превосходя Llama3-70B в десять раз по некоторым измерениям;

Поддерживает контекст токенов 1M и может обрабатывать длинный текст в миллионы слов;

Он обладает мощными возможностями независимого планирования и вызова инструментов. Например, он может выполнять поиск на сотнях веб-страниц и проводить комплексный анализ сложных проблем.

Модель InternLM2.5-7B сегодня доступна с открытым исходным кодом, а в ближайшем будущем будут выпущены более крупные и меньшие модели. Шанхайская лаборатория искусственного интеллекта придерживается концепции «обеспечения инноваций с помощью непрерывного высококачественного открытого исходного кода». Постоянно предоставляя сообществу высококачественные модели с открытым исходным кодом, она также будет продолжать придерживаться свободного коммерческого лицензирования.

Ссылка на гитхаб:GitHub - InternLM/InternLM: Официальный релиз InternLM2.5 7B базовых и чатовых моделей. Поддержка контекста 1M Модель HuggingFace:https://huggingface.co/internlm

Домашняя страница Ученого·Пую:Ученый·Пую

В связи с быстрым развитием больших моделей данные, накопленные людьми, также быстро потребляются. Как эффективно улучшить производительность моделей, стало серьезной проблемой, с которой мы столкнулись в настоящее время. С этой целью мы разработали новый маховик синтетических данных и модели. С одной стороны, мы используем синтетические данные, чтобы восполнить недостаток качественных данных в полевых условиях. С другой стороны, мы постоянно совершенствуем данные и совершенствуем их. исправление дефектов посредством самостоятельной итерации модели, что значительно ускоряет итерации InternLM2.5.

Для различных характеристик данных мы разработали различные технологические решения по синтезу данных, чтобы обеспечить качество различных типов синтетических данных, включая построение данных на основе правил, расширение данных на основе моделей и генерацию данных на основе обратной связи.

В процессе разработки сама модель постоянно используется для ее итерации. На основе текущей модели мы создали мультиагент для проверки, оценки и аннотирования данных, что значительно улучшило качество и разнообразие данных. В то же время модель также используется для создания и уточнения нового корпуса, чтобы модель могла устранять проблемы, обнаруженные в процессе обучения.

Мощные способности к рассуждению являются важной основой для больших моделей, ведущих к общему искусственному интеллекту. InternLM2.5 оптимизирует способность рассуждения как основную способность модели, обеспечивая хорошую основу для применения сложных сценариев.

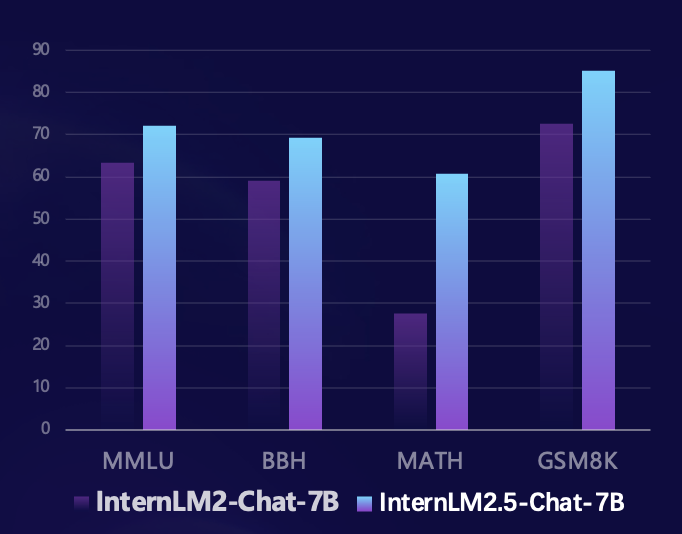

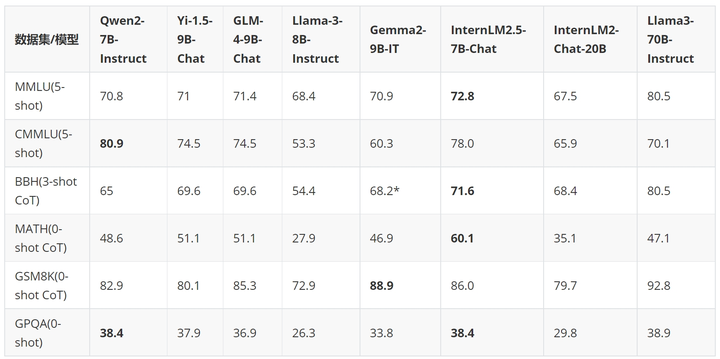

Основываясь на системе оценки с открытым исходным кодом Sinan OpenCompass, исследовательская группа использовала унифицированный и воспроизводимый метод оценки для проведения оценок на нескольких авторитетных наборах оценок возможностей рассуждения. По сравнению с моделью предыдущего поколения, InternLM2.5 добился существенного улучшения производительности на нескольких авторитетных наборах оценок возможностей рассуждения. В частности, он улучшил на 100% набор математических оценок MATH, состоящий из задач конкуренции, достигнув 60% с параметрами 7B. Уровень точности (достигающий уровня версии GPT-4 Turbo 1106) полностью демонстрирует отличные характеристики модели в математических рассуждениях.

За последние несколько месяцев сообщество крупных моделей с открытым исходным кодом быстро развилось, и появилось большое количество отличных моделей. По сравнению с новейшими моделями с открытым исходным кодом в стране и за рубежом, InternLM2.5-7B-Chat опережает модели того же уровня в большинстве наборов для оценки вывода. По сравнению с моделью предыдущего поколения он достиг превосходства по производительности. в некоторых случаях по размерам он даже превосходит Llama3-70B-Instruct, который в десять раз больше.

Мы используем пример, чтобы продемонстрировать отличные способности InternLM2.5 к рассуждениям.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

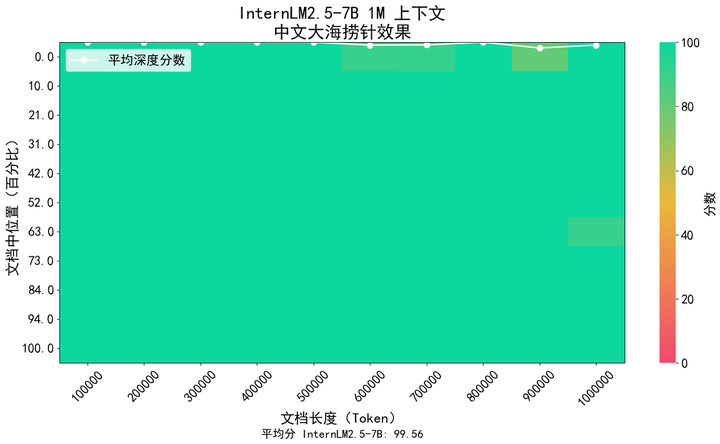

В сценариях приложений, таких как понимание длинных документов и сложное взаимодействие агентов, поддержка длины контекста модели предъявляет более высокие требования. InternLM2.5 предлагает решение, которое увеличивает длину контекста с 200 КБ в модели InternLM2 предыдущего поколения до 1 М (приблизительно 1,2 миллиона китайских символов), что еще больше раскрывает потенциал модели в приложениях со сверхдлинным текстом. При предварительном обучении модели мы отсеивали тексты длиной 256 тыс. токенов из естественного корпуса. В то же время, чтобы избежать смещения домена, вызванного слишком одним типом корпуса, мы дополнили его синтетическими данными, чтобы модель получилась. может расширить контекст, в то время как его возможности могут быть сохранены в максимально возможной степени.

Мы использовали популярный в отрасли метод «иголки в стоге сена» для оценки содержимого отзыва длинной текстовой информации модели. На рисунке ниже показано, что InternLM 2.5 достиг почти идеального результата при отзыве стога сена в диапазоне токенов 1M, продемонстрировав чрезвычайно мощный длинный текст. возможности обработки.

Кроме того, мы также использовали для оценки широко используемый набор для оценки понимания длинного текста LongBench, и результаты показали, что InternLM2.5 достиг наилучшей производительности.

| GLM4-9B-Чат-1M | Qwen2-7B-Инструкция | Yi1.5-9B-чат | СтажерLM2.5-7B-Чат-1M | |

| Длинная скамья | 46.5 | 41.2 | 37.2 | 47.4 |

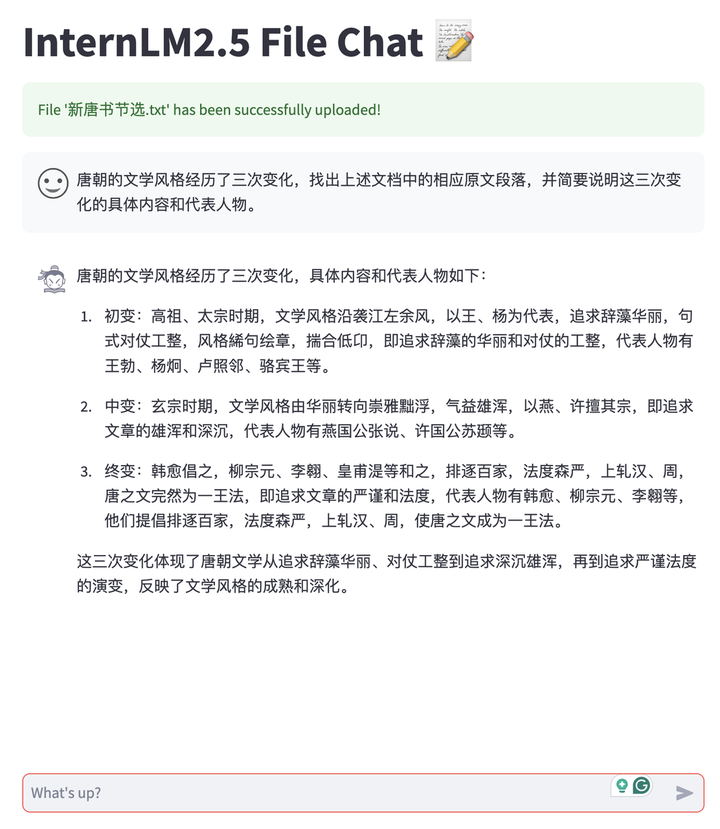

Опираясь на возможности InternLM2.5 по работе с длинными текстами, мы разработали приложение для диалога с документами, которое поддерживает модель частного развертывания пользователей и бесплатную загрузку документов для диалога. Вся система имеет открытый исходный код для всех ссылок, что позволяет пользователям легко создавать ее одним щелчком мыши, включая поддержку серверной части LMDeploy для рассуждения длинных текстов, возможности анализа и преобразования нескольких типов документов MinerU, инструменты взаимодействия с интерфейсом на основе Streamlit. , и т. д. В настоящее время он поддерживает документы TXT, Markdown и PDF, а в будущем продолжит поддерживать различные типы офисных документов, такие как Word и PPT.

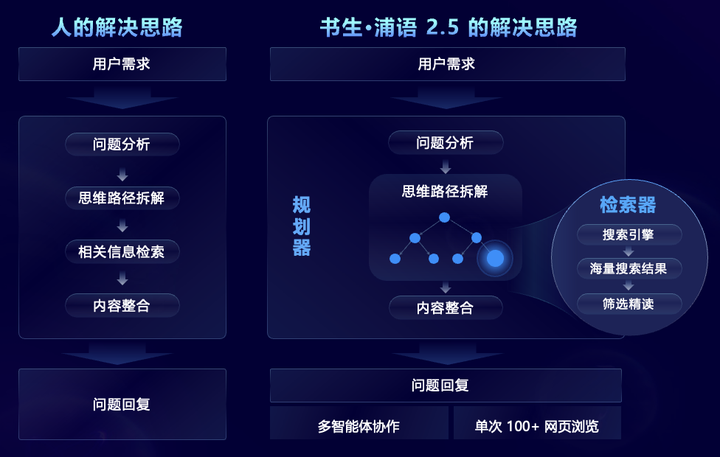

Нацеливаясь на сложные сценарии проблем, требующие крупномасштабного поиска и интеграции комплексной информации, InternLM2.5 инновационно предлагает многоагентную структуру MindSearch, которая имитирует процесс человеческого мышления и обеспечивает планирование задач, демонтаж задач, крупномасштабный веб-поиск и многоуровневый поиск. -Сводка исходной информации и другие шаги для эффективной интеграции сетевой информации. Среди них планировщик фокусируется на планировании задач, разборке и вводе информации, использует программирование графовой структуры для планирования и динамически расширяется в зависимости от статуса задачи. Поисковик отвечает за расходящийся поиск и обобщение результатов поиска в сети, чтобы вся структура могла. основываться на фильтрации, просмотре и интеграции информации с сотен веб-страниц.

Благодаря расширенным целевым возможностям InternLM2.5 может эффективно фильтровать, просматривать и интегрировать информацию с сотен веб-страниц для решения сложных профессиональных задач, сокращая сводную работу по исследованию, на выполнение которой у людей уходит 3 часа, до 3 минут. Как показано на видео ниже, для многоэтапных сложных проблем модель может анализировать потребности пользователя, сначала искать технические трудности «Чанъэ 6», а затем искать соответствующие решения для каждой технической трудности, а затем искать миссию. цели, технические средства, научные Сравните план высадки «Аполлона-11» на Луну с четырех аспектов: результаты и международное сотрудничество, и, наконец, подведите итоги вклада нашей страны в успех освоения Луны.

Scholar·Puyu 2.5 имеет открытый исходный код, устанавливая новый стандарт в способности рассуждать.

В дополнение к моделям с открытым исходным кодом, Shusheng Puyu с июля прошлого года запустила полноценную систему инструментов с открытым исходным кодом для разработки и применения крупных моделей, охватывающую шесть основных звеньев данных, предварительное обучение, тонкую настройку, развертывание, оценку, и приложение. Эти инструменты упрощают пользователям внедрение инноваций и применение больших моделей, а также способствуют процветанию и развитию экосистемы больших моделей с открытым исходным кодом. С выпуском InternLM2.5 также была обновлена вся система цепных инструментов, расширены ссылки на приложения и предоставлены новые инструменты для различных нужд, в том числе:

Помощник по знаниям предметной области HuixiangDou (GitHub - InternLM/HuixiangDou: HuixiangDou: Преодоление сценариев группового чата с технической помощью на основе LLM), специально разработанный для решения сложных технических проблем в групповых чатах. Он подходит для WeChat, Feishu, DingTalk и других платформ. Он предоставляет полный интерфейсный и внутренний веб-интерфейс, Android и исходные коды алгоритмов, а также поддерживает промышленный уровень. Приложения.

Интеллектуальный инструмент извлечения данных MinerU (GitHub - opendatalab/MinerU: MinerU — это универсальный высококачественный инструмент для извлечения данных с открытым исходным кодом, поддерживающий извлечение PDF-файлов, веб-страниц и электронных книг.), созданный для мультимодального анализа документов, может не только точно конвертировать мультимодальные PDF-документы, включая изображения, таблицы, формулы и т. д., в понятный и удобный для анализа формат Markdown, но также удалять различную мешающую информацию, например рекламу. Быстро анализируйте и извлекайте формальный контент с веб-страниц.

В дополнение к самостоятельно разработанной полнофункциональной системе инструментов с открытым исходным кодом, InternLM2.5 активно охватывает сообщество, совместим с широким спектром экологических проектов сообщества и «охватывает все» основные проекты с открытым исходным кодом.

В декабре прошлого года Шанхайская лаборатория искусственного интеллекта запустила практический лагерь по большим моделям Scholar Puyu, который получил единодушную похвалу сообщества. За последние шесть месяцев в обучении приняли участие в общей сложности 150 000 человек и было реализовано более 600 экологических проектов. вылупился. По случаю выпуска InternLM2.5 мы также официально объявили, что практический лагерь по большим моделям Шушенг-Пую был официально повышен до практического лагеря по большим моделям для ученых и постепенно будет добавлять больше курсов и практических упражнений по системе больших моделей для ученых. приведет вас от начального уровня к продвинутому. В эпоху моделей не существует пути.

Третий этап практического лагеря для ученых по большой модели будет официально запущен с 10 июля по 10 августа. В практическом лагере каждый будет шаг за шагом получать инструкции по точной настройке и развертыванию модели InternLM2.5. Бесплатная вычислительная мощность и обучение. помощники будут сопровождать вас на протяжении всего процесса, а также авторитетный официальный Сертификат, приедет быстроЗарегистрироватьсяИзучите это!

Ссылка на регистрацию:https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu расширяет возможности инноваций благодаря постоянному высококачественному открытому исходному коду, придерживается принципов открытого исходного кода и бесплатного коммерческого использования, а также предоставляет лучшие модели и цепочки инструментов для практических сценариев применения.