プライベートな連絡先の最初の情報

送料メール:

2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

2024 年 7 月 3 日、上海人工知能研究所と SenseTime は、香港中文大学および復丹大学と協力して、新世代の大規模言語モデル Puyu 2.5 (InternLM2.5) を正式にリリースしました。前世代モデルと比較して、InternLM2.5 には 3 つの優れたハイライトがあります。

推論能力が大幅に向上し、同規模の国内外のオープンソース モデルをリードし、いくつかの次元では Llama3-70B を 10 倍も上回っています。

1M トークンのコンテキストをサポートし、数百万語の長いテキストを処理できます。

たとえば、何百もの Web ページを検索し、複雑な問題に対して統合分析を行うことができます。

InternLM2.5-7B モデルは現在オープンソースとして利用可能であり、近い将来、より大きなモデルとより小さなモデルもリリースされる予定です。上海人工知能研究所は、「継続的な高品質のオープンソースでイノベーションを可能にする」というコンセプトを堅持し、高品質のオープンソース モデルをコミュニティに継続的に提供すると同時に、無償の商用ライセンスも堅持します。

GitHub リンク:GitHub - InternLM/InternLM: InternLM2.5 7B ベースおよびチャット モデルの公式リリース。1M コンテキストのサポート ハグフェイスモデル:https://huggingface.co/interlm 翻訳元

Scholar・Puyuホームページ:学者・プユ

大規模なモデルの急速な開発に伴い、人間が蓄積したデータも急速に消費され、モデルのパフォーマンスをいかに効率的に向上させるかが現在直面している大きな課題となっています。この目的を達成するために、私たちは新しい合成データとモデル フライホイールを開発しました。一方では、現場での高品質なデータの不足を補うために合成データを使用し、継続的にデータの改善を完了しました。モデルの自己反復による欠陥修復により、InternLM2.5 の反復が大幅に高速化されます。

さまざまなデータ特性に合わせて、ルールベースのデータ構築、モデルベースのデータ拡張、フィードバックベースのデータ生成など、さまざまな種類の合成データの品質を保証するさまざまなデータ合成テクノロジー ソリューションを開発しました。

開発プロセス中、モデル自体はモデルの反復に継続的に使用されます。現在のモデルに基づいて、データのスクリーニング、評価、注釈付けのためのマルチエージェントを構築し、データの品質と多様性を大幅に向上させました。同時に、モデルは新しいコーパスの生成と改良にも使用され、トレーニング プロセス中に発見された問題をモデルが修復できるようになります。

強力な推論能力は、一般的な人工知能につながる大規模モデルの重要な基盤です。InternLM2.5 は、モデルの中核となる能力として推論能力を最適化し、複雑なシナリオの適用に優れた基盤を提供します。

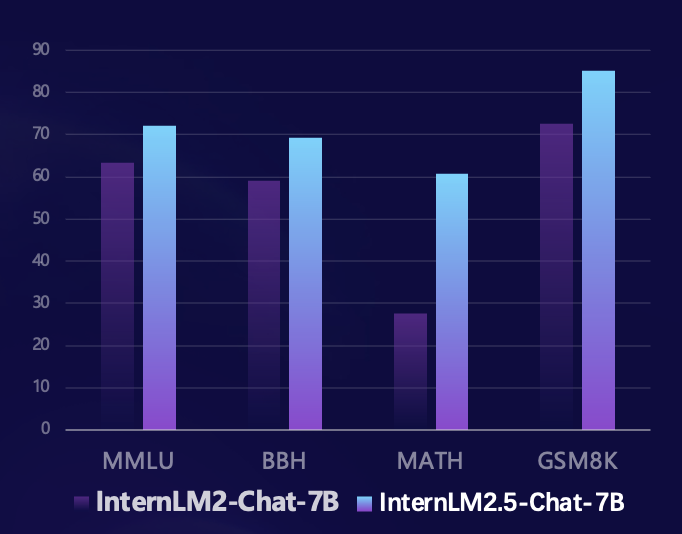

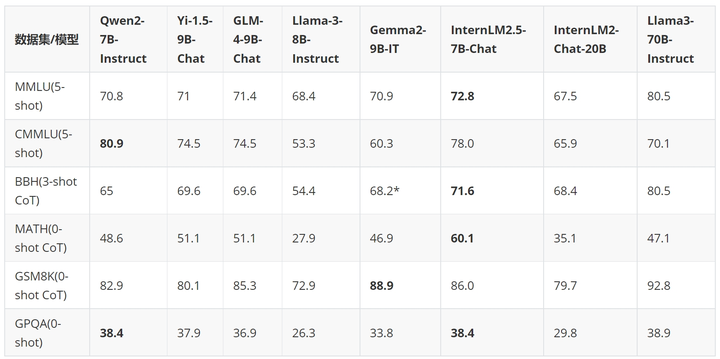

研究チームは、Sinan OpenCompass オープンソース評価フレームワークに基づいて、統一された再現可能な評価方法を使用して、推論能力に関する複数の信頼できる評価セットの評価を実施しました。前世代のモデルと比較して、InternLM2.5 は推論能力の複数の信頼できる評価セットで大幅なパフォーマンス向上を達成し、特に競争問題で構成される数学評価セット MATH で 100% 向上し、7B パラメーターで 60% に達しました。精度率 (GPT-4 Turbo 1106 バージョンのレベルに達) は、数学的推論におけるモデルの優れた性能を十分に示しています。

過去数か月の間に、大規模モデルのオープンソース コミュニティが急速に発展し、多数の優れたモデルが登場しました。国内外の最新のオープンソース モデルと比較すると、InternLM2.5-7B-Chat は、ほとんどの推論評価セットで同じ規模のモデルよりも優れており、前世代モデルと比較して、規模を超えた超越的なパフォーマンスを達成しています。場合によっては、寸法の点では、10 倍の Llama3-70B-Instruct を上回る場合もあります。

例を使用して、InternLM2.5 の優れた推論機能を示します。

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

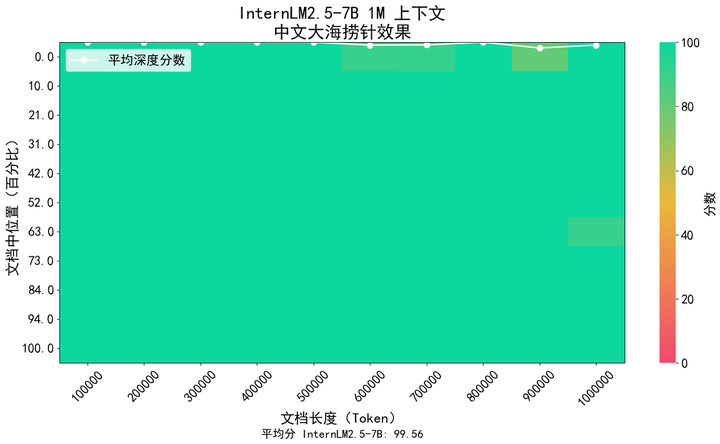

長い文書の理解や複雑なエージェントとの対話などのアプリケーション シナリオでは、モデルのコンテキスト長サポートの要件が高くなります。 InternLM2.5 は、コンテキスト長を前世代モデル InternLM2 の 200K から 1M (約 120 万漢字) に増加させ、超長テキスト アプリケーションにおけるモデルの可能性をさらに引き出すソリューションを提案します。モデルの事前トレーニングでは、自然コーパスから 256K のトークン長のテキストを選別しました。同時に、コーパスの種類が多すぎることによって引き起こされるドメインシフトを避けるために、モデルがそれを補うように合成データを追加しました。その機能を可能な限り維持しながら、コンテキストを拡張できます。

業界で一般的な「干し草の山の針」手法を使用して、モデルの長文テキスト情報のリコール内容を評価しました。下の図は、InternLM 2.5 が 1M トークンの範囲内でほぼ完璧な干し草の山の針のリコールを達成し、非常に強力な長文テキストを示していることを示しています。処理能力。

また、広く利用されている長文読解評価セットLongBenchも評価に使用したところ、InternLM2.5が最も優れた性能を発揮することがわかりました。

| GLM4-9B-チャット-1M | Qwen2-7B-指示 | Yi1.5-9B-チャット | インターンLM2.5-7B-チャット-1M | |

| ロングベンチ | 46.5 | 41.2 | 37.2 | 47.4 |

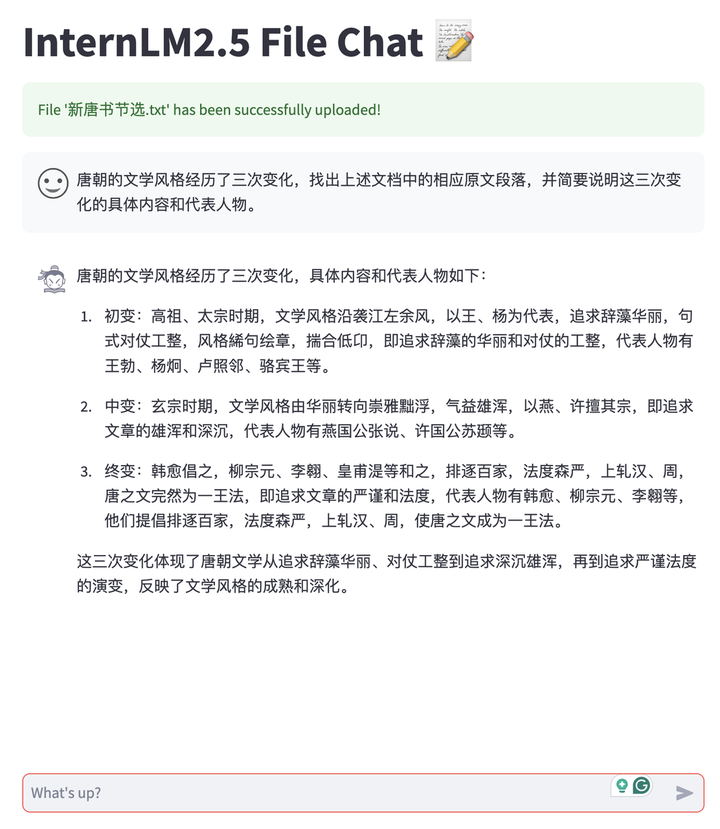

InternLM2.5 の長文テキスト機能を利用して、ユーザーの私有化された展開モデルと会話用のドキュメントの自由なアップロードをサポートするドキュメント会話アプリケーションを開発しました。また、システム全体はすべてのリンクを備えたオープンソースであり、ユーザーがワンクリックで簡単にシステムを構築できます。これには、LMDeploy の長いテキスト推論のバックエンド サポート、MinerU のマルチタイプ ドキュメントの解析および変換機能、Streamlit ベースのフロントエンド会話エクスペリエンス ツールが含まれます。 、など。現在、TXT、Markdown、PDF ドキュメントをサポートしていますが、将来的には Word や PPT などのさまざまな種類の Office ドキュメントも引き続きサポートする予定です。

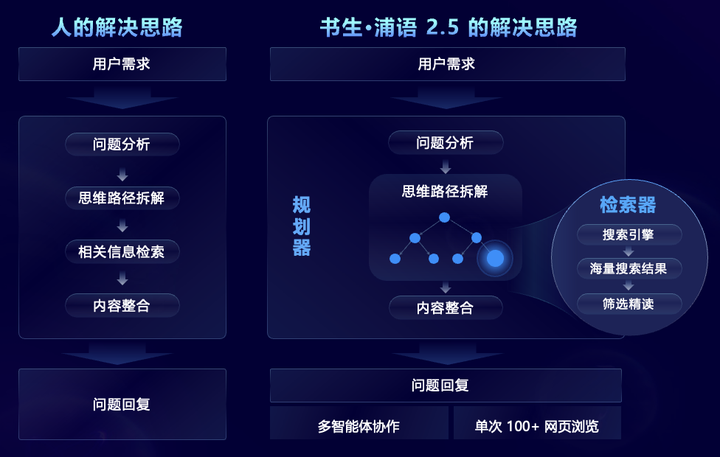

大規模で複雑な情報の検索と統合を必要とする複雑な問題シナリオを目指して、InternLM2.5 は、人間の思考プロセスをシミュレートし、タスクの計画、タスクの分解、大規模な Web 検索、およびマルチエージェントを導入する MindSearch マルチエージェント フレームワークを革新的に提案します。 -source ネットワーク情報を効果的に統合するための情報の概要とその他の手順。その中で、プランナーはタスクの計画、分解、情報の誘導に重点を置き、グラフ構造プログラミングを使用して計画を立て、サーチャーはタスクの状況に応じて動的に拡張し、ネットワーク全体の検索結果を要約する役割を担います。何百もの Web ページからの情報をフィルタリング、参照、統合することに基づいています。

対象を絞った機能が強化された InternLM2.5 は、何百もの Web ページからの情報を効果的にフィルタリング、参照、統合して、複雑な専門的問題を解決できるため、人間が完了するまでに 3 時間かかる調査の要約作業を 3 分に短縮できます。以下のビデオに示されているように、多段階の複雑な問題の場合、モデルはユーザーのニーズを分析し、最初に嫦娥6号の技術的困難を検索し、次に各技術的困難に対応する解決策を検索し、次にミッションを検索します。目的、技術的手段、科学的 アポロ 11 号の月面着陸計画を成果と国際協力の 4 つの側面から比較し、最後に月探査の成功に対する我が国の貢献を総括する。

Scholar・Puyu 2.5 はオープンソースであり、推論能力の新たなベンチマークを設定します

Shusheng Puyu は、オープンソース モデルに加えて、昨年 7 月以来、大規模モデルの開発とアプリケーションのためのフルチェーンのオープンソース ツール システムを立ち上げ、データ、事前トレーニング、微調整、展開、評価、そしてアプリケーション。これらのツールにより、ユーザーは大規模モデルの革新と適用が容易になり、大規模モデルのオープンソース エコシステムの繁栄と発展が促進されます。 InternLM2.5 のリリースにより、チェーン ツール システム全体もアップグレードされ、アプリケーション リンクが拡張され、次のようなさまざまなニーズに対応する新しいツールが提供されました。

HuixiangDou ドメイン ナレッジ アシスタント (GitHub - InternLM/HuixiangDou: HuixiangDou: LLM ベースの技術支援によるグループ チャット シナリオの克服)、グループ チャットにおける複雑な技術的問題に対処するために特別に設計されており、WeChat、Feishu、DingTalk およびその他のプラットフォームに適しています。完全なフロントエンドおよびバックエンド Web、Android、およびアルゴリズムのソース コードを提供し、産業グレードをサポートします。アプリケーション。

MinerU スマート データ抽出ツール (GitHub - opendatalab/MinerU: MinerU は、PDF/Web ページ/電子書籍の抽出をサポートする、ワンストップのオープンソースの高品質データ抽出ツールです。)は、マルチモーダル ドキュメント解析用に構築されており、画像、表、数式などを含むマルチモーダル PDF ドキュメントを、明確で分析しやすい Markdown 形式に正確に変換できるだけでなく、広告などのさまざまな干渉情報も削除できます。 Web ページから正式なコンテンツを迅速に解析して抽出します

自社開発のフルチェーン オープン ソース ツール システムに加えて、InternLM2.5 はコミュニティを積極的に受け入れ、幅広いコミュニティ エコロジー プロジェクトと互換性があり、主流のオープン ソース プロジェクトを「すべてキャッチ」します。

上海人工知能研究所は昨年 12 月に「Scholar・Puyu 大型モデル実践キャンプ」を開始し、コミュニティから満場一致で賞賛を受け、過去 6 か月間で合計 15 万人がトレーニングに参加し、600 以上のエコロジー プロジェクトが行われました。孵化してきました。 InternLM2.5 のリリースに際し、Shusheng・Puyu Large Model Practical Camp が Scholar Large Model Practical Camp に正式にアップグレードされ、Scholar Large Model System のコースと実践的な演習が徐々に追加されることも正式に発表しました。初心者から上級者までを連れて行きます。モデル時代にはトレッキングはありません。

Scholars 大規模モデル実践キャンプの第 3 フェーズは、7 月 10 日から 8 月 10 日まで正式に開始されます。実践キャンプでは、全員が、InternLM2.5 モデルの微調整と導入を段階的に指導されます。アシスタントがプロセス全体に同行し、権威ある公式証明書をすぐに受け取りますサインアップ勉強してください!

登録リンク:https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu は、継続的な高品質のオープンソースでイノベーションを促進し、オープンソースと無料の商用利用を遵守し、実用的なアプリケーションシナリオ向けに優れたモデルとツールチェーンを提供します。