Mi información de contacto

Correo[email protected]

2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

El 3 de julio de 2024, el Laboratorio de Inteligencia Artificial de Shanghai y SenseTime, junto con la Universidad China de Hong Kong y la Universidad de Fudan, lanzaron oficialmente la nueva generación del modelo de lenguaje grande Puyu 2.5 (InternLM2.5). En comparación con el modelo de la generación anterior, InternLM2.5 tiene tres aspectos destacados destacados:

La capacidad de razonamiento ha mejorado enormemente, liderando modelos de código abierto nacionales y extranjeros de la misma magnitud, e incluso superando a Llama3-70B diez veces en algunas dimensiones;

Admite contexto de 1 millón de tokens y puede manejar textos largos de millones de palabras;

Tiene potentes capacidades independientes de planificación y llamada de herramientas. Por ejemplo, puede buscar en cientos de páginas web y realizar análisis integrados para problemas complejos.

El modelo InternLM2.5-7B está disponible hoy como código abierto, y en un futuro próximo se lanzarán modelos más grandes y más pequeños. El Laboratorio de Inteligencia Artificial de Shanghai se adhiere al concepto de "permitir la innovación con código abierto continuo de alta calidad". Si bien proporciona constantemente modelos de código abierto de alta calidad a la comunidad, también seguirá adhiriéndose a las licencias comerciales gratuitas.

Enlace de GitHub:GitHub - InternLM/InternLM: lanzamiento oficial de los modelos base y de chat de InternLM2.5 7B. Soporte de contexto de 1M Modelo HuggingFace:https://huggingface.co/internlm

Página de inicio de Scholar·Puyu:Erudito·Puyu

Con el rápido desarrollo de modelos grandes, los datos acumulados por los humanos también se consumen rápidamente. Cómo mejorar de manera eficiente el rendimiento del modelo se ha convertido en un desafío importante al que nos enfrentamos actualmente. Con este fin, hemos desarrollado un nuevo volante de datos y modelos sintéticos. Por un lado, utilizamos datos sintéticos para compensar la falta de datos de alta calidad en el campo. Por otro lado, completamos continuamente la mejora de los datos. Reparación de defectos mediante la autoiteración del modelo, lo que acelera enormemente las iteraciones de InternLM2.5.

Para diferentes características de datos, hemos desarrollado una variedad de soluciones de tecnología de síntesis de datos para garantizar la calidad de diferentes tipos de datos sintéticos, incluida la construcción de datos basada en reglas, la expansión de datos basada en modelos y la generación de datos basada en retroalimentación.

Durante el proceso de desarrollo, el modelo en sí se utiliza continuamente para la iteración del modelo. Basándonos en el modelo actual, creamos un agente múltiple para la detección, evaluación y anotación de datos, lo que mejoró enormemente la calidad y diversidad de los datos. Al mismo tiempo, el modelo también se utiliza para producir y refinar nuevos corpus, de modo que el modelo pueda reparar los problemas descubiertos durante el proceso de capacitación.

La poderosa capacidad de razonamiento es una base importante para que los modelos grandes conduzcan a la inteligencia artificial general. InternLM2.5 optimiza la capacidad de razonamiento como la capacidad central del modelo y proporciona una buena base para la aplicación de escenarios complejos.

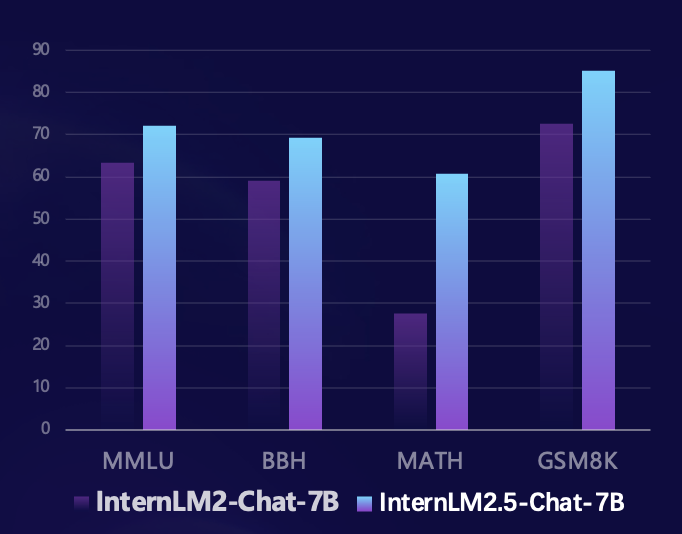

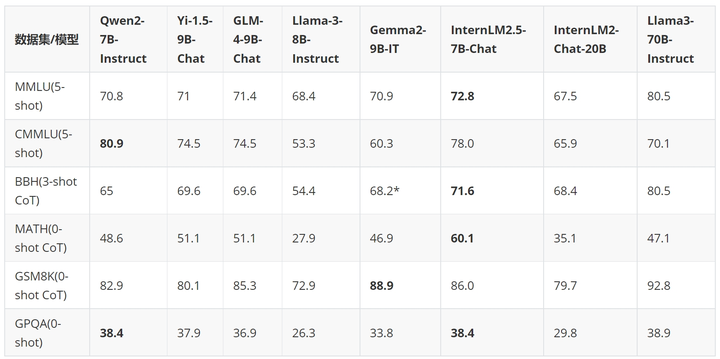

Basado en el marco de evaluación de código abierto Sinan OpenCompass, el equipo de investigación utilizó un método de evaluación unificado y reproducible para realizar evaluaciones en múltiples conjuntos de evaluación autorizada de capacidades de razonamiento. En comparación con el modelo de la generación anterior, InternLM2.5 ha logrado mejoras sustanciales en el rendimiento en múltiples conjuntos de evaluación autorizada de capacidades de razonamiento. En particular, ha mejorado en un 100% en el conjunto de evaluación de matemáticas MATH compuesto por problemas de competencia, alcanzando un 60% con parámetros 7B. La tasa de precisión (que alcanza el nivel de la versión GPT-4 Turbo 1106) demuestra plenamente el excelente rendimiento del modelo en el razonamiento matemático.

En los últimos meses, la gran comunidad de modelos de código abierto se ha desarrollado rápidamente y han surgido una gran cantidad de modelos excelentes. En comparación con los últimos modelos de código abierto nacionales y extranjeros, InternLM2.5-7B-Chat está por delante de modelos de la misma magnitud en la mayoría de los conjuntos de evaluación de inferencia. En comparación con el modelo de la generación anterior, ha logrado una trascendencia en el rendimiento de magnitud cruzada. En algunos casos, en términos de dimensiones, incluso supera al Llama3-70B-Instruct, que es diez veces más grande.

Usamos un ejemplo para demostrar las excelentes capacidades de razonamiento de InternLM2.5.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

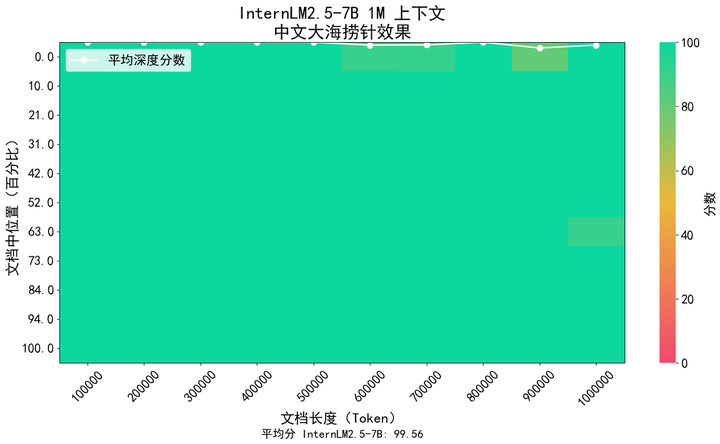

En escenarios de aplicación como la comprensión de documentos extensos y la interacción compleja de agentes, el soporte de longitud del contexto del modelo tiene requisitos más altos. InternLM2.5 propone una solución que aumenta la longitud del contexto de 200K en el modelo InternLM2 de la generación anterior a 1M (aproximadamente 1,2 millones de caracteres chinos), liberando aún más el potencial del modelo en aplicaciones de texto ultralargo. En el entrenamiento previo del modelo, seleccionamos textos de longitud de token de 256K del corpus natural. Al mismo tiempo, para evitar el cambio de dominio causado por un tipo de corpus demasiado único, lo complementamos con datos sintéticos, de modo que el modelo. puede ampliar el contexto mientras sus capacidades se pueden conservar tanto como sea posible.

Utilizamos el método popular de "aguja en un pajar" en la industria para evaluar el contenido de recuperación de información de texto largo del modelo. La siguiente figura muestra que InternLM 2.5 logró una recuperación de aguja en un pajar casi perfecta dentro del rango de tokens de 1 millón, lo que demuestra un texto largo extremadamente fuerte. capacidades de procesamiento.

Además, también utilizamos el conjunto de evaluación de comprensión de textos largos ampliamente utilizado LongBench para la evaluación, y los resultados mostraron que InternLM2.5 logró el mejor rendimiento.

| GLM4-9B-Chat-1M | Qwen2-7B-Instruir | Yi1.5-9B-chat | Pasante LM2.5-7B-Chat-1M | |

| Banco largo | 46.5 | 41.2 | 37.2 | 47.4 |

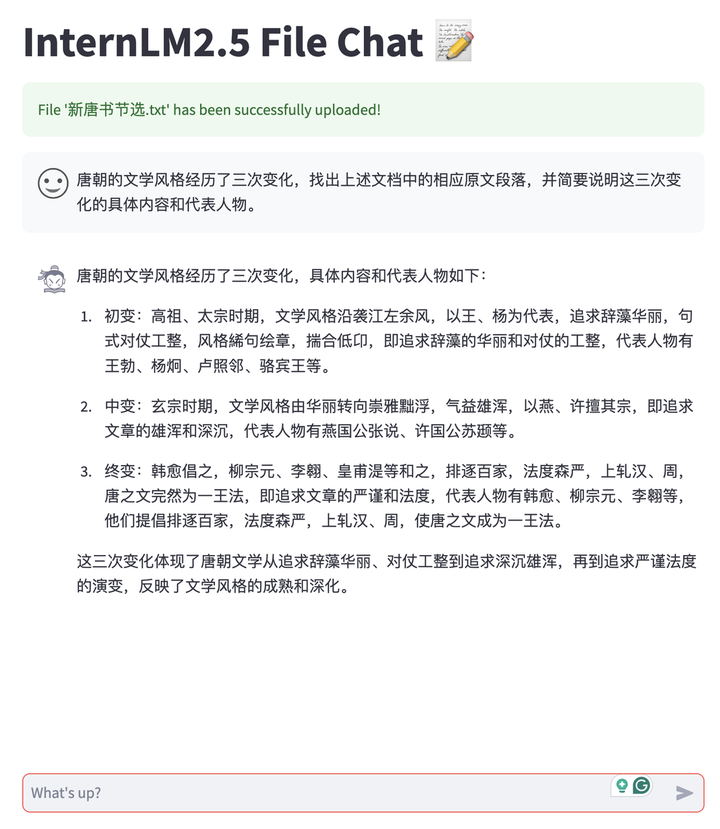

Basándonos en las capacidades de texto largo de InternLM2.5, desarrollamos una aplicación de conversación de documentos que admite el modelo de implementación privatizado de los usuarios y la carga gratuita de documentos para conversar. Y todo el sistema es de código abierto con todos los enlaces, lo que facilita a los usuarios construirlo con un solo clic, incluido el soporte backend de razonamiento de texto largo de LMDeploy, capacidades de conversión y análisis de documentos de varios tipos de MinerU, herramientas de experiencia de conversación frontal basadas en Streamlit. , etc. Actualmente admite documentos TXT, Markdown y PDF, y seguirá admitiendo varios tipos de documentos de Office como Word y PPT en el futuro.

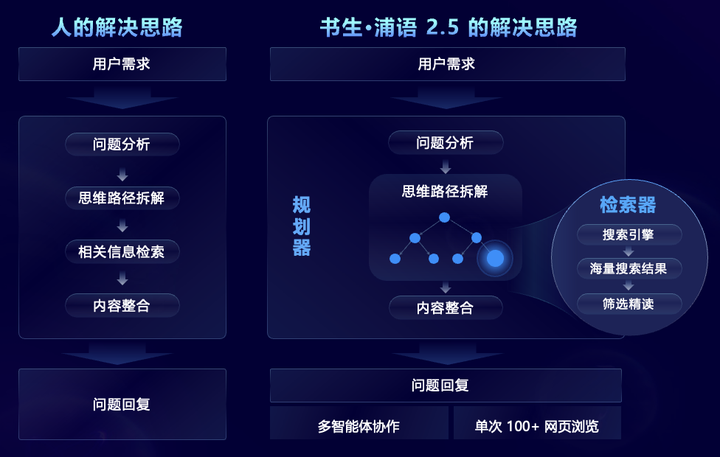

InternLM2.5, que apunta a escenarios de problemas complejos que requieren búsqueda e integración de información compleja a gran escala, propone de manera innovadora el marco multiagente MindSearch, que simula el proceso de pensamiento humano e introduce la planificación de tareas, el desmantelamiento de tareas, la búsqueda web a gran escala y múltiples funciones. -Resumen de información fuente y otros pasos para integrar eficazmente la información de la red. Entre ellos, el planificador se centra en la planificación de tareas, el desmontaje y la inducción de información, utiliza programación de estructura gráfica para planificar y se expande dinámicamente según el estado de la tarea. El buscador es responsable de la búsqueda divergente y de resumir los resultados de la búsqueda en la red, de modo que todo el marco pueda. Se basará en filtrar, explorar e integrar información de cientos de páginas web.

Después de capacidades específicas mejoradas, InternLM2.5 puede filtrar, explorar e integrar información de cientos de páginas web de manera efectiva para resolver problemas profesionales complejos, acortando el trabajo de resumen de investigación que a los humanos les toma 3 horas completar a 3 minutos. Como se muestra en el video a continuación, para problemas complejos de varios pasos, el modelo puede analizar las necesidades del usuario, primero buscar las dificultades técnicas de Chang'e 6, luego buscar las soluciones correspondientes para cada dificultad técnica y luego buscar la misión. Objetivos, medios técnicos, científicos Comparar el plan de alunizaje del Apolo 11 desde cuatro aspectos: resultados y cooperación internacional, y finalmente resumir la contribución de nuestro país al éxito de la exploración lunar.

Scholar·Puyu 2.5 es de código abierto y establece un nuevo punto de referencia en capacidad de razonamiento

Además de los modelos de código abierto, Shusheng Puyu ha lanzado un sistema de herramientas de código abierto de cadena completa para el desarrollo y aplicación de modelos grandes desde julio del año pasado, que cubre los seis enlaces principales de datos, capacitación previa, ajuste, implementación, evaluación, y aplicación. Estas herramientas facilitan a los usuarios la innovación y la aplicación de modelos grandes, y promueven la prosperidad y el desarrollo del ecosistema de código abierto de modelos grandes. Con el lanzamiento de InternLM2.5, también se actualizó todo el sistema de herramientas de la cadena, se ampliaron los enlaces de la aplicación y se proporcionaron nuevas herramientas para diferentes necesidades, que incluyen:

Asistente de conocimiento del dominio HuixiangDou (GitHub - InternLM/HuixiangDou: HuixiangDou: Cómo superar situaciones de chat grupal con asistencia técnica basada en LLM), especialmente diseñado para abordar problemas técnicos complejos en chats grupales. Es adecuado para WeChat, Feishu, DingTalk y otras plataformas. Proporciona códigos fuente completos de algoritmos, Android y web de front-end y back-end, y es compatible con nivel industrial. aplicaciones.

Herramienta de extracción de datos inteligente MinerU (GitHub - opendatalab/MinerU: MinerU es una herramienta de extracción de datos integral, de código abierto y de alta calidad que admite la extracción de PDF, páginas web y libros electrónicos.), creado para el análisis de documentos multimodales, no solo puede convertir con precisión documentos PDF multimodales, incluidas imágenes, tablas, fórmulas, etc., a un formato Markdown claro y fácil de analizar, sino que también puede eliminar diversa información de interferencia, como anuncios. Analiza y extrae rápidamente contenido formal de páginas web

Además del sistema de herramientas de código abierto de cadena completa de desarrollo propio, InternLM2.5 abraza activamente a la comunidad, es compatible con una amplia gama de proyectos ecológicos comunitarios y "capta todos" los principales proyectos de código abierto.

El Laboratorio de Inteligencia Artificial de Shanghai lanzó el Campamento Práctico Modelo Grande Scholar·Puyu en diciembre del año pasado, que recibió elogios unánimes de la comunidad. En los últimos seis meses, un total de 150.000 personas han participado en la capacitación y en más de 600 proyectos ecológicos. han sido incubados. Con motivo del lanzamiento de InternLM2.5, también anunciamos oficialmente que el Campamento práctico de modelo grande Shusheng·Puyu se ha actualizado oficialmente al Campamento práctico de modelo grande Scholar, y gradualmente agregaremos más cursos y ejercicios prácticos del Sistema de modelo grande Scholar a llevarlo desde el nivel básico al avanzado. No hay ningún camino en la era del modelo.

La tercera fase del campamento práctico Scholars Large Model se lanzará oficialmente del 10 de julio al 10 de agosto. En el campamento práctico, todos serán guiados paso a paso para ajustar e implementar el modelo InternLM2.5. Asistentes te acompañarán durante todo el proceso, así como Certificado oficial autorizado, ven rápidamenteInscribirse¡Estudialo!

Enlace de registro:https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu potencia la innovación con código abierto continuo de alta calidad, se adhiere al código abierto y al uso comercial gratuito y proporciona mejores modelos y cadenas de herramientas para escenarios de aplicaciones prácticas.