2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Le 3 juillet 2024, le laboratoire d'intelligence artificielle de Shanghai et SenseTime, en collaboration avec l'université chinoise de Hong Kong et l'université de Fudan, ont officiellement lancé la nouvelle génération de grand modèle de langage Puyu 2.5 (InternLM2.5). Par rapport au modèle de génération précédente, InternLM2.5 présente trois points forts remarquables :

La capacité de raisonnement a été considérablement améliorée, devançant les modèles open source nationaux et étrangers de même ampleur, et dépassant même de dix fois Llama3-70B dans certaines dimensions ;

Prend en charge le contexte de 1 million de jetons et peut gérer un texte long de plusieurs millions de mots ;

Il dispose de puissantes capacités indépendantes de planification et d'appel d'outils. Par exemple, il peut rechercher des centaines de pages Web et effectuer une analyse intégrée de problèmes complexes.

Le modèle InternLM2.5-7B est disponible aujourd'hui en open source, avec des modèles plus grands et plus petits qui seront publiés dans un avenir proche. Le laboratoire d'intelligence artificielle de Shanghai adhère au concept de « permettre l'innovation grâce à un open source continu de haute qualité ». Tout en fournissant systématiquement des modèles open source de haute qualité à la communauté, il continuera également à adhérer aux licences commerciales gratuites.

Lien GitHub :GitHub - InternLM/InternLM : Version officielle des modèles de base et de chat InternLM2.5 7B. Prise en charge du contexte 1M Modèle HuggingFace :https://huggingface.co/internlm

Page d'accueil de Scholar·Puyu :Érudit·Puyu

Avec le développement rapide des grands modèles, les données accumulées par les humains sont également rapidement consommées. Comment améliorer efficacement les performances des modèles est devenu un défi majeur auquel nous sommes actuellement confrontés. À cette fin, nous avons développé un nouveau volant de données synthétiques et de modèle. D'une part, nous utilisons des données synthétiques pour compenser le manque de données de haute qualité sur le terrain, d'autre part, nous complétons continuellement l'amélioration des données et. réparation des défauts par auto-itération du modèle, accélérant ainsi considérablement InternLM2.5 des itérations.

Pour différentes caractéristiques de données, nous avons développé une variété de solutions technologiques de synthèse de données pour garantir la qualité de différents types de données synthétiques, notamment la construction de données basée sur des règles, l'expansion de données basée sur un modèle et la génération de données basée sur des commentaires.

Au cours du processus de développement, le modèle lui-même est continuellement utilisé pour l'itération du modèle. Sur la base du modèle actuel, nous avons construit un multi-agent pour le filtrage, l'évaluation et l'annotation des données, ce qui a considérablement amélioré la qualité et la diversité des données. Dans le même temps, le modèle est également utilisé pour produire et affiner un nouveau corpus, afin que le modèle puisse réparer les problèmes découverts au cours du processus de formation.

Une capacité de raisonnement puissante constitue une base importante pour que les grands modèles conduisent à l'intelligence artificielle générale. InternLM2.5 optimise la capacité de raisonnement en tant que capacité de base du modèle, fournissant une bonne base pour l'application de scénarios complexes.

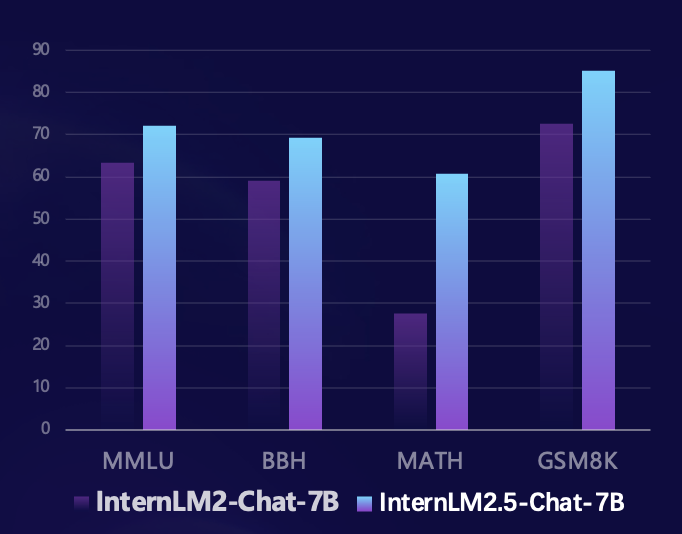

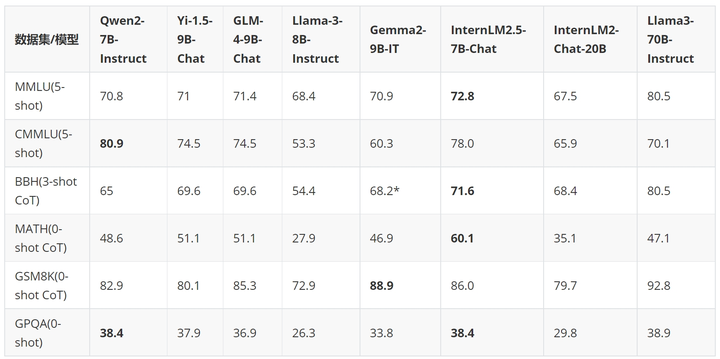

Basée sur le cadre d'évaluation open source Sinan OpenCompass, l'équipe de recherche a utilisé une méthode d'évaluation unifiée et reproductible pour mener des évaluations sur plusieurs ensembles d'évaluation faisant autorité de capacités de raisonnement. Par rapport au modèle de la génération précédente, InternLM2.5 a obtenu des améliorations substantielles des performances sur plusieurs ensembles d'évaluation faisant autorité des capacités de raisonnement. En particulier, il a amélioré de 100 % l'ensemble d'évaluation mathématique MATH composé de problèmes de compétition, atteignant 60 % avec les paramètres 7B. Le taux de précision (atteignant le niveau de la version GPT-4 Turbo 1106) démontre pleinement les excellentes performances du modèle en matière de raisonnement mathématique.

Au cours des derniers mois, la communauté open source des grands modèles s'est développée rapidement et un grand nombre d'excellents modèles ont émergé. Par rapport aux derniers modèles open source au pays et à l'étranger, InternLM2.5-7B-Chat est en avance sur les modèles de même ampleur dans la plupart des ensembles d'évaluation d'inférence. Par rapport au modèle de la génération précédente, il a atteint une transcendance des performances dans toutes les dimensions. dans certains cas, en termes de dimensions, il surpasse même le Llama3-70B-Instruct qui est dix fois plus grand.

Nous utilisons un exemple pour démontrer les excellentes capacités de raisonnement d'InternLM2.5.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

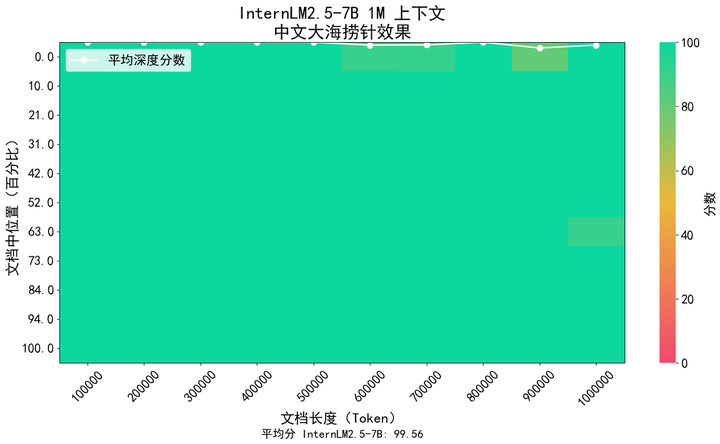

Dans des scénarios d'application tels que la compréhension de documents longs et l'interaction complexe d'agents, la prise en charge de la longueur de contexte du modèle a des exigences plus élevées. InternLM2.5 propose une solution qui augmente la longueur du contexte de 200 Ko dans le modèle de génération précédente InternLM2 à 1 M (environ 1,2 million de caractères chinois), libérant ainsi le potentiel du modèle dans les applications de texte ultra-longues. Lors de la pré-formation du modèle, nous avons éliminé les textes d'une longueur de 256 000 jetons du corpus naturel. Dans le même temps, afin d'éviter un changement de domaine causé par un type de corpus trop unique, nous l'avons complété avec des données synthétiques, de sorte que le modèle. peut élargir le contexte tout en conservant autant que possible ses capacités.

Nous avons utilisé la méthode populaire « aiguille dans une botte de foin » dans l'industrie pour évaluer le contenu de rappel d'informations de texte long du modèle. La figure ci-dessous montre qu'InternLM 2.5 a atteint un rappel d'aiguille dans une botte de foin presque parfait dans la plage de jetons 1M, démontrant un texte long extrêmement fort. capacités de traitement.

De plus, nous avons également utilisé LongBench, l'ensemble d'évaluation de compréhension de textes longs largement utilisé, pour l'évaluation, et les résultats ont montré qu'InternLM2.5 a obtenu les meilleures performances.

| GLM4-9B-Chat-1M | Qwen2-7B-Instruire | Chat Yi1.5-9B | StagiaireLM2.5-7B-Chat-1M | |

| Banc long | 46.5 | 41.2 | 37.2 | 47.4 |

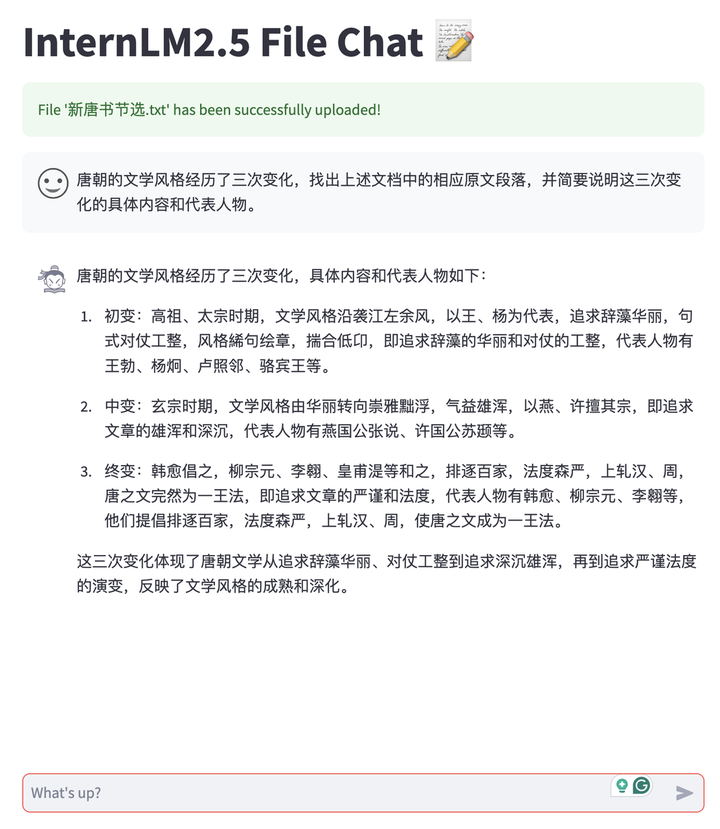

En nous appuyant sur les capacités de texte long d'InternLM2.5, nous avons développé une application de dialogue documentaire qui prend en charge le modèle de déploiement privé des utilisateurs et le téléchargement gratuit de documents pour le dialogue. Et l'ensemble du système est open source pour tous les liens, ce qui permet aux utilisateurs de le créer facilement en un seul clic, y compris la prise en charge du backend de raisonnement de texte long LMDeploy, les capacités d'analyse et de conversion de documents multi-types MinerU, les outils d'expérience de conversation frontale basés sur Streamlit. , etc. Actuellement, il prend en charge les documents TXT, Markdown et PDF, et continuera à l'avenir à prendre en charge divers types de documents bureautiques tels que Word et PPT.

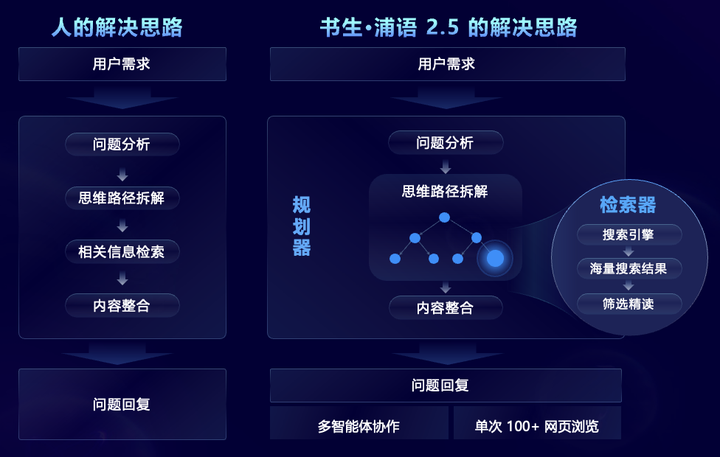

Visant des scénarios de problèmes complexes qui nécessitent une recherche et une intégration d'informations complexes à grande échelle, InternLM2.5 propose de manière innovante le cadre multi-agent MindSearch, qui simule le processus de pensée humaine et introduit la planification des tâches, le démantèlement des tâches, la recherche sur le Web à grande échelle et plusieurs -source Résumé des informations et autres étapes pour intégrer efficacement les informations du réseau. Parmi eux, le planificateur se concentre sur la planification des tâches, le démontage et l'induction d'informations, utilise la programmation de structure graphique pour la planification et se développe dynamiquement en fonction de l'état de la tâche. Le chercheur est responsable de la recherche divergente et de la synthèse des résultats de la recherche en réseau, afin que l'ensemble du cadre puisse. être basé sur Filtrer, parcourir et intégrer des informations provenant de centaines de pages Web.

Grâce à des capacités ciblées améliorées, InternLM2.5 peut filtrer, parcourir et intégrer efficacement des informations provenant de centaines de pages Web pour résoudre des problèmes professionnels complexes, raccourcissant ainsi le travail de synthèse de recherche qui prend 3 heures aux humains à 3 minutes. Comme le montre la vidéo ci-dessous, pour les problèmes complexes en plusieurs étapes, le modèle peut analyser les besoins des utilisateurs, rechercher d'abord les difficultés techniques de Chang'e 6, puis rechercher les solutions correspondantes pour chaque difficulté technique, puis rechercher la mission. objectifs, moyens techniques, scientifiques Comparez le plan d'alunissage d'Apollo 11 sous quatre aspects : résultats et coopération internationale, et résumez enfin la contribution de notre pays au succès de l'exploration lunaire.

Scholar·Puyu 2.5 est open source, établissant une nouvelle référence en matière de capacité de raisonnement

En plus des modèles open source, Shusheng Puyu a lancé depuis juillet de l'année dernière un système d'outils open source complet pour le développement et l'application de grands modèles, couvrant les six principaux maillons des données, de la pré-formation, du réglage fin, du déploiement, de l'évaluation, et application. Ces outils permettent aux utilisateurs d'innover et d'appliquer plus facilement de grands modèles, et favorisent la prospérité et le développement de l'écosystème open source des grands modèles. Avec la sortie d'InternLM2.5, l'ensemble du système d'outils de chaîne a également été mis à niveau, les liens d'application ont été étendus et de nouveaux outils ont été fournis pour différents besoins, notamment :

Assistant de connaissances du domaine HuixiangDou (GitHub - InternLM/HuixiangDou : HuixiangDou : surmonter les scénarios de chat de groupe avec l'assistance technique basée sur LLM), spécialement conçu pour traiter des problèmes techniques complexes dans les discussions de groupe. Il convient à WeChat, Feishu, DingTalk et à d'autres plates-formes. Il fournit des codes sources Web front-end et back-end complets, Android et algorithmiques, et prend en charge des codes sources de qualité industrielle. applications.

Outil d'extraction de données intelligent MinerU (GitHub - opendatalab/MinerU : MinerU est un outil d'extraction de données unique, open source et de haute qualité, qui prend en charge l'extraction de PDF/pages Web/livres électroniques.), conçu pour l'analyse de documents multimodaux, peut non seulement convertir avec précision des documents PDF multimodaux, notamment des images, des tableaux, des formules, etc. en un format Markdown clair et facile à analyser, mais également supprimer diverses informations d'interférence telles que les publicités. Analysez et extrayez rapidement le contenu formel des pages Web

En plus du système d'outils open source complet auto-développé, InternLM2.5 embrasse activement la communauté, est compatible avec un large éventail de projets écologiques communautaires et « attrape tous » les projets open source grand public.

Le Laboratoire d'intelligence artificielle de Shanghai a lancé le camp pratique sur les grands modèles Scholar Puyu en décembre de l'année dernière, qui a reçu les éloges unanimes de la communauté. Au cours des six derniers mois, un total de 150 000 personnes ont participé à la formation et plus de 600 projets écologiques ont été réalisés. été éclos. À l'occasion de la sortie d'InternLM2.5, nous avons également officiellement annoncé que le camp pratique de grand modèle Shusheng · Puyu a été officiellement mis à niveau vers le camp pratique de grand modèle Scholar, et ajouterons progressivement davantage de cours et d'exercices pratiques sur le système de grand modèle Scholar. vous emmène de l’entrée à l’avancée. Il n’y a pas de randonnée à l’ère du modèle.

La troisième phase du Scholars Large Model Practical Camp sera officiellement lancée du 10 juillet au 10 août. Dans le camp pratique, chacun sera guidé étape par étape pour affiner et déployer le modèle InternLM2.5 et l'enseignement gratuit. des assistants vous accompagneront tout au long du processus, ainsi qu'un certificat officiel faisant autorité, arrivent rapidementS'inscrireÉtudiez-le !

Lien d'inscription :https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu favorise l'innovation grâce à un open source continu de haute qualité, adhère à l'open source et à une utilisation commerciale gratuite, et fournit de meilleurs modèles et chaînes d'outils pour des scénarios d'application pratiques.