informasi kontak saya

Surat[email protected]

2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Pada tanggal 3 Juli 2024, Shanghai Artificial Intelligence Laboratory dan SenseTime, bersama dengan Chinese University of Hong Kong dan Fudan University, secara resmi merilis generasi baru model bahasa besar Puyu 2.5 (InternLM2.5). Dibandingkan dengan model generasi sebelumnya, InternLM2.5 memiliki tiga keunggulan luar biasa:

Kemampuan penalarannya telah meningkat pesat, memimpin model open source dalam dan luar negeri dengan besaran yang sama, dan bahkan melampaui Llama3-70B sebanyak sepuluh kali lipat dalam beberapa dimensi;

Mendukung konteks token 1 juta dan dapat menangani teks sepanjang jutaan kata;

Ia memiliki kemampuan perencanaan dan pemanggilan alat yang independen, misalnya, ia dapat mencari ratusan halaman web dan melakukan analisis terpadu untuk masalah yang kompleks.

Model InternLM2.5-7B tersedia sebagai open source saat ini, dengan model yang lebih besar dan lebih kecil akan dirilis dalam waktu dekat. Laboratorium Kecerdasan Buatan Shanghai menganut konsep "memungkinkan inovasi dengan sumber terbuka berkualitas tinggi yang berkelanjutan". Selain secara konsisten menyediakan model sumber terbuka berkualitas tinggi kepada masyarakat, laboratorium ini juga akan terus mematuhi lisensi komersial gratis.

Tautan GitHub:GitHub - InternLM/InternLM: Rilis resmi InternLM2.5 7B model dasar dan obrolan. Dukungan konteks 1M Model Memeluk Wajah:https://huggingface.co/internlm

Beranda Cendekiawan·Puyu:Sarjana·Puyu

Dengan pesatnya perkembangan model besar, data yang dikumpulkan oleh manusia juga dikonsumsi dengan cepat. Cara meningkatkan kinerja model secara efisien telah menjadi tantangan besar yang dihadapi saat ini. Untuk tujuan ini, kami telah mengembangkan data sintetik baru dan model roda gila. Di satu sisi, kami menggunakan data sintetik untuk menutupi kekurangan data berkualitas tinggi di lapangan perbaikan cacat melalui iterasi mandiri model, sehingga sangat mempercepat iterasi InternLM2.5.

Untuk karakteristik data yang berbeda, kami telah mengembangkan berbagai solusi teknologi sintesis data untuk memastikan kualitas berbagai jenis data sintetis, termasuk konstruksi data berbasis aturan, perluasan data berbasis model, dan pembuatan data berbasis umpan balik.

Selama proses pengembangan, model itu sendiri terus digunakan untuk iterasi model. Berdasarkan model saat ini, kami membangun multi-agen untuk penyaringan, evaluasi, dan anotasi data, yang sangat meningkatkan kualitas dan keragaman data. Pada saat yang sama, model juga digunakan untuk menghasilkan dan menyempurnakan korpus baru, sehingga model dapat memperbaiki permasalahan yang ditemukan selama proses pelatihan.

Kemampuan penalaran yang kuat merupakan landasan penting bagi model besar untuk menghasilkan kecerdasan buatan umum. InternLM2.5 mengoptimalkan kemampuan penalaran sebagai kemampuan inti model, memberikan landasan yang baik untuk penerapan skenario yang kompleks.

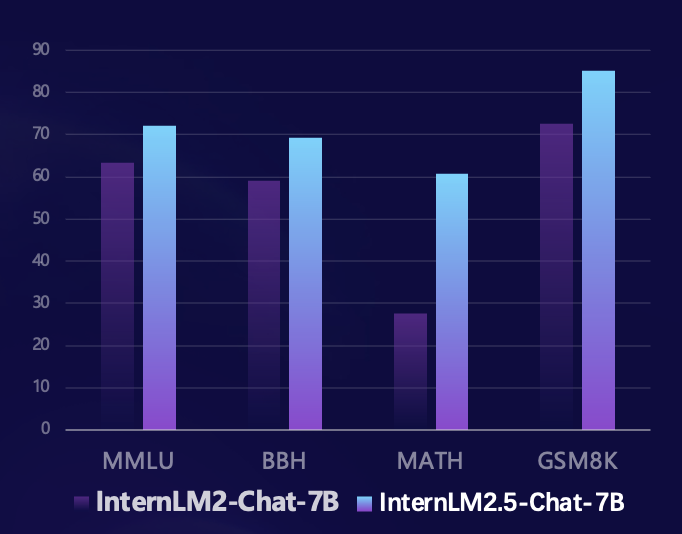

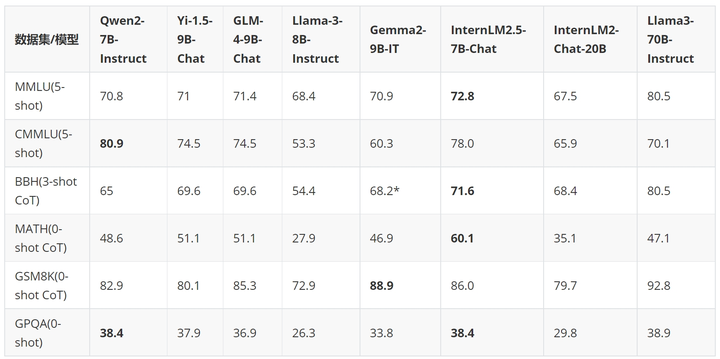

Berdasarkan kerangka evaluasi sumber terbuka Sinan OpenCompass, tim peneliti menggunakan metode evaluasi yang terpadu dan dapat direproduksi untuk melakukan evaluasi pada beberapa rangkaian evaluasi otoritatif dari kemampuan penalaran. Dibandingkan dengan model generasi sebelumnya, InternLM2.5 telah mencapai peningkatan kinerja yang substansial pada beberapa rangkaian evaluasi otoritatif kemampuan penalaran. Secara khusus, model ini telah meningkat sebesar 100% pada rangkaian evaluasi matematika MATH yang terdiri dari soal kompetisi, mencapai 60% dengan parameter 7B. Tingkat akurasi (mencapai level GPT-4 Turbo versi 1106) sepenuhnya menunjukkan performa model yang sangat baik dalam penalaran matematis.

Dalam beberapa bulan terakhir, komunitas model open source yang besar telah berkembang pesat, dan sejumlah besar model unggulan telah bermunculan. Dibandingkan dengan model open source terbaru di dalam dan luar negeri, InternLM2.5-7B-Chat lebih unggul dari model dengan skala yang sama di sebagian besar rangkaian evaluasi inferensi. Dibandingkan dengan model generasi sebelumnya, model ini telah mencapai transendensi kinerja lintas skala beberapa kasus Dari segi dimensi, bahkan melampaui Llama3-70B-Instruct yang ukurannya sepuluh kali lipat.

Kami menggunakan contoh untuk menunjukkan kemampuan penalaran yang sangat baik dari InternLM2.5.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

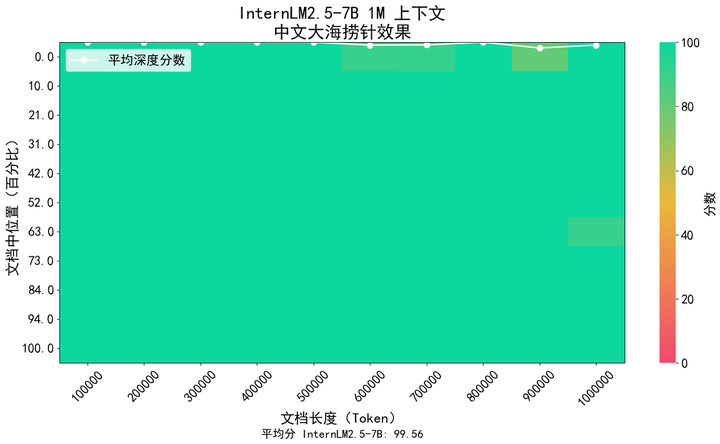

Dalam skenario aplikasi seperti pemahaman dokumen yang panjang dan interaksi agen yang kompleks, dukungan panjang konteks model memiliki persyaratan yang lebih tinggi. InternLM2.5 mengusulkan solusi yang meningkatkan panjang konteks dari 200K pada model InternLM2 generasi sebelumnya menjadi 1M (sekitar 1,2 juta karakter China), sehingga semakin membuka potensi model dalam aplikasi teks ultra-panjang. Dalam pra-pelatihan model, kami menyaring teks dengan panjang Token 256K dari korpus alami. Pada saat yang sama, untuk menghindari pergeseran domain yang disebabkan oleh jenis korpus yang terlalu tunggal, kami melengkapinya dengan data sintetis, sehingga model tersebut menjadi model. dapat memperluas konteksnya sementara kemampuannya dapat dipertahankan semaksimal mungkin.

Kami menggunakan metode "jarum di tumpukan jerami" yang populer di industri untuk mengevaluasi konten penarikan informasi teks panjang model. Gambar di bawah menunjukkan bahwa InternLM 2.5 mencapai penarikan jarum di tumpukan jerami yang hampir sempurna dalam rentang token 1 juta, menunjukkan teks panjang yang sangat kuat. kemampuan pemrosesan.

Selain itu, kami juga menggunakan kumpulan evaluasi pemahaman teks panjang LongBench yang banyak digunakan untuk evaluasi, dan hasilnya menunjukkan bahwa InternLM2.5 mencapai kinerja terbaik.

| GLM4-9B-Obrolan-1M | Qwen2-7B-Instruksikan | Yi1.5-9B-obrolan | InternLM2.5-7B-Obrolan-1M | |

| bangku panjang | 46.5 | 41.2 | 37.2 | 47.4 |

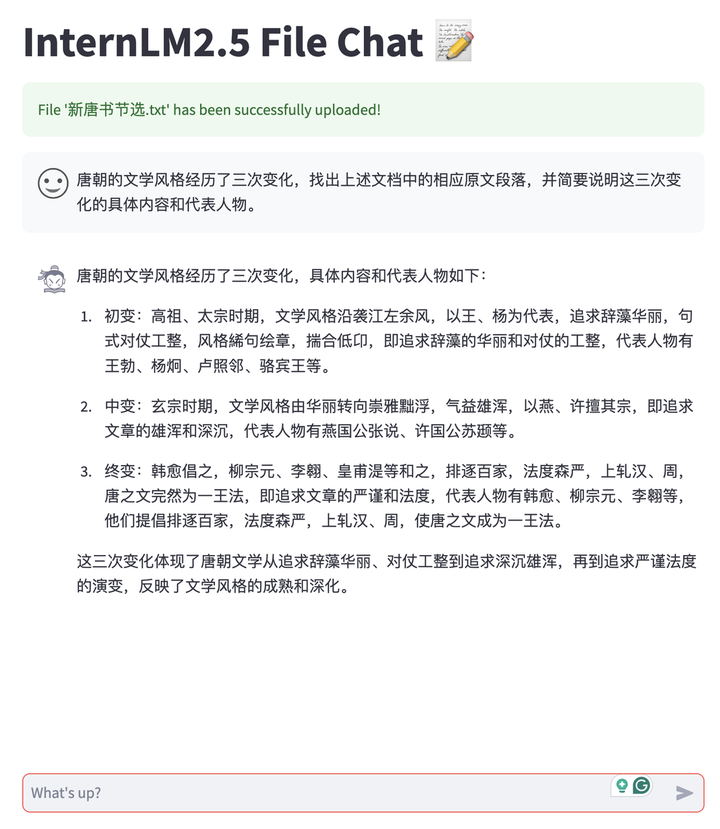

Mengandalkan kemampuan teks panjang InternLM2.5, kami mengembangkan aplikasi percakapan dokumen yang mendukung model penerapan privatisasi pengguna dan pengunggahan dokumen gratis untuk percakapan. Dan seluruh sistem adalah sumber terbuka dengan semua tautan, sehingga memudahkan pengguna untuk membangunnya dengan satu klik, termasuk dukungan backend penalaran teks panjang LMDeploy, kemampuan parsing dan konversi dokumen multi-tipe MinerU, alat pengalaman percakapan front-end berbasis Streamlit , dll. Saat ini mendukung dokumen TXT, Markdown dan PDF, dan akan terus mendukung berbagai jenis dokumen kantor seperti Word dan PPT di masa depan.

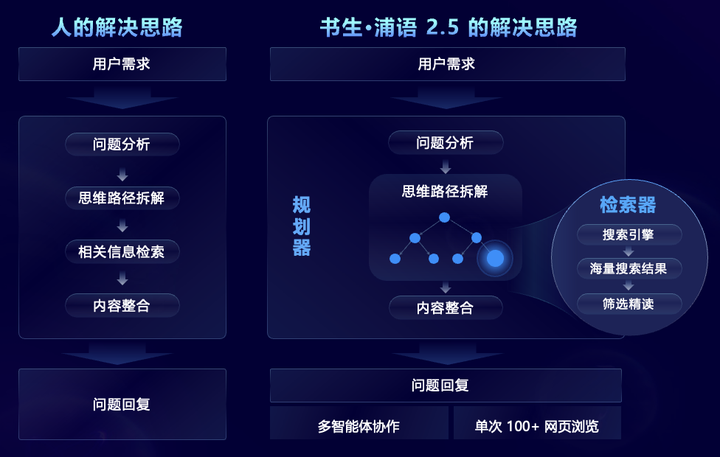

Bertujuan untuk skenario masalah kompleks yang memerlukan pencarian dan integrasi informasi kompleks berskala besar, InternLM2.5 secara inovatif mengusulkan kerangka kerja multi-agen MindSearch, yang mensimulasikan proses berpikir manusia dan memperkenalkan perencanaan tugas, pembongkaran tugas, pencarian web skala besar, dan multi -Sumber Ringkasan informasi dan langkah-langkah lain untuk mengintegrasikan informasi jaringan secara efektif. Diantaranya, perencana berfokus pada perencanaan tugas, pembongkaran dan induksi informasi, menggunakan pemrograman struktur grafik untuk merencanakan, dan secara dinamis berkembang sesuai dengan status tugas. Pencari bertanggung jawab untuk pencarian yang berbeda dan merangkum hasil pencarian jaringan, sehingga seluruh kerangka bisa didasarkan pada Filter, jelajahi dan integrasikan informasi dari ratusan halaman web.

Setelah meningkatkan kemampuan yang ditargetkan, InternLM2.5 dapat secara efektif menyaring, menelusuri, dan mengintegrasikan informasi dari ratusan halaman web untuk memecahkan masalah profesional yang kompleks, mempersingkat pekerjaan ringkasan penelitian yang membutuhkan waktu 3 jam untuk diselesaikan oleh manusia menjadi 3 menit. Seperti yang ditunjukkan dalam video di bawah, untuk masalah kompleks multi-langkah, model dapat menganalisis kebutuhan pengguna, pertama-tama mencari kesulitan teknis Chang'e 6, lalu mencari solusi yang sesuai untuk setiap kesulitan teknis, lalu mencari misinya. tujuan, sarana teknis, ilmiah Bandingkan rencana pendaratan bulan Apollo 11 dari empat aspek: hasil dan kerja sama internasional, dan terakhir rangkum kontribusi negara kita terhadap keberhasilan eksplorasi bulan.

Scholar·Puyu 2.5 adalah open source, menetapkan tolok ukur baru dalam kemampuan penalaran

Selain model sumber terbuka, Shusheng Puyu telah meluncurkan sistem alat sumber terbuka rantai penuh untuk pengembangan dan penerapan model besar sejak Juli tahun lalu, yang mencakup enam tautan utama data, pra-pelatihan, penyesuaian, penerapan, evaluasi, dan aplikasi. Alat-alat ini memudahkan pengguna untuk berinovasi dan menerapkan model besar, serta mendorong kemakmuran dan pengembangan ekosistem sumber terbuka model besar. Dengan dirilisnya InternLM2.5, seluruh sistem alat rantai juga telah ditingkatkan, tautan aplikasi telah diperluas, dan alat-alat baru telah disediakan untuk berbagai kebutuhan, termasuk:

Asisten Pengetahuan Domain HuixiangDou (GitHub - InternLM/HuixiangDou: HuixiangDou: Mengatasi Skenario Obrolan Grup dengan Bantuan Teknis berbasis LLM), dirancang khusus untuk menangani masalah teknis kompleks dalam obrolan grup. Cocok untuk WeChat, Feishu, DingTalk, dan platform lainnya. Ini menyediakan web front-end dan back-end, Android dan kode sumber algoritma, dan mendukung tingkat industri aplikasi.

Alat ekstraksi data cerdas MinerU (GitHub - opendatalab/MinerU: MinerU adalah alat ekstraksi data berkualitas tinggi, sumber terbuka, dan terpadu, mendukung ekstraksi PDF/halaman web/buku elektronik.), dibuat untuk penguraian dokumen multi-modal, tidak hanya dapat secara akurat mengonversi dokumen PDF multi-modal termasuk gambar, tabel, rumus, dll. ke dalam format Penurunan Harga yang jelas dan mudah dianalisis, tetapi juga menghapus berbagai informasi gangguan seperti iklan. Parsing dan ekstrak konten formal dengan cepat dari halaman web

Selain sistem alat sumber terbuka rantai penuh yang dikembangkan sendiri, InternLM2.5 secara aktif merangkul komunitas, kompatibel dengan berbagai proyek ekologi komunitas, dan "menampung semua" proyek sumber terbuka utama.

Laboratorium Kecerdasan Buatan Shanghai meluncurkan Perkemahan Praktik Model Besar Cendekia·Puyu pada bulan Desember tahun lalu, dan mendapat pujian bulat dari masyarakat. Dalam enam bulan terakhir, total 150.000 orang telah berpartisipasi dalam pelatihan ini, dan lebih dari 600 proyek ekologi. telah menetas. Pada kesempatan peluncuran InternLM2.5, kami juga secara resmi mengumumkan bahwa Perkemahan Praktik Model Besar Shusheng·Puyu telah secara resmi ditingkatkan menjadi Perkemahan Praktik Model Besar Cendekia, dan secara bertahap akan menambah lebih banyak kursus Sistem Model Besar Cendekia dan latihan praktik ke dalamnya. membawa Anda dari tingkat pemula hingga mahir.

Perkemahan Praktik Model Besar Cendekia fase ketiga akan diluncurkan secara resmi mulai 10 Juli hingga 10 Agustus. Dalam perkemahan praktik, setiap orang akan dipandu langkah demi langkah untuk menyempurnakan dan menerapkan model InternLM2.5 asisten akan menemani Anda sepanjang proses, serta Sertifikat resmi yang berwenang, datang dengan cepatMendaftarPelajarilah!

Tautan pendaftaran:https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu memberdayakan inovasi dengan sumber terbuka berkualitas tinggi yang berkelanjutan, mematuhi sumber terbuka dan penggunaan komersial gratis, serta menyediakan model dan rantai alat yang lebih baik untuk skenario aplikasi praktis.