τα στοιχεία επικοινωνίας μου

Ταχυδρομείο[email protected]

2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Στις 3 Ιουλίου 2024, το Εργαστήριο Τεχνητής Νοημοσύνης της Σαγκάης και το SenseTime, μαζί με το Κινεζικό Πανεπιστήμιο του Χονγκ Κονγκ και το Πανεπιστήμιο Φουντάν, κυκλοφόρησαν επίσημα τη νέα γενιά του μοντέλου μεγάλης γλώσσας Puyu 2.5 (InternLM2.5). Σε σύγκριση με το μοντέλο προηγούμενης γενιάς, το InternLM2.5 έχει τρία εξαιρετικά χαρακτηριστικά:

Η ικανότητα συλλογισμού έχει βελτιωθεί σημαντικά, οδηγώντας σε εγχώρια και ξένα μοντέλα ανοιχτού κώδικα του ίδιου μεγέθους και ξεπερνώντας ακόμη και το Llama3-70B κατά δέκα φορές σε ορισμένες διαστάσεις.

Υποστηρίζει 1M tokens πλαίσιο και μπορεί να χειριστεί εκατομμύρια λέξεις μεγάλου κειμένου.

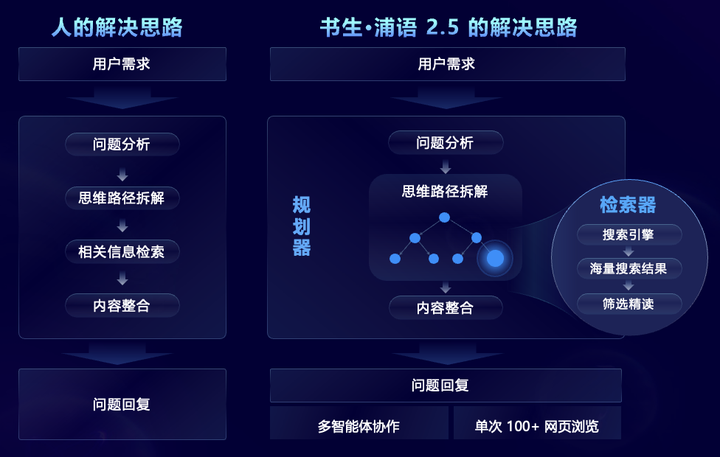

Διαθέτει ισχυρές δυνατότητες ανεξάρτητου προγραμματισμού και κλήσης εργαλείων. Για παράδειγμα, μπορεί να πραγματοποιήσει αναζήτηση σε εκατοντάδες ιστοσελίδες και να πραγματοποιήσει ολοκληρωμένη ανάλυση για πολύπλοκα προβλήματα.

Το μοντέλο InternLM2.5-7B είναι διαθέσιμο ως ανοιχτού κώδικα σήμερα, με μεγαλύτερα και μικρότερα μοντέλα να κυκλοφορούν στο εγγύς μέλλον. Το Εργαστήριο Τεχνητής Νοημοσύνης της Σαγκάης τηρεί την έννοια της «ενίσχυσης της καινοτομίας με συνεχή υψηλής ποιότητας ανοιχτό κώδικα, ενώ παρέχει σταθερά μοντέλα ανοιχτού κώδικα υψηλής ποιότητας στην κοινότητα, θα συνεχίσει επίσης να τηρεί τη δωρεάν εμπορική αδειοδότηση».

Σύνδεσμος GitHub: GitHub - InternLM/InternLM: Επίσημη κυκλοφορία των μοντέλων βάσης και συνομιλίας InternLM2.5 7B. Υποστήριξη περιβάλλοντος 1M Μοντέλο HuggingFace:https://huggingface.co/internlm

Αρχική σελίδα Scholar·Puyu:Μελετητής·Puyu

Με την ταχεία ανάπτυξη μεγάλων μοντέλων, τα δεδομένα που συσσωρεύονται από τον άνθρωπο καταναλώνονται επίσης γρήγορα. Για το σκοπό αυτό, έχουμε αναπτύξει ένα νέο συνθετικό βολάν δεδομένων και μοντέλου. Αφενός, χρησιμοποιούμε συνθετικά δεδομένα για να καλύψουμε την έλλειψη δεδομένων υψηλής ποιότητας στο πεδίο επισκευή ελαττώματος μέσω αυτόματης επανάληψης του μοντέλου, επιταχύνοντας έτσι σημαντικά τις επαναλήψεις InternLM2.5.

Για διαφορετικά χαρακτηριστικά δεδομένων, έχουμε αναπτύξει μια ποικιλία τεχνολογικών λύσεων σύνθεσης δεδομένων για να διασφαλίσουμε την ποιότητα διαφορετικών τύπων συνθετικών δεδομένων, συμπεριλαμβανομένης της κατασκευής δεδομένων βάσει κανόνων, της επέκτασης δεδομένων βάσει μοντέλου και της δημιουργίας δεδομένων βάσει ανατροφοδότησης.

Κατά τη διαδικασία ανάπτυξης, το ίδιο το μοντέλο χρησιμοποιείται συνεχώς για επανάληψη του μοντέλου. Με βάση το τρέχον μοντέλο, κατασκευάσαμε έναν πολυ-πρακτορείο για έλεγχο δεδομένων, αξιολόγηση και σχολιασμό, ο οποίος βελτίωσε σημαντικά την ποιότητα και την ποικιλομορφία των δεδομένων. Ταυτόχρονα, το μοντέλο χρησιμοποιείται επίσης για την παραγωγή και τη βελτίωση νέων κειμένων, έτσι ώστε το μοντέλο να μπορεί να επιδιορθώσει τα προβλήματα που ανακαλύφθηκαν κατά τη διαδικασία εκπαίδευσης.

Η ισχυρή ικανότητα συλλογισμού είναι μια σημαντική βάση για τα μεγάλα μοντέλα που οδηγούν σε γενική τεχνητή νοημοσύνη.

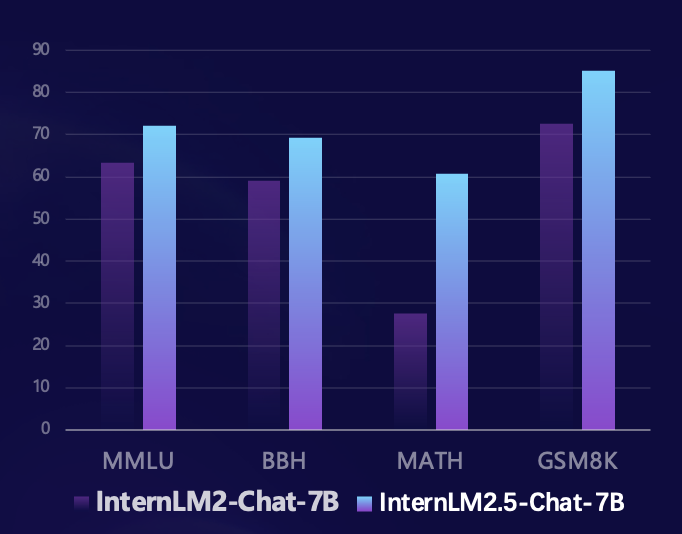

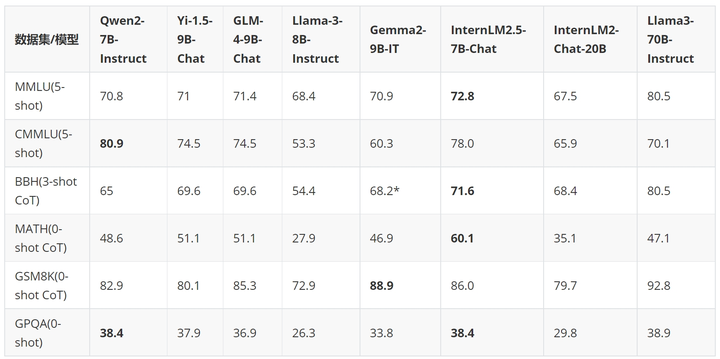

Με βάση το πλαίσιο αξιολόγησης ανοιχτού κώδικα Sinan OpenCompass, η ερευνητική ομάδα χρησιμοποίησε μια ενοποιημένη και αναπαραγώγιμη μέθοδο αξιολόγησης για τη διεξαγωγή αξιολογήσεων σε πολλαπλά έγκυρα σύνολα αξιολόγησης συλλογιστικών δυνατοτήτων. Σε σύγκριση με το μοντέλο προηγούμενης γενιάς, το InternLM2.5 έχει επιτύχει ουσιαστικές βελτιώσεις στην απόδοση σε πολλαπλά έγκυρα σύνολα ικανοτήτων συλλογιστικής. Συγκεκριμένα, έχει βελτιωθεί κατά 100% στο σύνολο μαθηματικών αξιολόγησης MATH που αποτελείται από προβλήματα ανταγωνισμού, φτάνοντας το 60% με παραμέτρους 7Β. Το ποσοστό ακρίβειας (φτάνοντας το επίπεδο της έκδοσης GPT-4 Turbo 1106) καταδεικνύει πλήρως την εξαιρετική απόδοση του μοντέλου στη μαθηματική συλλογιστική.

Τους τελευταίους μήνες, η μεγάλη κοινότητα ανοιχτού κώδικα μοντέλων αναπτύχθηκε γρήγορα και ένας μεγάλος αριθμός εξαιρετικών μοντέλων εμφανίστηκε. Σε σύγκριση με τα πιο πρόσφατα μοντέλα ανοιχτού κώδικα στο εσωτερικό και στο εξωτερικό, το InternLM2.5-7B-Chat προηγείται των μοντέλων του ίδιου μεγέθους στα περισσότερα σύνολα αξιολόγησης συμπερασμάτων Σε σύγκριση με το μοντέλο προηγούμενης γενιάς, έχει επιτύχει υπέρβαση απόδοσης μερικές θήκες Από πλευράς διαστάσεων ξεπερνά ακόμη και το Llama3-70B-Instruct που είναι δεκαπλάσιο από το μέγεθος.

Χρησιμοποιούμε ένα παράδειγμα για να δείξουμε τις εξαιρετικές συλλογιστικές ικανότητες του InternLM2.5.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

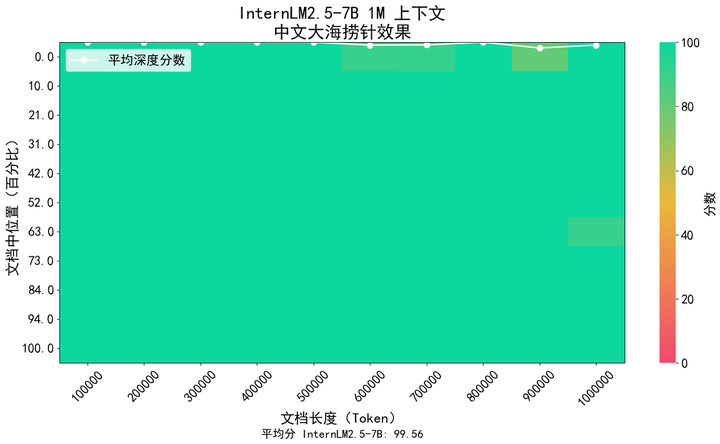

Σε σενάρια εφαρμογών όπως η κατανόηση μεγάλου εγγράφου και η σύνθετη αλληλεπίδραση με πράκτορα, η υποστήριξη μήκους περιβάλλοντος του μοντέλου έχει υψηλότερες απαιτήσεις. Το InternLM2.5 προτείνει μια λύση που αυξάνει το μήκος περιβάλλοντος από 200K στο μοντέλο προηγούμενης γενιάς InternLM2 σε 1M (περίπου 1,2 εκατομμύρια κινεζικούς χαρακτήρες), απελευθερώνοντας περαιτέρω τις δυνατότητες του μοντέλου σε εφαρμογές υπερβολικά μεγάλου κειμένου. Κατά την προ-εκπαίδευση του μοντέλου, εξετάσαμε κείμενα μήκους 256K Token από φυσικό σώμα. μπορεί να επεκτείνει το πλαίσιο ενώ οι δυνατότητές του μπορούν να διατηρηθούν όσο το δυνατόν περισσότερο.

Χρησιμοποιήσαμε τη δημοφιλή μέθοδο "βελόνα σε θημωνιά" στη βιομηχανία για να αξιολογήσουμε το περιεχόμενο ανάκλησης πληροφοριών μεγάλου κειμένου του μοντέλου. δυνατότητες επεξεργασίας.

Επιπλέον, χρησιμοποιήσαμε επίσης το ευρέως χρησιμοποιούμενο σύνολο αξιολόγησης κατανόησης μεγάλου κειμένου LongBench για αξιολόγηση και τα αποτελέσματα έδειξαν ότι το InternLM2.5 πέτυχε την καλύτερη απόδοση.

| GLM4-9B-Chat-1M | Qwen2-7B-Instruct | Yi1.5-9B-chat | InternLM2.5-7B-Chat-1M | |

| Longbench | 46.5 | 41.2 | 37.2 | 47.4 |

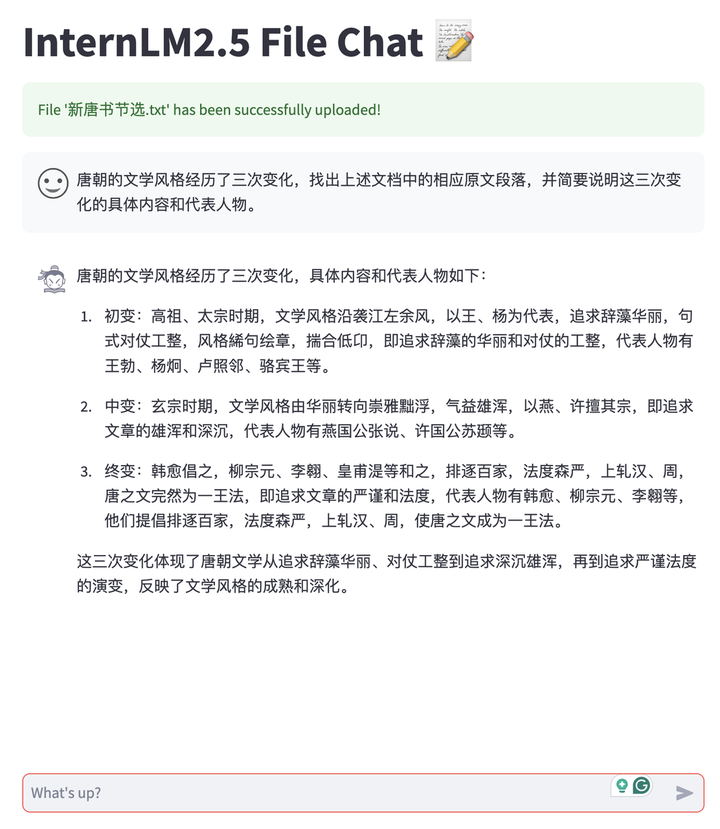

Βασιζόμενοι στις δυνατότητες εκτενούς κειμένου του InternLM2.5, αναπτύξαμε μια εφαρμογή διαλόγου εγγράφων που υποστηρίζει το ιδιωτικό μοντέλο ανάπτυξης των χρηστών και τη δωρεάν μεταφόρτωση εγγράφων για διάλογο. Και ολόκληρο το σύστημα είναι ανοιχτού κώδικα για όλους τους συνδέσμους, διευκολύνοντας τους χρήστες να το δημιουργήσουν με ένα κλικ, συμπεριλαμβανομένης της υποστήριξης υποστήριξης συλλογισμού μεγάλου κειμένου LMDeploy, των δυνατοτήτων ανάλυσης και μετατροπής εγγράφων πολλαπλών τύπων MinerU, εργαλείων εμπειρίας συνομιλίας με βάση το Streamlit , και τα λοιπά. Προς το παρόν υποστηρίζει έγγραφα TXT, Markdown και PDF και θα συνεχίσει να υποστηρίζει διάφορους τύπους εγγράφων γραφείου, όπως Word και PPT στο μέλλον.

Στοχεύοντας σε σενάρια περίπλοκων προβλημάτων που απαιτούν μεγάλης κλίμακας σύνθετη αναζήτηση και ενσωμάτωση πληροφοριών, το InternLM2.5 προτείνει καινοτόμα το πλαίσιο πολλαπλών πρακτόρων MindSearch, το οποίο προσομοιώνει τη διαδικασία της ανθρώπινης σκέψης και εισάγει τον προγραμματισμό εργασιών, την αποσυναρμολόγηση εργασιών, την αναζήτηση ιστού μεγάλης κλίμακας και -Πηγή Περίληψη πληροφοριών και άλλα βήματα για την αποτελεσματική ενσωμάτωση πληροφοριών δικτύου. Μεταξύ αυτών, ο σχεδιαστής εστιάζει στον προγραμματισμό εργασιών, την αποσυναρμολόγηση και την επαγωγή πληροφοριών, χρησιμοποιεί προγραμματισμό δομής γραφήματος για τον προγραμματισμό και επεκτείνεται δυναμικά ανάλογα με την κατάσταση της εργασίας να βασίζονται στο Φίλτρο, να περιηγούνται και να ενσωματώνουν πληροφορίες από εκατοντάδες ιστοσελίδες.

Μετά από βελτιωμένες στοχευμένες δυνατότητες, το InternLM2.5 μπορεί αποτελεσματικά να φιλτράρει, να περιηγηθεί και να ενσωματώσει πληροφορίες από εκατοντάδες ιστοσελίδες για να λύσει περίπλοκα επαγγελματικά προβλήματα, συντομεύοντας τη συνοπτική εργασία της έρευνας που χρειάζεται στους ανθρώπους 3 ώρες για να ολοκληρωθεί σε 3 λεπτά. Όπως φαίνεται στο παρακάτω βίντεο, για πολύπλοκα προβλήματα πολλαπλών βημάτων, το μοντέλο μπορεί να αναλύσει τις ανάγκες των χρηστών, πρώτα να αναζητήσει τις τεχνικές δυσκολίες του Chang'e 6 και μετά να αναζητήσει αντίστοιχες λύσεις για κάθε τεχνική δυσκολία και μετά να αναζητήσει την αποστολή στόχοι, τεχνικά μέσα, επιστημονικά Συγκρίνετε το σχέδιο προσεδάφισης Apollo 11 από τέσσερις πτυχές: αποτελέσματα και διεθνή συνεργασία και τέλος συνοψίστε τη συμβολή της χώρας μας στην επιτυχία της σεληνιακής εξερεύνησης.

Το Scholar·Puyu 2.5 είναι ανοιχτού κώδικα, θέτοντας ένα νέο σημείο αναφοράς στην ικανότητα συλλογισμού

Εκτός από τα μοντέλα ανοιχτού κώδικα, η Shusheng Puyu έχει λανσάρει ένα σύστημα εργαλείων ανοιχτού κώδικα πλήρους αλυσίδας για ανάπτυξη και εφαρμογή μεγάλων μοντέλων από τον Ιούλιο του περασμένου έτους, καλύπτοντας τους έξι κύριους συνδέσμους δεδομένων, προεκπαίδευση, τελειοποίηση, ανάπτυξη, αξιολόγηση, και εφαρμογή. Αυτά τα εργαλεία διευκολύνουν τους χρήστες να καινοτομούν και να εφαρμόζουν μεγάλα μοντέλα και προωθούν την ευημερία και την ανάπτυξη του μεγάλου μοντέλου οικοσυστήματος ανοιχτού κώδικα. Με την κυκλοφορία του InternLM2.5, ολόκληρο το σύστημα εργαλείων αλυσίδας έχει επίσης αναβαθμιστεί, οι σύνδεσμοι εφαρμογών έχουν επεκταθεί και νέα εργαλεία έχουν παρασχεθεί για διαφορετικές ανάγκες, όπως:

HuixiangDou Domain Knowledge Assistant (GitHub - InternLM/HuixiangDou: HuixiangDou: Ξεπερνώντας τα σενάρια ομαδικής συνομιλίας με τεχνική βοήθεια που βασίζεται στο LLM), ειδικά σχεδιασμένο για να αντιμετωπίζει πολύπλοκα τεχνικά ζητήματα σε ομαδικές συνομιλίες Είναι κατάλληλο για WeChat, Feishu, DingTalk και άλλες πλατφόρμες. εφαρμογές.

Έξυπνο εργαλείο εξαγωγής δεδομένων MinerU (GitHub - opendatalab/MinerU: Το MinerU είναι ένα εργαλείο εξαγωγής δεδομένων υψηλής ποιότητας, ανοιχτού κώδικα μιας στάσης, υποστηρίζει εξαγωγή PDF/ιστοσελίδων/e-book.), κατασκευασμένο για ανάλυση εγγράφων πολλαπλών μέσων, όχι μόνο μπορεί να μετατρέψει με ακρίβεια πολυτροπικά έγγραφα PDF, συμπεριλαμβανομένων εικόνων, πινάκων, τύπων κ.λπ. σε σαφή και εύκολη στην ανάλυση μορφή Markdown, αλλά και να αφαιρέσει διάφορες πληροφορίες παρεμβολών, όπως διαφημίσεις. Γρήγορη ανάλυση και εξαγωγή επίσημου περιεχομένου από ιστοσελίδες

Εκτός από το αυτο-αναπτυγμένο σύστημα εργαλείων ανοιχτού κώδικα πλήρους αλυσίδας, το InternLM2.5 αγκαλιάζει ενεργά την κοινότητα, είναι συμβατό με ένα ευρύ φάσμα κοινοτικών οικολογικών έργων και "πιάνει όλα" τα κύρια έργα ανοιχτού κώδικα.

Το Εργαστήριο Τεχνητής Νοημοσύνης της Σαγκάης εγκαινίασε το Μεγάλο Πρότυπο Πρακτορείο Μελετητή τον Δεκέμβριο του περασμένου έτους, το οποίο έλαβε ομόφωνα έπαινο από την κοινότητα Τους τελευταίους έξι μήνες, συνολικά 150.000 άτομα συμμετείχαν στην εκπαίδευση και περισσότερα από 600 οικολογικά έργα. έχει εκκολαφθεί. Με την ευκαιρία της κυκλοφορίας του InternLM2.5, ανακοινώσαμε επίσης επίσημα ότι το Shusheng·Puyu Large Model Practical Camp αναβαθμίστηκε επίσημα στο Scholar Large Model Practical Camp και θα προσθέσει σταδιακά περισσότερα μαθήματα Scholar Large Model System και πρακτικές ασκήσεις στο σας μεταφέρει από την είσοδο στο προχωρημένο Δεν υπάρχει οδοιπορικό στην εποχή του μοντέλου.

Η τρίτη φάση του Scholars Large Model Practical Camp θα ξεκινήσει επίσημα από τις 10 Ιουλίου έως τις 10 Αυγούστου Οι βοηθοί θα σας συνοδεύουν σε όλη τη διαδικασία, καθώς και το έγκυρο επίσημο Πιστοποιητικό, έρχονται γρήγοραΕγγραφείτεΜελετήστε το!

Σύνδεσμος εγγραφής:https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Το Shusheng Puyu ενισχύει την καινοτομία με συνεχή ανοιχτό κώδικα υψηλής ποιότητας, τηρεί τον ανοιχτό κώδικα και δωρεάν εμπορική χρήση και παρέχει καλύτερα μοντέλα και αλυσίδες εργαλείων για πρακτικά σενάρια εφαρμογής.