minhas informações de contato

Correspondência[email protected]

2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Em 3 de julho de 2024, o Laboratório de Inteligência Artificial de Xangai e o SenseTime, juntamente com a Universidade Chinesa de Hong Kong e a Universidade Fudan, lançaram oficialmente a nova geração do modelo de linguagem grande Puyu 2.5 (InternLM2.5). Comparado com o modelo da geração anterior, o InternLM2.5 tem três destaques marcantes:

A capacidade de raciocínio foi bastante aprimorada, liderando modelos de código aberto nacionais e estrangeiros da mesma magnitude, e até superando o Llama3-70B em dez vezes em algumas dimensões;

Suporta contexto de 1 milhão de tokens e pode lidar com textos longos de milhões de palavras;

Possui poderosos recursos de planejamento independente e chamada de ferramentas. Por exemplo, pode pesquisar centenas de páginas da web e conduzir análises integradas para problemas complexos.

O modelo InternLM2.5-7B está disponível hoje como código aberto, com modelos maiores e menores a serem lançados em um futuro próximo. O Laboratório de Inteligência Artificial de Xangai adere ao conceito de "permitir a inovação com código aberto contínuo de alta qualidade". Ao mesmo tempo que fornece consistentemente modelos de código aberto de alta qualidade à comunidade, também continuará a aderir ao licenciamento comercial gratuito.

Link GitHub:GitHub - InternLM/InternLM: Lançamento oficial dos modelos base e de chat InternLM2.5 7B. Suporte de contexto 1M Modelo HuggingFace:https://huggingface.co/internlm

Página inicial do estudioso·Puyu:Estudioso·Puyu

Com o rápido desenvolvimento de grandes modelos, os dados acumulados pelos humanos também são rapidamente consumidos. Como melhorar de forma eficiente o desempenho do modelo tornou-se um grande desafio enfrentado atualmente. Para isso, desenvolvemos novos dados sintéticos e volante de modelo. Por um lado, usamos dados sintéticos para compensar a falta de dados de alta qualidade no campo. Por outro lado, completamos continuamente a melhoria dos dados. reparo de defeitos por meio da auto-iteração do modelo, acelerando bastante o InternLM2.5 de iterações.

Para diferentes características de dados, desenvolvemos uma variedade de soluções tecnológicas de síntese de dados para garantir a qualidade de diferentes tipos de dados sintéticos, incluindo construção de dados baseada em regras, expansão de dados baseada em modelo e geração de dados baseada em feedback.

Durante o processo de desenvolvimento, o próprio modelo é usado continuamente para iteração do modelo. Com base no modelo atual, construímos um multiagente para triagem, avaliação e anotação de dados, o que melhorou muito a qualidade e a diversidade dos dados. Ao mesmo tempo, o modelo também é utilizado para produzir e refinar novos corpus, para que o modelo possa reparar os problemas descobertos durante o processo de treinamento.

A capacidade de raciocínio poderosa é uma base importante para que grandes modelos levem à inteligência artificial geral. O InternLM2.5 otimiza a capacidade de raciocínio como a capacidade central do modelo, fornecendo uma boa base para a aplicação de cenários complexos.

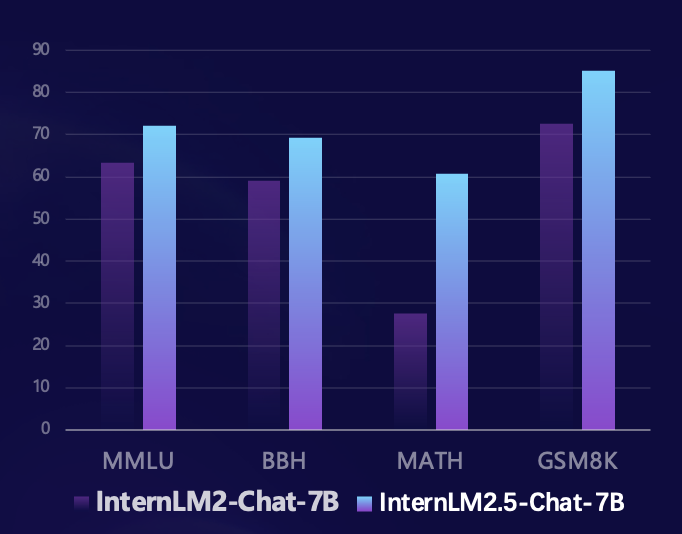

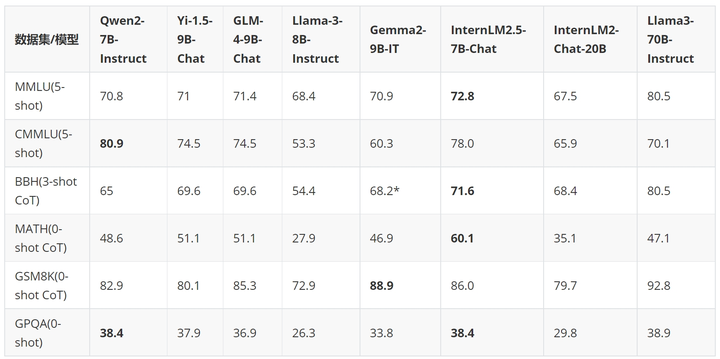

Com base na estrutura de avaliação de código aberto Sinan OpenCompass, a equipe de pesquisa usou um método de avaliação unificado e reproduzível para conduzir avaliações em vários conjuntos de avaliação confiáveis de capacidades de raciocínio. Em comparação com o modelo da geração anterior, o InternLM2.5 alcançou melhorias substanciais de desempenho em vários conjuntos de avaliação autoritativos de capacidades de raciocínio. Em particular, melhorou 100% no conjunto de avaliação matemática MATH composto por problemas de competição, atingindo 60% com parâmetros 7B. A taxa de precisão (atingindo o nível da versão GPT-4 Turbo 1106) demonstra plenamente o excelente desempenho do modelo no raciocínio matemático.

Nos últimos meses, o grande modelo de comunidade de código aberto desenvolveu-se rapidamente e surgiu um grande número de modelos excelentes. Comparado com os mais recentes modelos de código aberto no país e no exterior, o InternLM2.5-7B-Chat está à frente dos modelos da mesma magnitude na maioria dos conjuntos de avaliação de inferência. Em comparação com o modelo da geração anterior, alcançou transcendência de desempenho de magnitude cruzada. alguns casos Em termos de dimensões, supera até o Llama3-70B-Instruct que é dez vezes maior.

Usamos um exemplo para demonstrar as excelentes capacidades de raciocínio do InternLM2.5.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

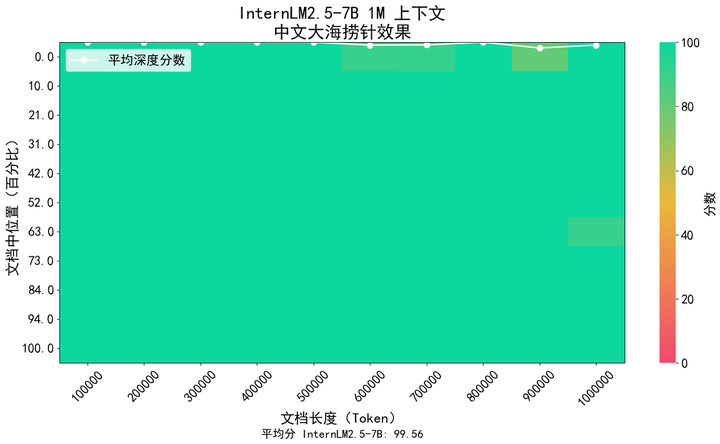

Em cenários de aplicação, como compreensão de documentos longos e interação complexa de agentes, o suporte ao comprimento de contexto do modelo tem requisitos mais elevados. InternLM2.5 propõe uma solução que aumenta o comprimento do contexto de 200K no modelo da geração anterior InternLM2 para 1M (aproximadamente 1,2 milhão de caracteres chineses), liberando ainda mais o potencial do modelo em aplicações de texto ultralongo. No pré-treinamento do modelo, filtramos textos com comprimento de token de 256K do corpus natural. Ao mesmo tempo, para evitar a mudança de domínio causada por um tipo de corpus muito único, complementamos com dados sintéticos, para que o modelo. pode expandir o contexto enquanto suas capacidades podem ser retidas tanto quanto possível.

Usamos o método popular de "agulha em um palheiro" na indústria para avaliar o conteúdo de recuperação de informações de texto longo do modelo. A figura abaixo mostra que o InternLM 2.5 alcançou uma recuperação de agulha em um palheiro quase perfeita dentro da faixa de 1 milhão de tokens, demonstrando texto longo extremamente forte. capacidades de processamento.

Além disso, também usamos o conjunto de avaliação de compreensão de texto longo amplamente utilizado LongBench para avaliação, e os resultados mostraram que o InternLM2.5 alcançou o melhor desempenho.

| GLM4-9B-Bate-papo-1M | Qwen2-7B-Instruir | Yi1.5-9B-bate-papo | EstagiárioLM2.5-7B-Chat-1M | |

| Banco longo | 46.5 | 41.2 | 37.2 | 47.4 |

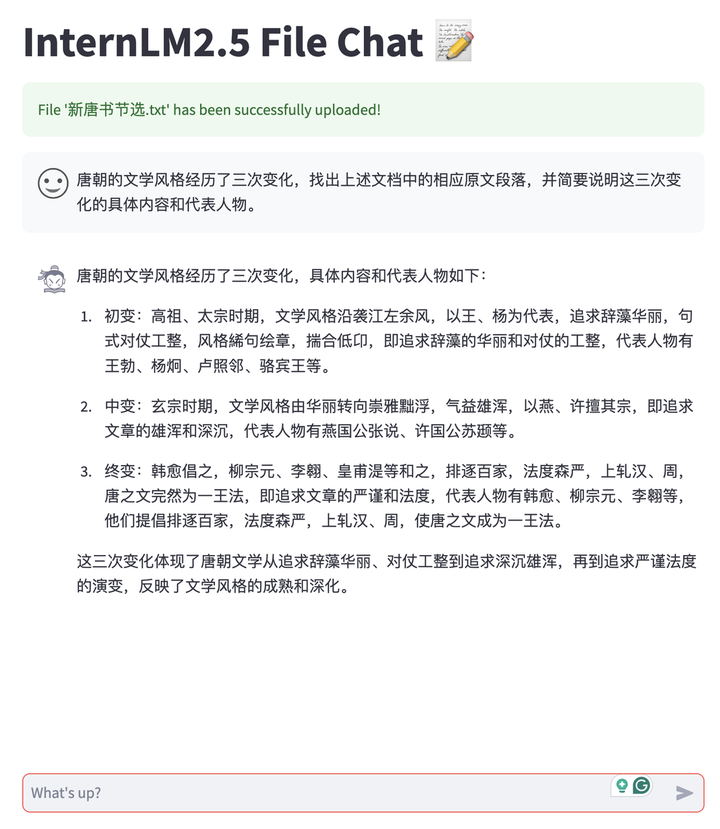

Contando com os recursos de texto longo do InternLM2.5, desenvolvemos um aplicativo de diálogo de documentos que oferece suporte ao modelo de implantação privada dos usuários e ao upload gratuito de documentos para diálogo. E todo o sistema é de código aberto para todos os links, tornando mais fácil para os usuários construí-lo com um clique, incluindo suporte de back-end de raciocínio de texto longo LMDeploy, análise de documentos multitipo MinerU e recursos de conversão, ferramentas de experiência de conversação front-end baseadas em Streamlit , etc. Atualmente ele oferece suporte a documentos TXT, Markdown e PDF e continuará a oferecer suporte a vários tipos de documentos de escritório, como Word e PPT no futuro.

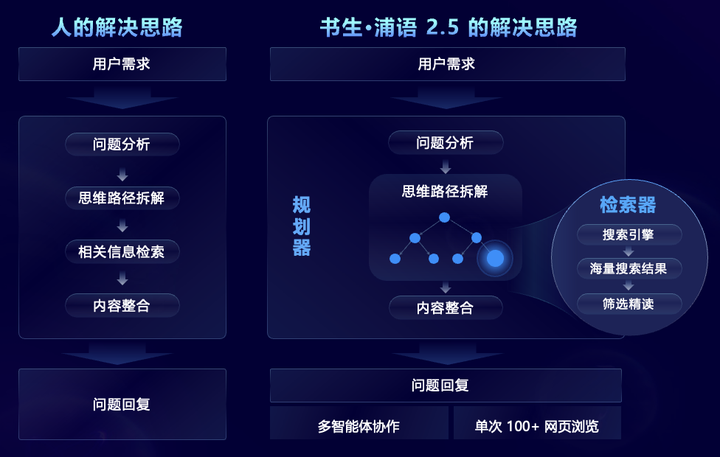

Visando cenários de problemas complexos que exigem busca e integração de informações complexas em grande escala, InternLM2.5 propõe de forma inovadora a estrutura multiagente MindSearch, que simula o processo de pensamento humano e introduz planejamento de tarefas, desmontagem de tarefas, pesquisa na web em larga escala e multi -fonte Resumo de informações e outras etapas para integrar efetivamente as informações da rede. Entre eles, o planejador concentra-se no planejamento de tarefas, desmontagem e indução de informações, utiliza programação de estrutura gráfica para planejamento e se expande dinamicamente de acordo com o status da tarefa. O buscador é responsável pela busca divergente e resumindo os resultados da busca na rede, para que todo o framework possa. basear-se em Filtrar, navegar e integrar informações de centenas de páginas da web.

Após recursos direcionados aprimorados, o InternLM2.5 pode filtrar, navegar e integrar com eficácia informações de centenas de páginas da web para resolver problemas profissionais complexos, reduzindo para 3 minutos o trabalho de resumo de pesquisa que leva 3 horas para humanos. Conforme mostrado no vídeo abaixo, para problemas complexos de várias etapas, o modelo pode analisar as necessidades do usuário, primeiro procurar as dificuldades técnicas do Chang'e 6, e depois procurar as soluções correspondentes para cada dificuldade técnica e, em seguida, procurar a missão objetivos, meios técnicos, científicos Comparar o plano de pouso lunar da Apollo 11 sob quatro aspectos: resultados e cooperação internacional e, finalmente, resumir a contribuição do nosso país para o sucesso da exploração lunar.

Scholar·Puyu 2.5 é de código aberto, estabelecendo um novo padrão em capacidade de raciocínio

Além dos modelos de código aberto, Shusheng Puyu lançou um sistema de ferramentas de código aberto de cadeia completa para desenvolvimento e aplicação de grandes modelos desde julho do ano passado, cobrindo os seis principais links de dados, pré-treinamento, ajuste fino, implantação, avaliação, e aplicação. Essas ferramentas facilitam a inovação e a aplicação de grandes modelos pelos usuários e promovem a prosperidade e o desenvolvimento do ecossistema de código aberto de grandes modelos. Com o lançamento do InternLM2.5, todo o sistema de ferramentas da cadeia também foi atualizado, os links de aplicação foram expandidos e novas ferramentas foram fornecidas para diferentes necessidades, incluindo:

Assistente de conhecimento de domínio HuixiangDou (GitHub - InternLM/HuixiangDou: HuixiangDou: Superando cenários de bate-papo em grupo com assistência técnica baseada em LLM), especialmente projetado para lidar com questões técnicas complexas em bate-papos em grupo. É adequado para WeChat, Feishu, DingTalk e outras plataformas. Ele fornece front-end e back-end completos para web, Android e códigos-fonte de algoritmos e oferece suporte a nível industrial. formulários.

Ferramenta inteligente de extração de dados MinerU (GitHub - opendatalab/MinerU: MinerU é uma ferramenta de extração de dados completa, de código aberto e de alta qualidade, que suporta extração de PDF/páginas da web/e-books.), desenvolvido para análise de documentos multimodais, pode não apenas converter com precisão documentos PDF multimodais, incluindo imagens, tabelas, fórmulas, etc. em um formato Markdown claro e fácil de analisar, mas também remover várias informações de interferência, como anúncios. Analise e extraia rapidamente conteúdo formal de páginas da web

Além do sistema de ferramentas de código aberto de cadeia completa autodesenvolvido, o InternLM2.5 abraça ativamente a comunidade, é compatível com uma ampla gama de projetos ecológicos comunitários e "captura todos" os principais projetos de código aberto.

O Laboratório de Inteligência Artificial de Xangai lançou o Acampamento Prático de Grandes Modelos Scholar Puyu em dezembro do ano passado, que recebeu elogios unânimes da comunidade. Nos últimos seis meses, um total de 150.000 pessoas participaram do treinamento e mais de 600 projetos ecológicos foram realizados. foi chocado. Por ocasião do lançamento do InternLM2.5, também anunciamos oficialmente que o Acampamento Prático de Modelo Grande Scholar·Puyu foi oficialmente atualizado para o Acampamento Prático de Modelo Grande Acadêmico e adicionará gradualmente mais cursos de Sistema de Modelo Grande Acadêmico e exercícios práticos para leva você do básico ao avançado. Não há jornada na era do modelo.

A terceira fase do Acampamento Prático de Modelo Grande para Acadêmicos será lançada oficialmente de 10 de julho a 10 de agosto. No acampamento prático, todos serão guiados passo a passo para ajustar e implantar o modelo InternLM2.5 Gratuito de computação e ensino. assistentes irão acompanhá-lo durante todo o processo, bem como certificado oficial oficial, venha rapidamenteInscrever-seEstude-o!

Link de inscrição:https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu capacita a inovação com código aberto contínuo de alta qualidade, adere ao código aberto e ao uso comercial gratuito e fornece melhores modelos e cadeias de ferramentas para cenários de aplicação práticos.