내 연락처 정보

우편메소피아@프로톤메일.com

2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

2024년 7월 3일, 상하이 인공 지능 연구소(Shanghai Artificial Intelligence Laboratory)와 SenseTime은 홍콩 중문 대학교 및 푸단 대학교와 함께 차세대 대형 언어 모델 Puyu 2.5(InternLM2.5)를 공식 출시했습니다. 이전 세대 모델과 비교하여 InternLM2.5에는 세 가지 뛰어난 특징이 있습니다.

추론 능력이 크게 향상되어 동일한 크기의 국내외 오픈 소스 모델을 선도하고 일부 차원에서는 Llama3-70B를 10배 능가합니다.

1M 토큰 컨텍스트를 지원하고 수백만 단어의 긴 텍스트를 처리할 수 있습니다.

예를 들어, 수백 개의 웹 페이지를 검색하고 복잡한 문제에 대한 통합 분석을 수행할 수 있습니다.

InternLM2.5-7B 모델은 현재 오픈 소스로 제공되며 가까운 시일 내에 더 크고 작은 모델이 출시될 예정입니다. Shanghai Artificial Intelligence Laboratory는 "지속적인 고품질 오픈 소스로 혁신을 실현한다"는 개념을 고수하며 고품질 오픈 소스 모델을 커뮤니티에 지속적으로 제공하는 동시에 무료 상용 라이센스도 계속 고수할 것입니다.

GitHub 링크:GitHub - InternLM/InternLM: InternLM2.5 7B 기반 및 채팅 모델의 공식 릴리스. 1M 컨텍스트 지원 포옹얼굴 모델:https://huggingface.co/internlm에 오신 것을 환영합니다.에 오신 것을 환영합니다.

학자·푸유 홈페이지:학자·푸유

대형 모델의 급속한 발전과 함께 인간이 축적한 데이터도 급속히 소모되고 있으며, 어떻게 효율적으로 모델 성능을 향상시킬 것인가가 현재 직면한 주요 과제로 대두되고 있습니다. 이를 위해 새로운 합성 데이터와 모델 플라이휠을 개발하여 한편으로는 현장에서 부족한 고품질 데이터를 보완하기 위해 합성 데이터를 활용하고 있으며, 다른 한편으로는 지속적으로 데이터 개선을 완료하고 있습니다. 모델의 자체 반복을 통해 결함을 수정하여 InternLM2.5의 반복 속도를 크게 높입니다.

다양한 데이터 특성에 대해 우리는 규칙 기반 데이터 구성, 모델 기반 데이터 확장 및 피드백 기반 데이터 생성을 포함하여 다양한 유형의 합성 데이터의 품질을 보장하기 위해 다양한 데이터 합성 기술 솔루션을 개발했습니다.

개발 과정에서 모델 자체는 모델 반복을 위해 지속적으로 사용됩니다. 현재 모델을 기반으로 데이터 스크리닝, 평가, 주석을 위한 멀티 에이전트를 구축하여 데이터의 품질과 다양성을 크게 향상시켰습니다. 동시에 모델은 새로운 코퍼스를 생성하고 개선하는 데에도 사용되므로 모델은 훈련 과정에서 발견된 문제를 복구할 수 있습니다.

강력한 추론 능력은 대형 모델이 일반 인공지능으로 이어지는 중요한 기반입니다. InternLM2.5는 추론 능력을 모델의 핵심 능력으로 최적화하여 복잡한 시나리오 적용을 위한 좋은 기반을 제공합니다.

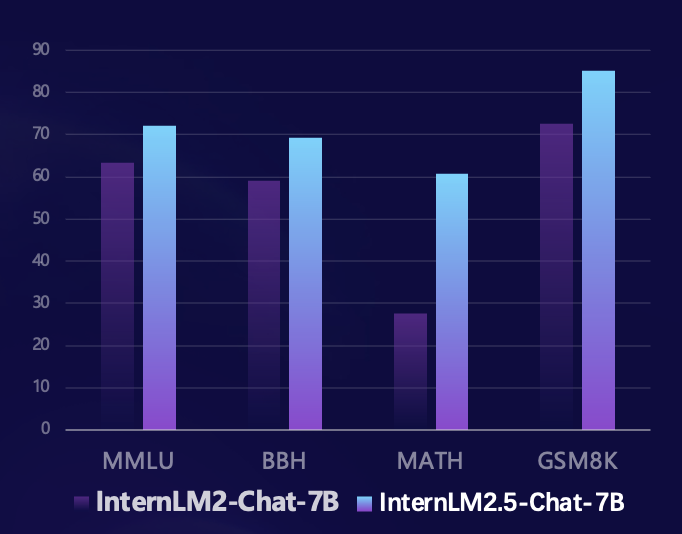

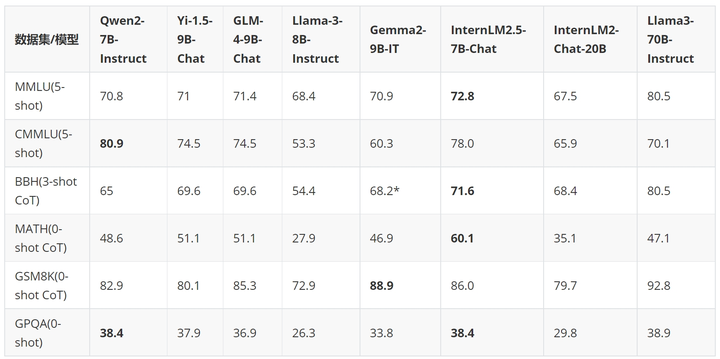

연구팀은 Sinan OpenCompass 오픈 소스 평가 프레임워크를 기반으로 통일되고 재현 가능한 평가 방법을 사용하여 추론 능력에 대한 여러 권위 있는 평가 세트에 대한 평가를 수행했습니다. 이전 세대 모델과 비교하여 InternLM2.5는 추론 기능의 여러 권위 있는 평가 세트에서 상당한 성능 향상을 달성했습니다. 특히 경쟁 문제로 구성된 수학 평가 세트 MATH에서 100% 향상되어 7B 매개변수로 60%에 도달했습니다. . 정확도(GPT-4 Turbo 1106 버전 수준에 도달)는 수학적 추론에서 모델의 탁월한 성능을 완벽하게 보여줍니다.

지난 몇 달 동안 대규모 모델 오픈 소스 커뮤니티가 빠르게 발전했으며 수많은 우수한 모델이 등장했습니다. 국내외 최신 오픈 소스 모델과 비교하면 InternLM2.5-7B-Chat은 대부분의 추론 평가 세트에서 동일한 크기의 모델보다 앞서 있으며 이전 세대 모델과 비교하면 크기 간 성능 초월을 달성했습니다. 어떤 경우에는 크기 면에서 10배나 큰 Llama3-70B-Instruct를 능가하기도 합니다.

InternLM2.5의 뛰어난 추론 기능을 보여주기 위해 예제를 사용합니다.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

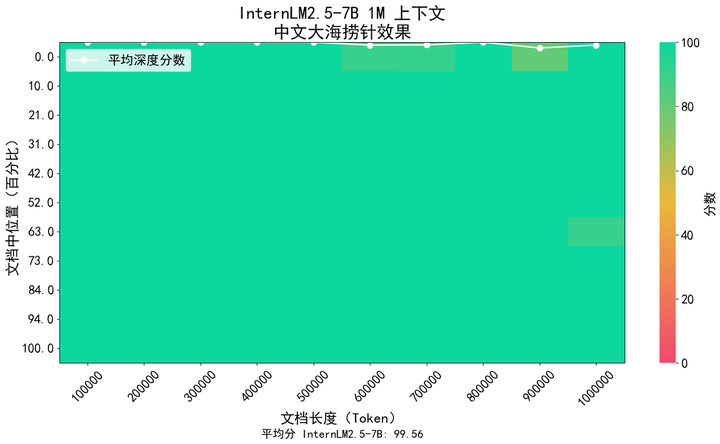

긴 문서 이해 및 복잡한 에이전트 상호 작용과 같은 애플리케이션 시나리오에서는 모델의 컨텍스트 길이 지원에 대한 요구 사항이 더 높습니다. InternLM2.5는 이전 세대 모델인 InternLM2의 200K에서 1M(한자 약 120만 자)로 컨텍스트 길이를 늘리는 솔루션을 제안하여 매우 긴 텍스트 애플리케이션에서 모델의 잠재력을 더욱 발휘합니다. 모델의 사전 훈련에서는 자연 코퍼스에서 256K 토큰 길이 텍스트를 선별하는 동시에 너무 단일 유형의 코퍼스로 인한 도메인 이동을 피하기 위해 합성 데이터로 보완하여 모델을 만들었습니다. 그 능력을 최대한 유지하면서 컨텍스트를 확장할 수 있습니다.

업계에서 널리 사용되는 "건초 더미 속의 바늘" 방법을 사용하여 모델의 긴 텍스트 정보 회상 내용을 평가했습니다. 아래 그림은 InternLM 2.5가 1M 토큰 범위 내에서 건초 더미에서 거의 완벽한 바늘을 달성하여 매우 강력한 긴 텍스트를 보여줍니다. 처리 능력.

또한, 널리 사용되는 장문 독해 평가 세트인 LongBench를 사용하여 평가한 결과 InternLM2.5가 가장 좋은 성능을 보였다.

| GLM4-9B-채팅-1M | Qwen2-7B-지시 | Yi1.5-9B-채팅 | 인턴LM2.5-7B-채팅-1M | |

| 롱벤치 | 46.5 | 41.2 | 37.2 | 47.4 |

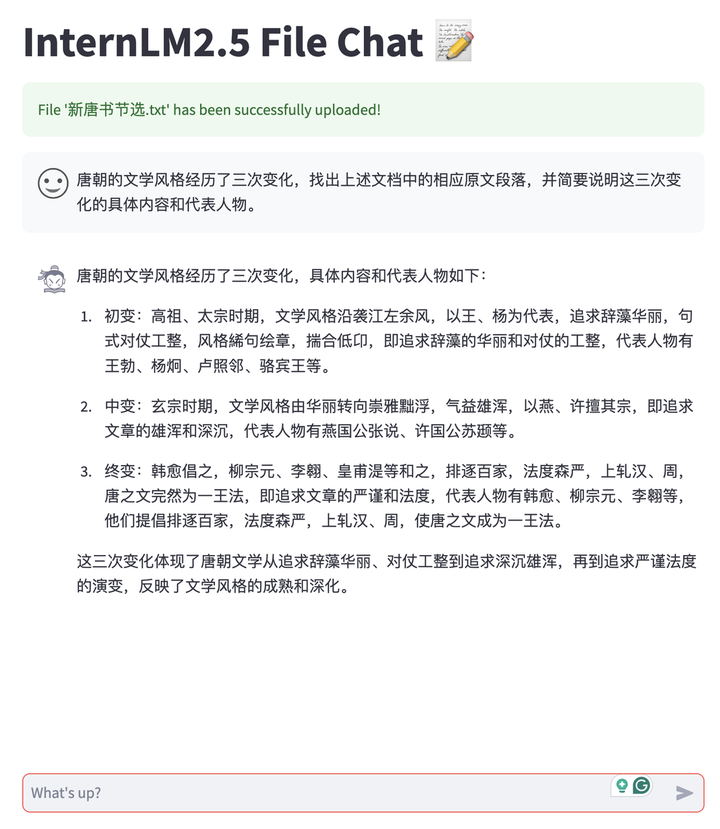

InternLM2.5의 장문 기능을 활용하여 사용자의 개인화된 배포 모델과 대화용 문서의 무료 업로드를 지원하는 문서 대화 애플리케이션을 개발했습니다. 그리고 전체 시스템은 모든 링크가 포함된 오픈 소스이므로 LMDeploy 긴 텍스트 추론 백엔드 지원, MinerU 다중 유형 문서 구문 분석 및 변환 기능, Streamlit 기반 프런트 엔드 대화 경험 도구를 포함하여 사용자가 한 번의 클릭으로 쉽게 구축할 수 있습니다. , 등. 현재는 TXT, Markdown, PDF 문서를 지원하고 있으며, 앞으로도 Word, PPT 등 다양한 Office 문서 형식을 계속 지원할 예정입니다.

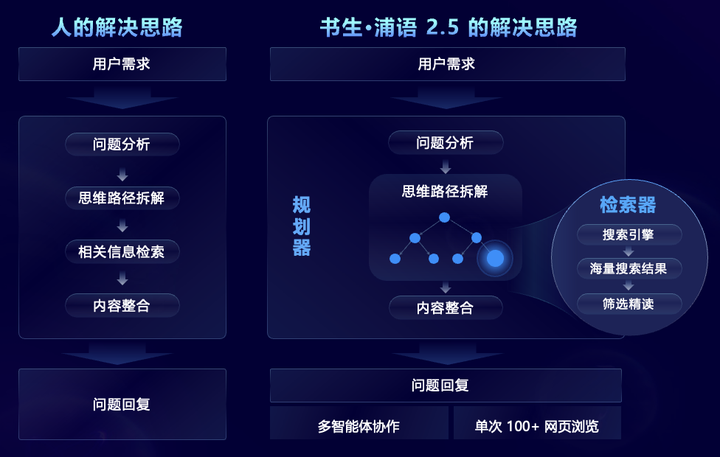

InternLM2.5는 대규모의 복잡한 정보 검색 및 통합이 필요한 복잡한 문제 시나리오를 목표로 인간의 사고 과정을 시뮬레이션하고 작업 계획, 작업 해체, 대규모 웹 검색 및 다중 기능을 도입하는 MindSearch 다중 에이전트 프레임워크를 혁신적으로 제안합니다. - 네트워크 정보를 효과적으로 통합하기 위한 소스 정보 요약 및 기타 단계. 그 중 플래너는 작업 계획, 분해 및 정보 유도에 중점을 두고 그래프 구조 프로그래밍을 사용하여 작업 상태에 따라 동적으로 확장하며 분기 검색 및 네트워크 검색 결과를 요약하는 역할을 담당하므로 전체 프레임워크가 가능합니다. 수백 개의 웹 페이지에서 정보를 필터링하고 찾아보고 통합합니다.

향상된 타겟팅 기능을 갖춘 InternLM2.5는 수백 개의 웹 페이지에서 정보를 효과적으로 필터링, 검색 및 통합하여 복잡한 전문 문제를 해결하고 인간이 완료하는 데 3시간이 걸리는 연구 요약 작업을 3분으로 단축할 수 있습니다. 아래 동영상에서 볼 수 있듯이 다단계 복잡한 문제의 경우 모델은 사용자 요구를 분석하고 먼저 Chang'e 6의 기술적 어려움을 검색한 다음 각 기술적 어려움에 해당하는 솔루션을 검색한 다음 임무를 검색할 수 있습니다. 목표, 기술적 수단, 과학적 아폴로 11호 달착륙 계획을 결과, 국제협력이라는 4가지 측면에서 비교하고, 최종적으로 달탐사 성공에 대한 우리나라의 기여를 요약한다.

Scholar·Puyu 2.5는 오픈소스로 추론 능력의 새로운 기준을 제시합니다.

Shusheng Puyu는 오픈 소스 모델 외에도 작년 7월부터 대규모 모델 개발 및 적용을 위한 풀체인 오픈 소스 도구 시스템을 출시했으며, 이는 데이터, 사전 훈련, 미세 조정, 배포, 평가, 그리고 신청. 이러한 도구를 사용하면 사용자가 대형 모델을 더 쉽게 혁신하고 적용할 수 있으며 대형 모델 오픈 소스 생태계의 번영과 발전을 촉진할 수 있습니다. InternLM2.5 출시로 전체 체인 도구 시스템도 업그레이드되고 응용 프로그램 링크가 확장되었으며 다음을 포함하여 다양한 요구에 맞는 새로운 도구가 제공되었습니다.

HuixiangDou 도메인 지식 도우미(GitHub - InternLM/HuixiangDou: HuixiangDou: LLM 기반 기술 지원을 통한 그룹 채팅 시나리오 극복)은 그룹 채팅의 복잡한 기술 문제를 처리하도록 특별히 설계되었습니다. WeChat, Feishu, DingTalk 및 기타 플랫폼에 적합하며 완전한 프런트엔드 및 백엔드 웹, Android 및 알고리즘 소스 코드를 제공하며 산업 등급을 지원합니다. 응용 프로그램.

MinerU 스마트 데이터 추출 도구(GitHub - opendatalab/MinerU: MinerU는 원스톱, 오픈 소스, 고품질 데이터 추출 도구로 PDF/웹페이지/전자책 추출을 지원합니다.)는 다중 모드 문서 구문 분석을 위해 구축되었으며 그림, 표, 수식 등을 포함한 다중 모드 PDF 문서를 명확하고 분석하기 쉬운 마크다운 형식으로 정확하게 변환할 수 있을 뿐만 아니라 광고와 같은 다양한 간섭 정보를 제거할 수 있습니다. 웹페이지의 공식 콘텐츠를 빠르게 구문 분석하고 추출합니다.

자체 개발한 전체 체인 오픈 소스 도구 시스템 외에도 InternLM2.5는 커뮤니티를 적극적으로 수용하고 광범위한 커뮤니티 생태 프로젝트와 호환되며 주류 오픈 소스 프로젝트를 "모두 포착"합니다.

상하이 인공지능연구소는 지난해 12월 학자·푸유 대형모델 실무캠프를 시작해 지역사회로부터 만장일치의 찬사를 받았다. 지난 6개월 동안 총 15만 명이 훈련에 참여했고 600개 이상의 생태 프로젝트가 진행됐다. 부화되었습니다. InternLM2.5 출시를 계기로 Shusheng·Puyu 대형 모델 실습 캠프가 공식적으로 Scholar Large Model Practical Camp로 업그레이드되었음을 공식 발표했으며, 점차적으로 더 많은 Scholar Large Model System 과정과 실습을 추가할 예정입니다. 초보부터 고급까지 안내합니다. 모델 시대에는 트레킹이 없습니다.

Scholars Large Model Practical Camp의 세 번째 단계는 7월 10일부터 8월 10일까지 공식적으로 시작됩니다. 실습 캠프에서는 모든 사람이 InternLM2.5 모델을 무료로 조정하고 배포할 수 있도록 단계별로 안내합니다. 모든 과정에 보조원이 동행할 뿐만 아니라 권위 있는 공식 인증서도 신속하게 제공됩니다.가입하기공부하세요!

등록 링크:https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu는 지속적인 고품질 오픈 소스를 통해 혁신을 강화하고 오픈 소스 및 무료 상업용 사용을 준수하며 실제 애플리케이션 시나리오를 위한 더 나은 모델과 도구 체인을 제공합니다.