le mie informazioni di contatto

Posta[email protected]

2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Il 3 luglio 2024, Shanghai Artificial Intelligence Laboratory e SenseTime, insieme all'Università cinese di Hong Kong e all'Università di Fudan, hanno rilasciato ufficialmente la nuova generazione del modello linguistico di grandi dimensioni Puyu 2.5 (InternLM2.5). Rispetto al modello della generazione precedente, InternLM2.5 presenta tre punti salienti eccezionali:

La capacità di ragionamento è stata notevolmente migliorata, portando modelli open source nazionali ed esteri della stessa grandezza e addirittura superando Llama3-70B di dieci volte in alcune dimensioni;

Supporta il contesto di token da 1 milione e può gestire testi lunghi milioni di parole;

Dispone di potenti funzionalità di pianificazione e chiamata di strumenti indipendenti. Ad esempio, può effettuare ricerche in centinaia di pagine Web e condurre analisi integrate per problemi complessi.

Il modello InternLM2.5-7B è oggi disponibile come open source, con modelli più grandi e più piccoli che verranno rilasciati nel prossimo futuro. Lo Shanghai Artificial Intelligence Laboratory aderisce al concetto di "consentire l'innovazione con un open source continuo di alta qualità". Pur fornendo costantemente modelli open source di alta qualità alla comunità, continuerà anche ad aderire alle licenze commerciali gratuite.

Collegamento GitHub:GitHub - InternLM/InternLM: Rilascio ufficiale di InternLM2.5 7B modelli base e chat. Supporto di contesto 1M Modello HuggingFace:https://huggingface.co/internlm

Homepage dello studioso·Puyu:Studioso·Puyu

Con il rapido sviluppo di modelli di grandi dimensioni, anche i dati accumulati dagli esseri umani vengono rapidamente consumati. Come migliorare in modo efficiente le prestazioni dei modelli è diventata una delle principali sfide attualmente affrontate. A tal fine, abbiamo sviluppato nuovi dati sintetici e un modello di volano. Da un lato, utilizziamo dati sintetici per compensare la mancanza di dati di alta qualità sul campo, dall'altro, completiamo continuamente il miglioramento dei dati riparazione dei difetti attraverso l'autoiterazione del modello, accelerando così notevolmente le iterazioni InternLM2.5.

Per diverse caratteristiche dei dati, abbiamo sviluppato una varietà di soluzioni tecnologiche di sintesi dei dati per garantire la qualità di diversi tipi di dati sintetici, tra cui la costruzione di dati basata su regole, l'espansione dei dati basata su modelli e la generazione di dati basata sul feedback.

Durante il processo di sviluppo, il modello stesso viene continuamente utilizzato per l'iterazione del modello. Sulla base del modello attuale, abbiamo creato un multi-agente per lo screening, la valutazione e l'annotazione dei dati, che ha notevolmente migliorato la qualità e la diversità dei dati. Allo stesso tempo, il modello viene utilizzato anche per produrre e perfezionare un nuovo corpus, in modo che il modello possa riparare i problemi scoperti durante il processo di formazione.

La potente capacità di ragionamento è una base importante per consentire a modelli di grandi dimensioni di portare all'intelligenza artificiale generale. InternLM2.5 ottimizza la capacità di ragionamento come capacità principale del modello, fornendo una buona base per l'applicazione di scenari complessi.

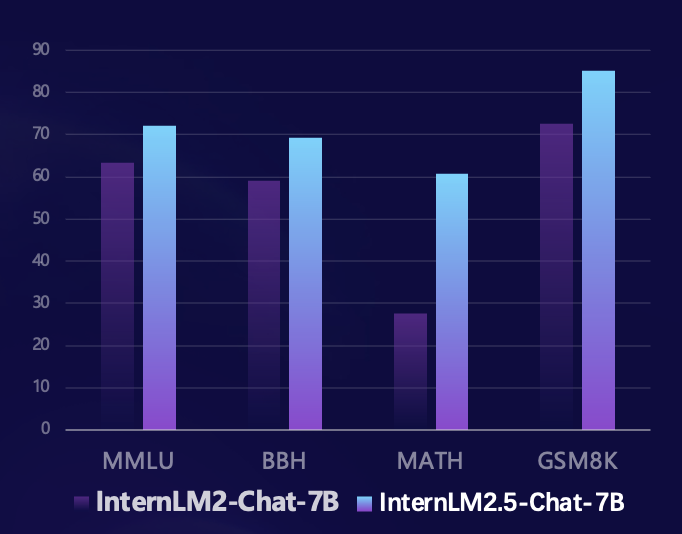

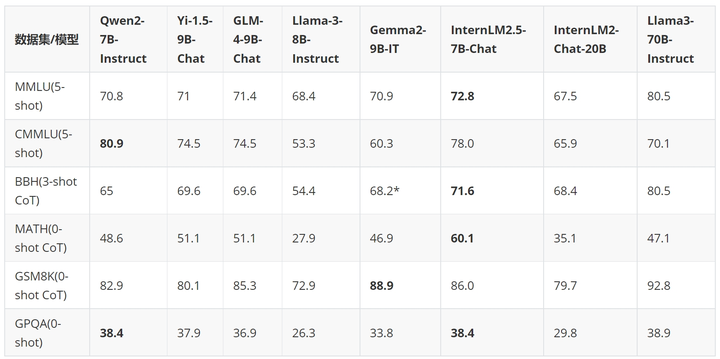

Basandosi sul quadro di valutazione open source Sinan OpenCompass, il team di ricerca ha utilizzato un metodo di valutazione unificato e riproducibile per condurre valutazioni su più insiemi di valutazione autorevoli di capacità di ragionamento. Rispetto al modello della generazione precedente, InternLM2.5 ha ottenuto miglioramenti sostanziali delle prestazioni su più set di valutazione autorevoli di capacità di ragionamento. In particolare, è migliorato del 100% sul set di valutazione matematica MATH composto da problemi di competizione, raggiungendo il 60% con parametri 7B. Il tasso di precisione (che raggiunge il livello della versione GPT-4 Turbo 1106) dimostra pienamente le eccellenti prestazioni del modello nel ragionamento matematico.

Negli ultimi mesi, la grande comunità di modelli open source si è sviluppata rapidamente ed è emerso un gran numero di modelli eccellenti. Rispetto agli ultimi modelli open source in patria e all'estero, InternLM2.5-7B-Chat è in vantaggio rispetto ai modelli della stessa grandezza nella maggior parte dei set di valutazione dell'inferenza. Rispetto al modello della generazione precedente, ha raggiunto la trascendenza delle prestazioni di grandezza incrociata in alcuni casi, in termini di dimensioni, supera addirittura il Llama3-70B-Instruct che è dieci volte più grande.

Utilizziamo un esempio per dimostrare le eccellenti capacità di ragionamento di InternLM2.5.

- User:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

- | 3 | 日本(JPN) | 27 | 14 | 17 | 58 |

- | 4 | 英国(GBR) | 22 | 20 | 22 | 64 |

- | 5 | 俄罗斯奥林匹克委员会(ROC)| 20 | 28 | 23 | 71 |

- | 6 | 澳大利亚(AUS) | 17 | 7 | 22 | 46 |

- | 7 | 荷兰(NED) | 10 | 12 | 14 | 36 |

- | 8 | 法国(FRA) | 10 | 12 | 11 | 33 |

- | 9 | 德国(GER) | 10 | 11 | 16 | 37 |

- | 10 | 意大利(ITA) | 10 | 10 | 20 | 40 |

-

- 根据提供的2020年东京奥运会奖牌榜部分信息,请回答列表中属于北美洲国家和大洋洲国家的银牌奖牌和是多少?

-

- Assistant:

-

- 根据提供的信息,北美洲和大洋洲国家的银牌奖牌数如下:

-

- 北美洲国家:

- - 美国(USA):41枚银牌

- - 加拿大(未在列表中,但作为北美洲国家,其银牌数未提供)

-

- 大洋洲国家:

- - 澳大利亚(AUS):7枚银牌

-

- 因此,北美洲和大洋洲国家的银牌总数为:

- 41(美国)+ 7(澳大利亚)= 48枚银牌。

-

- User:

-

- 根据我提供的信息,现在请你在排名前3的国家中,将金、银、铜牌每一项都至少有15枚的所有国家筛选出来,绘制成表格,请一步步思考来完成这个问题

-

- Assistant:

-

- 好的,让我们一步步来解决这个问题。

-

- 首先,我们需要确定排名前3的国家,根据您提供的信息,这些国家是美国、中国和日本。

-

- 接下来,我们需要筛选出这些国家中,金、银、铜牌每一项都至少有15枚的国家。

-

- 让我们逐一检查这些国家:

-

- 1. 美国(USA):金牌39枚,银牌41枚,铜牌33枚。所有奖牌数都超过了15枚,因此美国符合条件。

-

- 2. 中国(CHN):金牌38枚,银牌32枚,铜牌19枚。所有奖牌数都超过了15枚,因此中国符合条件。

-

- 3. 日本(JPN):金牌27枚,银牌14枚,铜牌17枚。只有金牌数超过了15枚,因此日本不符合条件。

-

- 因此,只有美国和中国符合条件。现在我们可以将这些信息绘制成表格:

-

- | 排名 | 国家 / 地区 | 金牌 | 银牌 | 铜牌 | 总计 |

- |------|---------------------|------|------|------|------|

- | 1 | 美国(USA) | 39 | 41 | 33 | 113 |

- | 2 | 中国(CHN) | 38 | 32 | 19 | 89 |

-

- 请注意,日本(JPN)虽然金牌数超过了15枚,但银牌和铜牌数没有达到要求,因此没有包含在表格中。

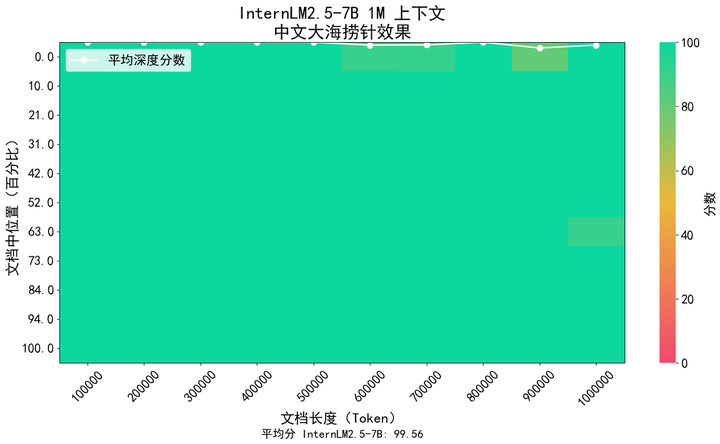

Negli scenari applicativi come la comprensione di documenti lunghi e l'interazione complessa con agenti, il supporto della lunghezza del contesto del modello ha requisiti più elevati. InternLM2.5 propone una soluzione che aumenta la lunghezza del contesto da 200K nel modello InternLM2 della generazione precedente a 1M (circa 1,2 milioni di caratteri cinesi), liberando ulteriormente il potenziale del modello in applicazioni di testo ultra-lunghe. Nel pre-addestramento del modello, abbiamo selezionato testi con lunghezza token di 256K dal corpus naturale. Allo stesso tempo, per evitare spostamenti di dominio causati da un tipo di corpus troppo singolo, lo abbiamo integrato con dati sintetici, in modo che il modello. può espandere il contesto mantenendo le sue capacità il più possibile.

Abbiamo utilizzato il popolare metodo "ago in un pagliaio" nel settore per valutare il contenuto del richiamo delle informazioni di testo lungo del modello. La figura seguente mostra che InternLM 2.5 ha ottenuto un richiamo quasi perfetto dell'ago in un pagliaio all'interno dell'intervallo di token 1M, dimostrando un testo lungo estremamente forte. capacità di elaborazione.

Inoltre, per la valutazione abbiamo utilizzato anche il set di valutazione della comprensione di testi lunghi ampiamente utilizzato LongBench e i risultati hanno mostrato che InternLM2.5 ha ottenuto le migliori prestazioni.

| GLM4-9B-Chat-1M | Qwen2-7B-Istruisci | Yi1.5-9B-chat | InternLM2.5-7B-Chat-1M | |

| Panchina lunga | 46.5 | 41.2 | 37.2 | 47.4 |

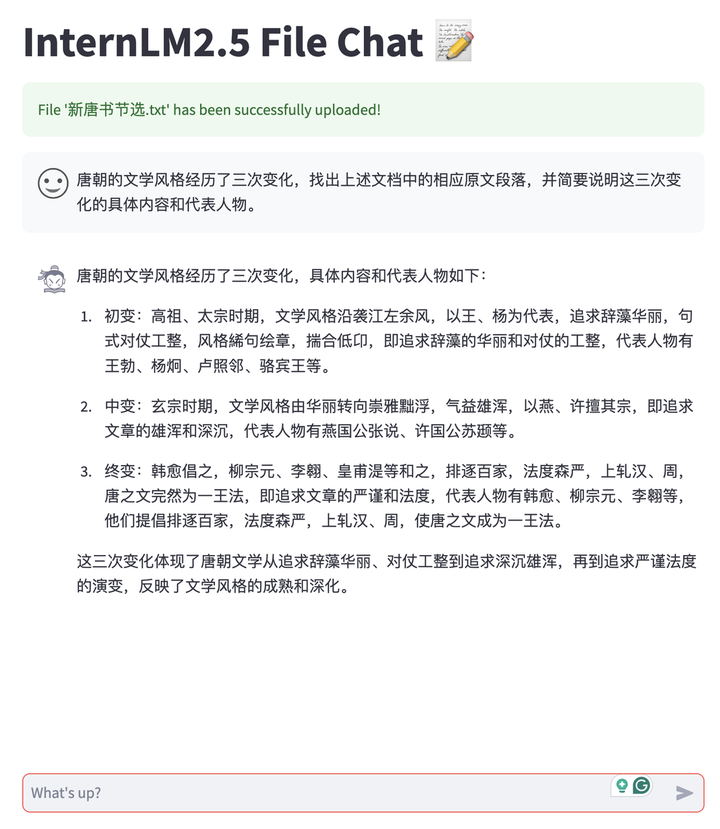

Basandoci sulle funzionalità di testo lungo di InternLM2.5, abbiamo sviluppato un'applicazione di conversazione di documenti che supporta il modello di distribuzione privatizzato degli utenti e il caricamento gratuito di documenti per la conversazione. Inoltre, l'intero sistema è open source con tutti i collegamenti, facilitando la creazione da parte degli utenti con un clic, incluso il supporto backend per il ragionamento di testi lunghi LMDeploy, funzionalità di analisi e conversione di documenti multitipo MinerU, strumenti di esperienza di conversazione front-end basati su Streamlit. , eccetera. Attualmente supporta documenti TXT, Markdown e PDF e in futuro continuerà a supportare vari tipi di documenti Office come Word e PPT.

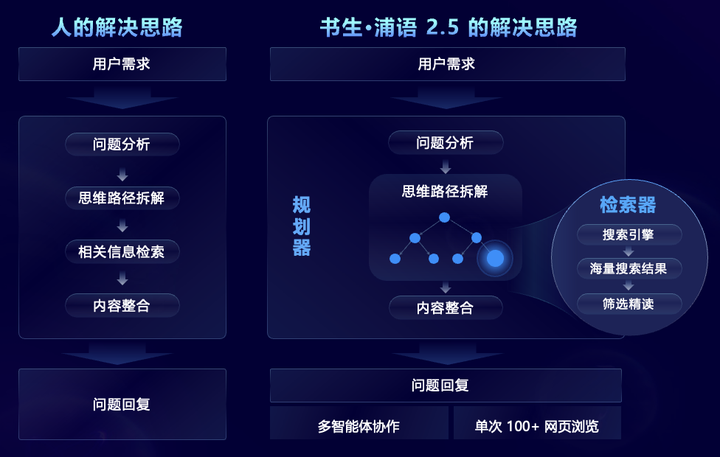

Mirando a scenari problematici complessi che richiedono ricerca e integrazione di informazioni complesse su larga scala, InternLM2.5 propone in modo innovativo il framework multi-agente MindSearch, che simula il processo di pensiero umano e introduce la pianificazione delle attività, lo smantellamento delle attività, la ricerca web su larga scala e multi -source Riepilogo delle informazioni e altri passaggi per integrare efficacemente le informazioni di rete. Tra questi, il pianificatore si concentra sulla pianificazione delle attività, sullo smontaggio e sull'induzione di informazioni, utilizza la programmazione della struttura del grafico per pianificare e si espande dinamicamente in base allo stato dell'attività. Il ricercatore è responsabile della ricerca divergente e del riepilogo dei risultati della ricerca di rete, in modo che l'intero framework possa farlo essere basato su Filtra, sfoglia e integra informazioni da centinaia di pagine web.

Dopo aver potenziato le funzionalità mirate, InternLM2.5 può filtrare, sfogliare e integrare in modo efficace le informazioni da centinaia di pagine Web per risolvere problemi professionali complessi, riducendo a 3 minuti il lavoro di riepilogo della ricerca che richiede agli esseri umani 3 ore per essere completato. Come mostrato nel video qui sotto, per problemi complessi in più fasi, il modello può analizzare le esigenze degli utenti, cercare prima le difficoltà tecniche di Chang'e 6, quindi cercare le soluzioni corrispondenti per ciascuna difficoltà tecnica, quindi cercare la missione obiettivi, mezzi tecnici, scientifici Confrontare il piano di atterraggio lunare dell’Apollo 11 sotto quattro aspetti: risultati e cooperazione internazionale, e infine riassumere il contributo del nostro Paese al successo dell’esplorazione lunare.

Scholar·Puyu 2.5 è open source e stabilisce un nuovo punto di riferimento nella capacità di ragionamento

Oltre ai modelli open source, Shusheng Puyu ha lanciato dal luglio dello scorso anno un sistema di strumenti open source a catena completa per lo sviluppo e l'applicazione di modelli di grandi dimensioni, che copre i sei principali collegamenti di dati, pre-formazione, messa a punto, implementazione, valutazione, e applicazione. Questi strumenti rendono più semplice per gli utenti innovare e applicare modelli di grandi dimensioni e promuovere la prosperità e lo sviluppo dell’ecosistema open source di modelli di grandi dimensioni. Con il rilascio di InternLM2.5, anche l'intero sistema di strumenti della catena è stato aggiornato, i collegamenti delle applicazioni sono stati ampliati e sono stati forniti nuovi strumenti per diverse esigenze, tra cui:

Assistente alla conoscenza del dominio HuixiangDou (GitHub - InternLM/HuixiangDou: HuixiangDou: Superare gli scenari di chat di gruppo con l'assistenza tecnica basata su LLM), appositamente progettato per gestire problemi tecnici complessi nelle chat di gruppo. È adatto per WeChat, Feishu, DingTalk e altre piattaforme. Fornisce codici sorgente web front-end e back-end completi, Android e algoritmi e supporta livello industriale applicazioni.

Strumento di estrazione intelligente dei dati MinerU (GitHub - opendatalab/MinerU: MinerU è uno strumento di estrazione dati open source, completo e di alta qualità, che supporta l'estrazione di PDF/pagine web/e-book.), creato per l'analisi di documenti multimodali, non solo può convertire accuratamente documenti PDF multimodali tra cui immagini, tabelle, formule, ecc. in un formato Markdown chiaro e facile da analizzare, ma anche rimuovere varie informazioni di interferenza come le pubblicità. Analizza ed estrai rapidamente contenuti formali dalle pagine web

Oltre al sistema di strumenti open source a catena intera sviluppato internamente, InternLM2.5 abbraccia attivamente la comunità, è compatibile con un'ampia gamma di progetti ecologici comunitari e "cattura tutti" i principali progetti open source.

Nel dicembre dello scorso anno, il Laboratorio di intelligenza artificiale di Shanghai ha lanciato il campo pratico Scholar·Puyu Large Model, che ha ricevuto elogi unanimi da parte della comunità. Negli ultimi sei mesi, un totale di 150.000 persone hanno partecipato alla formazione e a più di 600 progetti ecologici. sono stati covati. In occasione del rilascio di InternLM2.5, abbiamo anche annunciato ufficialmente che il campo pratico modello grande Shusheng·Puyu è stato ufficialmente aggiornato al campo pratico modello grande Scholar e aggiungerà gradualmente più corsi Scholar Large Model System ed esercizi pratici a ti porta dall'inizio all'avanzato Non c'è nessun trekking nell'era dei modelli.

La terza fase dello Scholars Large Model Practical Camp sarà lanciata ufficialmente dal 10 luglio al 10 agosto. Nel campo pratico, tutti saranno guidati passo dopo passo per mettere a punto e implementare il modello InternLM2.5 Potenza di calcolo e insegnamento gratuiti gli assistenti ti accompagneranno durante tutto il processo e il certificato ufficiale autorevole arriverà rapidamenteIscrizioneStudialo!

Link di registrazione:Italiano: Italiano: https://www.wjx.cn/vm/PvefmG2.aspx?udsid=831608

Shusheng Puyu potenzia l'innovazione con un open source continuo e di alta qualità, aderisce all'open source e all'uso commerciale gratuito e fornisce modelli e catene di strumenti migliori per scenari applicativi pratici.