2024-07-12

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

Articulus hic comprehense recenset evolutionem functionum activationis in alta doctrina, a priscis Sigmoid et Tanh functionibus, ad late usum ReLU series, ad novas activationis functiones nuper propositas sicut Swish, Mish et GeLU. Intimissima analysis mathematicorum locutionum, proprietatum, commodorum, limitum et applicationum variarum activationum functionum in exemplaribus typicis deducitur. Per analysim systematicam comparativam, hic articulus tractat de consilio principiorum, de signis aestimatione faciendis, de possibilibus futuris evolutionis directionibus functionum activationis, providens theoreticam directionem ad optimam et designandam altae eruditionis exempla.

Munus activationis clavis est componentis in reticulis neuralis, quae notas nonlineas in output neuronum introducit, permittens retia neuralis ad discendum et repraesentandum mappings complexa nonlinea. Sine functione activationis, quantumvis profunde retis neuralis, essentialiter tantum repraesentare potest transmutationes lineares, quae facultatem expressivam retis magnopere circumscribunt.

Celeritate altae doctrinae evolutionis, consilium et selectio functionum activationis magni momenti factae sunt, quae exemplum perficiendi afficiunt. Diversae activationis functiones varias notas habent, ut fluiditatem gradientem, complexionem computationalem, gradum nonlinearietatis, etc. Hae notae directe afficiunt efficientiam disciplinae, concursum celeritatis et finalem observantiam retis neuralis.

Hic articulus intendit ut evolutionem activationis functionum comprehendere comprehendere, proprietates variarum actuum functionum penitus excutere, eorumque applicationem in profundis doctrinarum exemplaribus modernis explorare. Dicemus sequentes aspectus.

Per hanc systematicam recognitionem et analysim, speramus comprehensivam comparationem praebere inquisitoribus et medicis, ut adiuvent eos magis selectos et utentes functiones activationis in alta doctrina exemplarium consiliorum.

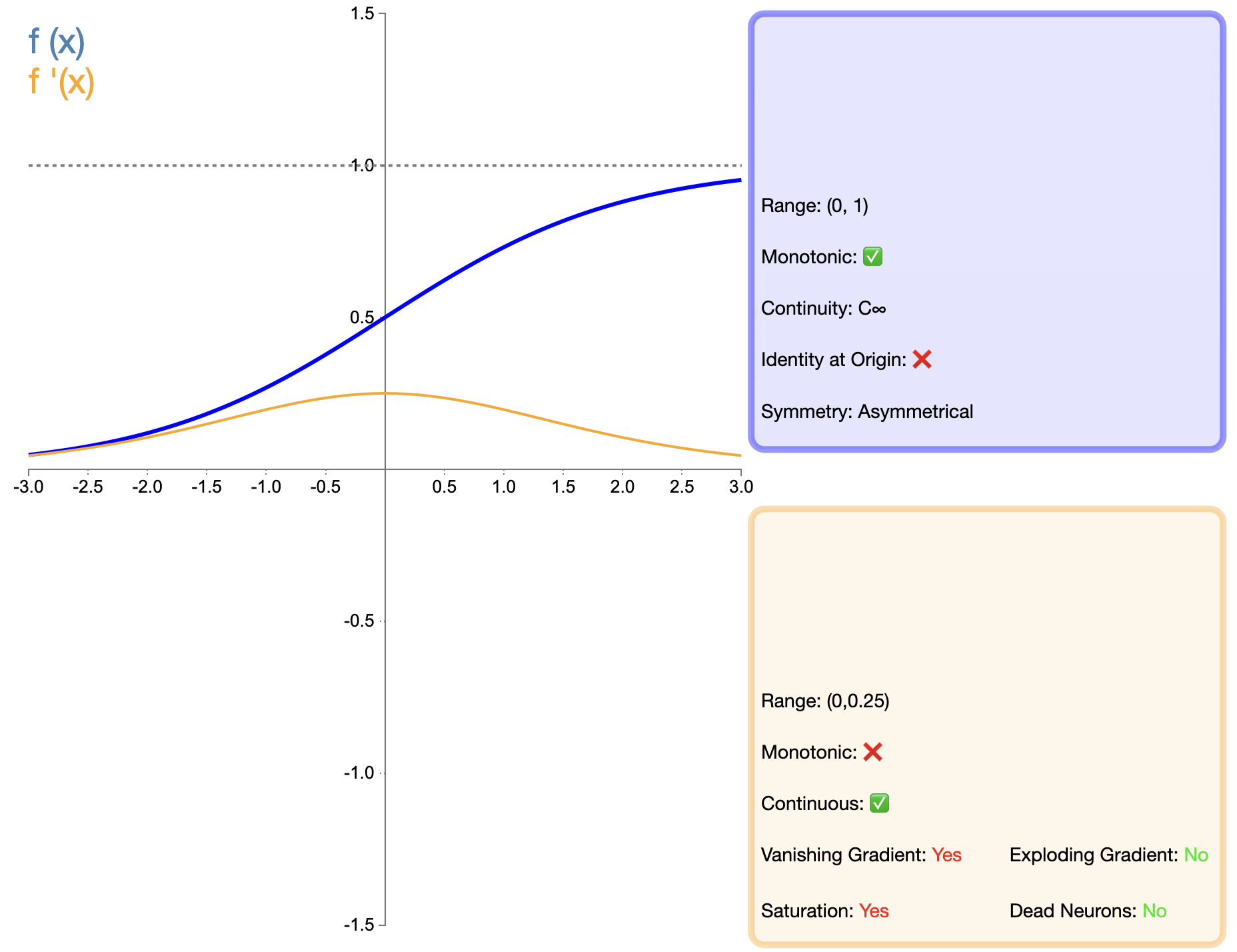

Munus Sigmoidea est una ex primis functionibus activationibus late adhibitis, cuius expressio mathematica est;

σ ( x ) = 1 1 + e − x sigma(x) = frac{1}{1 + e^{-x}}σ(x******************************)=1+e−x******************************1

Comparata cum functionibus sicut ReLU quae postea apparuit, applicatio Sigmoidei in reticulis profundis valde limitata est, praesertim propter problema gradiente evanescente. Tamen in quibusdam muneribus specificis (sicut classificationis binarii), sigmoidea adhuc electio efficax est.

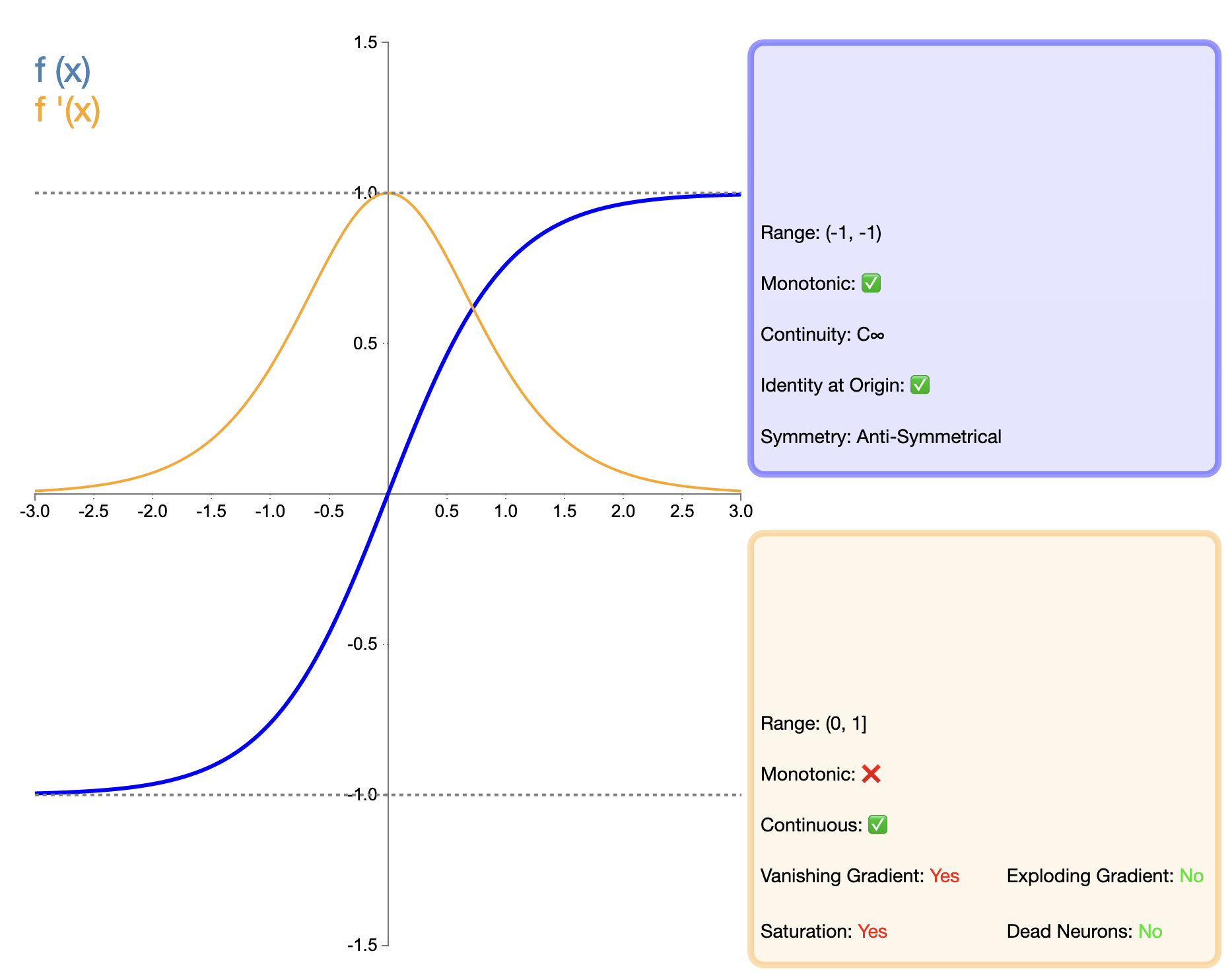

Tanh munus (Tangentem hyperbolicum) haberi potest ut melior versio muneris Sigmoidei, cuius expressio mathematica est;

tanh ( x ) = ex − e xex + e − x tanh(x) = frac{e^x - e^{-x}}{e^x + e^{-x}}tanh(x******************************)=ex******************************+e−x******************************ex******************************−e−x******************************

Munus Tanh melior videri potest versio muneris Sigmoidei. Praecipua emendatio in zephyro-medio e output iacet. Haec factura Tanh melius praestare facit quam Sigmoides in multis adiunctis, praesertim in retiacula alta. Autem, cum functionibus ReLU quae postea apparuit, Tanh adhuc quaestionem de ablatione gradientis habet, quae perficiendi exemplar in retibus profundissimis afficit.

Duae activationis classicae functiones, Sigmoid et Tanh, in primis altae doctrinae temporibus magni fungebantur, eorumque notae ac limitationes etiam progressionem functionum activarum subsequentium promovebant. Etsi in multis missionibus functiones activationis renovatae substituti sunt, tamen suam singularem applicationem valorem in certis muneribus ac structurae retis habent.

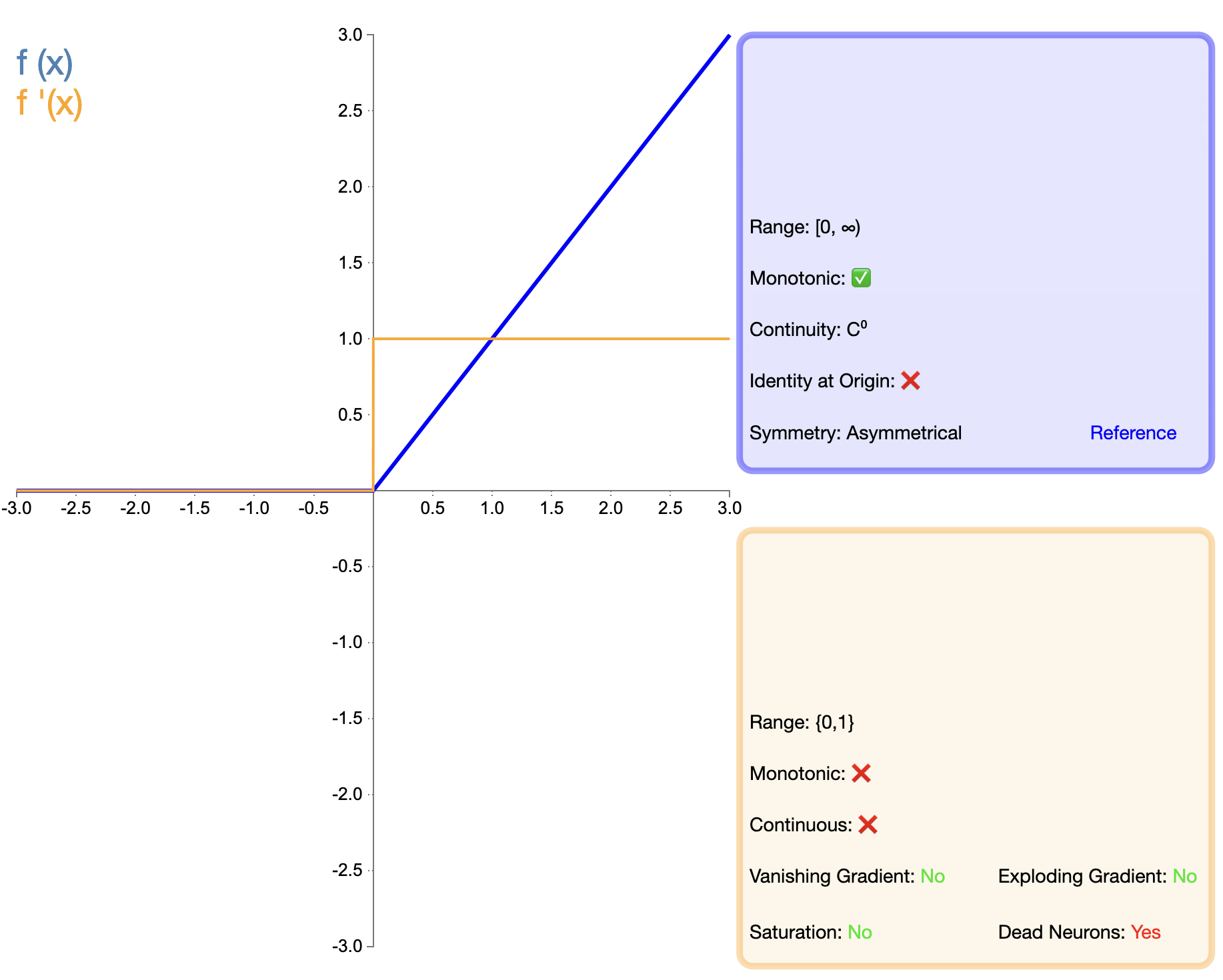

Propositio functionis ReLU est momenti lapis in evolutione functionum activationis. Eius expressio mathematica simplex est;

ReLU ( x ) = max ( 0 , x ) text{ReLU}(x) = max(0, x)ReLU(x******************************)=max(0,x******************************)

Comparatus cum Sigmoide et Tanh, ReLU significantes utilitates in retia profundis ostendit, maxime secundum celeritatem disciplinae et diminutionem graduum ablatione. Tamen problema "ReLU mortuum" investigatores suasit ut varias emendationes proponeret.

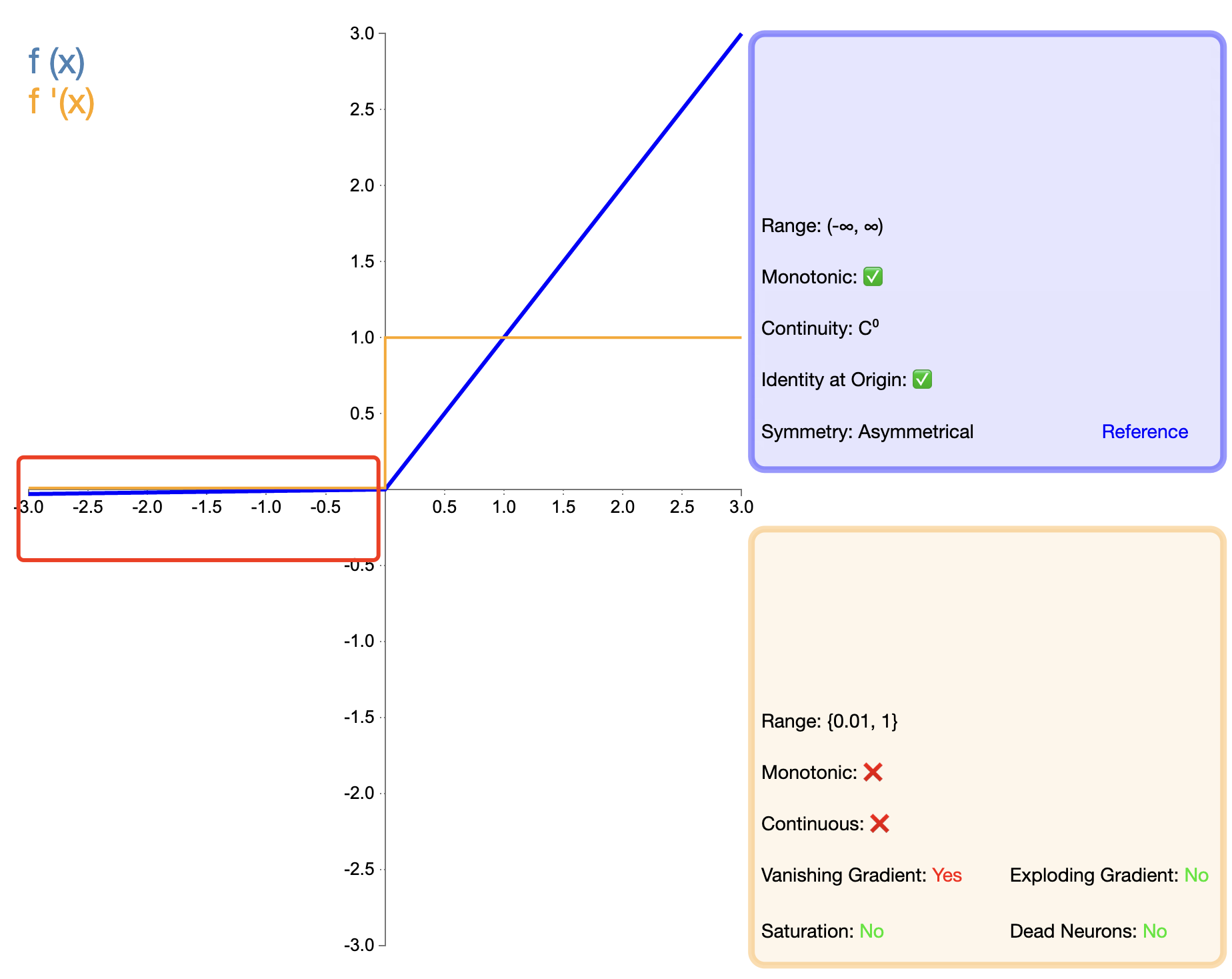

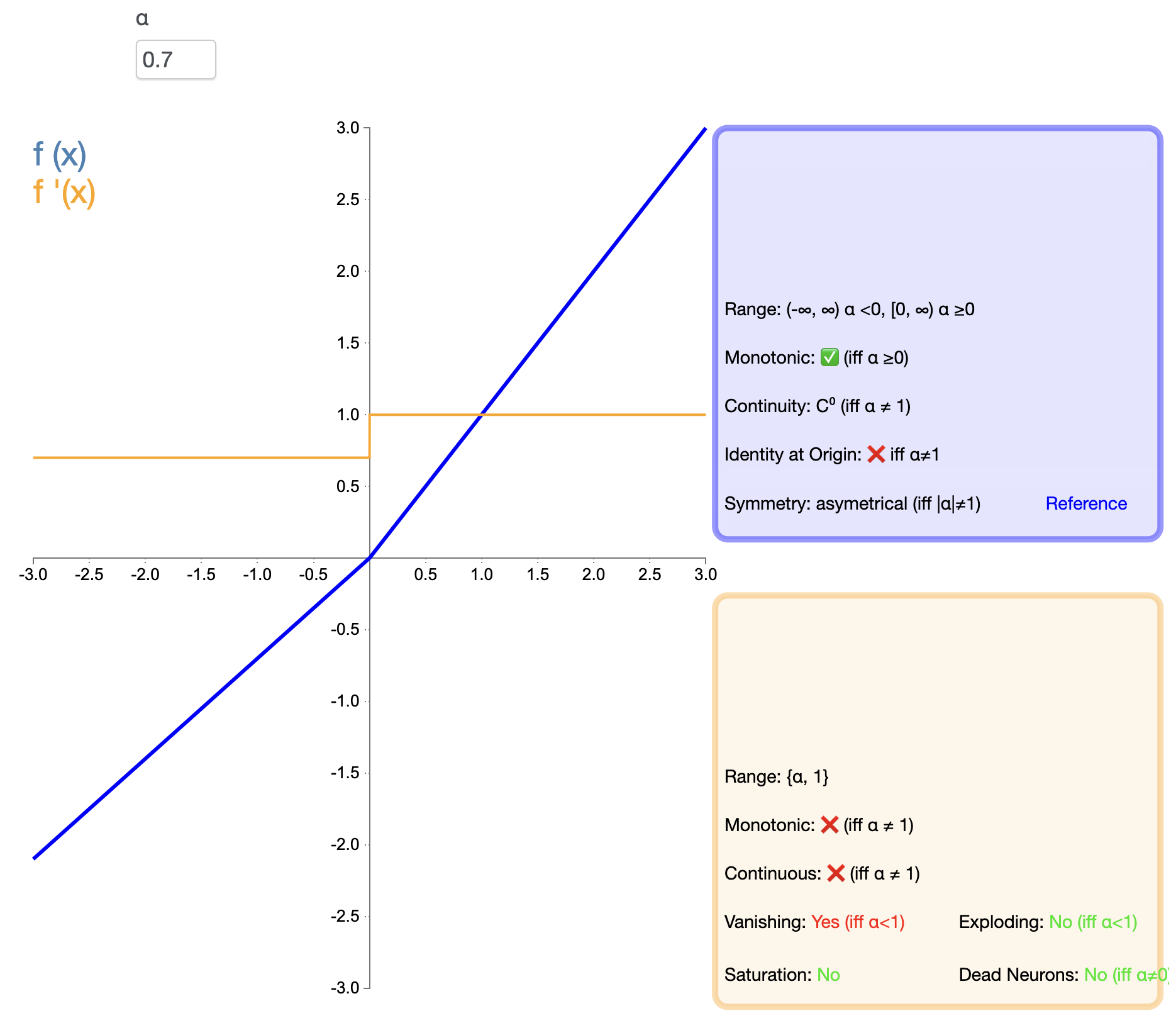

Ad solvendum problema "mortis" de ReLU, Leaky ReLU propositum est:

Leaky ReLU ( x ) = { x , si x > 0 α x , si x ≤ 0 text{Leaky ReLU}(x) ={x******************************,six******************************>0αx******************************,six******************************≤0 Leaky ReLU(x******************************)={

x******************************,αx,six******************************>0six******************************≤0

in, α alphaα parvum positivum constans, plerumque 0.01.

PReLU varians est de Leaky ReLU, ubi scopulus semi-axis negativi est parameter discibilis;

PReLU ( x ) = { x , si x > 0 α x , si x ≤ 0 text{PReLU}(x) ={x******************************,six******************************>0αx******************************,six******************************≤0 PReLU(x******************************)={

x******************************,αx,six******************************>0six******************************≤0

hic " α alphaα parametri sunt per backpropagation didicit.

ELU conatur coniungere commoda ReLU et processus inputum negativorum.

ELU ( x ) = { x , si x > 0 α (ex 1), si x ≤ 0 text{ELU}(x) ={x******************************,six******************************>0α(ex******************************−1),six******************************≤0 ELU(x******************************)=