गहनशिक्षणे सक्रियीकरणकार्यस्य विकासः अनुप्रयोगश्च : समीक्षा

2024-07-12

한어 Русский язык English Français Indonesian Sanskrit 日本語 Deutsch Português Ελληνικά español Italiano Suomalainen Latina

अयं लेखः गहनशिक्षणे सक्रियकरणकार्यस्य विकासस्य व्यापकरूपेण समीक्षां करोति, प्रारम्भिकसिग्मोइड् तथा तान्ह कार्येभ्यः आरभ्य व्यापकरूपेण प्रयुक्ता ReLU श्रृङ्खलापर्यन्तं, सद्यः प्रस्तावितानां नवीनसक्रियताकार्याणां यथा Swish, Mish तथा GeLU इत्यादीनां विशिष्टप्रतिरूपेषु विभिन्नसक्रियीकरणकार्यस्य गणितीयव्यञ्जनानां, लक्षणानाम्, लाभानाम्, सीमानां, अनुप्रयोगानाम् गहनविश्लेषणं क्रियते व्यवस्थित तुलनात्मकविश्लेषणस्य माध्यमेन, अयं लेखः सक्रियीकरणकार्यस्य डिजाइनसिद्धान्तानां, कार्यप्रदर्शनमूल्यांकनमानकानां, सम्भाव्यभविष्यविकासदिशानां च चर्चां करोति, गहनशिक्षणप्रतिमानानाम् अनुकूलनस्य डिजाइनस्य च सैद्धान्तिकमार्गदर्शनं प्रदाति

सक्रियीकरणकार्यं तंत्रिकाजालेषु एकः प्रमुखः घटकः अस्ति, यत् न्यूरॉन्सस्य निर्गमस्थाने अरैखिकलक्षणानाम् परिचयं करोति, येन तंत्रिकाजालस्य जटिल-अरैखिक-मानचित्रणं ज्ञातुं प्रतिनिधित्वं च भवति सक्रियकरणकार्यं विना, तंत्रिकाजालं कियत् अपि गभीरं न भवतु, मूलतः केवलं रेखीयपरिवर्तनानां प्रतिनिधित्वं कर्तुं शक्नोति, यत् जालस्य अभिव्यञ्जकक्षमताम् अतीव सीमितं करोति

क्लासिकसक्रियीकरणकार्यम् : प्रारम्भिकसामान्यतया प्रयुक्तानि सक्रियकरणकार्यं यथा सिग्मोइड् तथा तान्ह इत्यादीनि सन्ति ।

ReLU तथा तस्य रूपान्तराणि : ReLU, Leaky ReLU, PReLU, ELU इत्यादयः सन्ति ।

नवीनसक्रियीकरणकार्यम् : सद्यः प्रस्ताविताः कार्याणि यथा Swish, Mish, GeLU च ।

विशेष-उद्देश्य-सक्रियीकरण-कार्यम् : यथा Softmax, Maxout इत्यादयः ।

सक्रियणकार्यस्य तुलना चयनं च : विभिन्नेषु परिदृश्येषु सक्रियीकरणकार्यचयनरणनीतयः चर्चां कुर्वन्तु।

भविष्यस्य दृष्टिकोणः : सक्रियीकरणकार्यसंशोधनस्य सम्भाव्यविकासदिशानां अन्वेषणं कुर्वन्तु।

अस्याः व्यवस्थितसमीक्षायाः विश्लेषणस्य च माध्यमेन वयं आशास्महे यत् शोधकर्तृभ्यः अभ्यासकर्तृभ्यः च गहनशिक्षणप्रतिरूपनिर्माणे सक्रियकरणकार्यस्य उत्तमरीत्या चयनं उपयोगं च कर्तुं तेषां सहायतार्थं व्यापकं सन्दर्भं प्रदास्यामः।

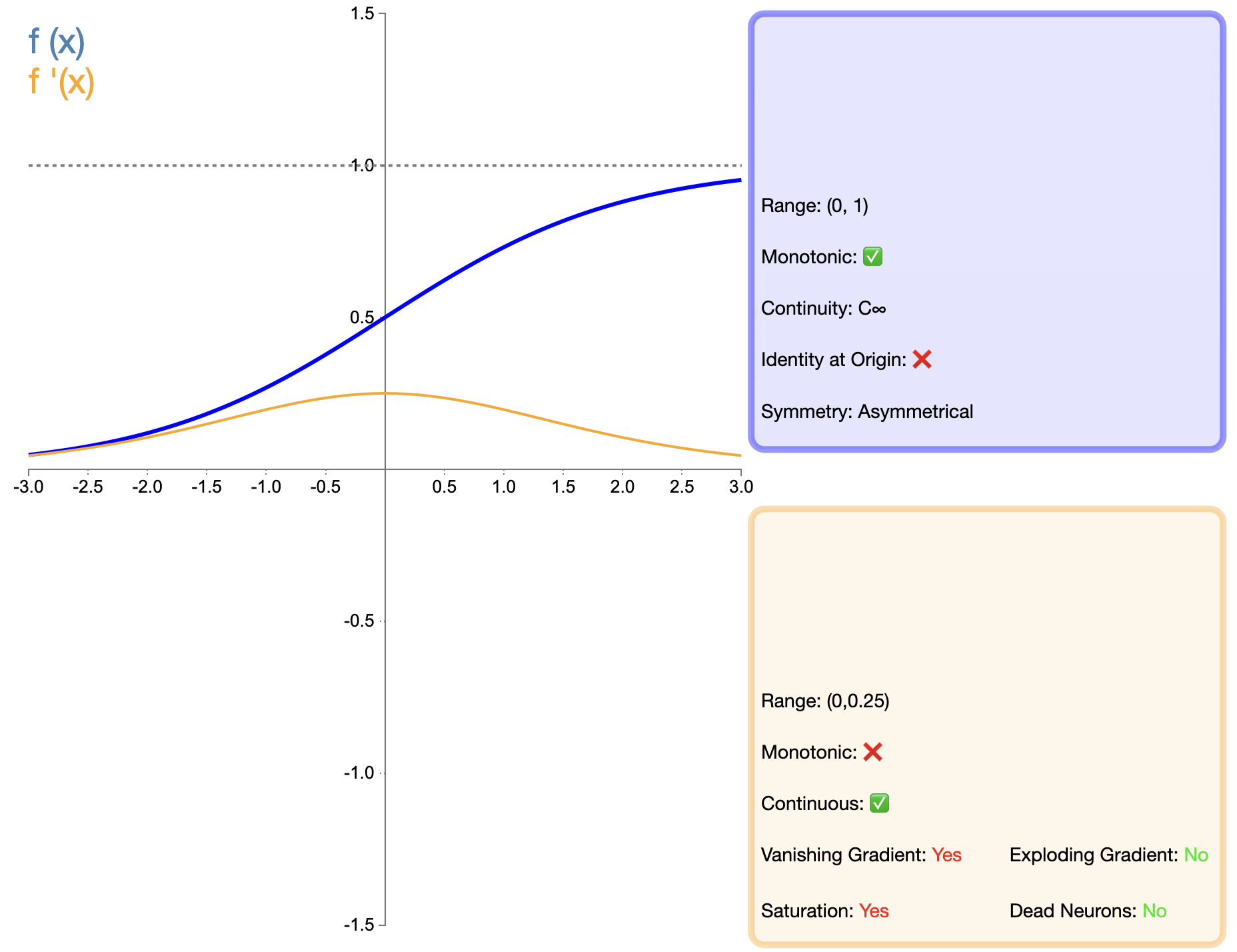

सिग्मोइड् फंक्शन् प्रारम्भिकेषु व्यापकरूपेण प्रयुक्तेषु सक्रियकरणकार्येषु अन्यतमम् अस्ति, तस्य गणितीयव्यञ्जना च अस्ति : σ ( x ) = 1 1 + ई − x सिग्मा(x) = भग्न{1}{1 + ई^{-x}} σ ( x ) = 1 + ङ − x 1

निर्गमपरिधिः सीमाबद्धः अस्ति : सिग्मोइड् फंक्शन् इत्यस्य आउटपुट् रेन्ज् (0, 1) मध्ये भवति, येन संभाव्यतासमस्यानां निवारणाय विशेषतया उपयुक्तं भवति ।स्निग्धं विभेदनीयं च : कार्यं सम्पूर्णे डोमेने सुचारुतया विभेदनीयं च भवति, यत् ढाल-अवरोह-एल्गोरिदमस्य अनुप्रयोगाय लाभप्रदं भवति ।व्याख्यानात्मकम् : निर्गमस्य व्याख्या संभाव्यतारूपेण कर्तुं शक्यते, विशेषतः द्विचक्रीयवर्गीकरणसमस्यानां निर्गमस्तरस्य कृते उपयुक्तम् ।

लुप्तप्रवण ढालसमस्या : यदा निवेशमूल्यं बृहत् लघु वा भवति तदा ढालः शून्यस्य समीपे भवति, यत् गहनजालेषु लुप्तप्रवणसमस्यां जनयितुं शक्नोति ।निर्गम अशून्य केन्द्र : सिग्मोइड् इत्यस्य आउटपुट् सर्वं सकारात्मकं भवति, यत् अग्रिमस्तरस्य न्यूरॉनस्य निवेशं सर्वदा सकारात्मकं भवितुम् अर्हति, येन मॉडलस्य अभिसरणवेगः प्रभावितः भवतिकम्प्यूटेशनल जटिलता : घातीयक्रियाः सम्मिलिताः सन्ति, गणनाजटिलता च तुल्यकालिकरूपेण अधिका भवति ।

प्रारम्भिक उथले तंत्रिकाजाल।

द्विचक्रीयवर्गीकरणसमस्यानां कृते आउटपुट् लेयर ।

परिदृश्यानि यत्र उत्पादनं (0, 1) परिधिपर्यन्तं सीमितं भवितुम् आवश्यकं भवति ।

पश्चात् प्रकटितानां ReLU इत्यादिभिः कार्यैः सह तुलने गहनजालेषु सिग्मोइड् इत्यस्य अनुप्रयोगः बहु सीमितः अभवत्, मुख्यतया तस्य लुप्तप्रवणस्य ढालसमस्यायाः कारणात् परन्तु केषुचित् विशिष्टेषु कार्येषु (यथा द्विचक्रीयवर्गीकरणं) सिग्मोइड् अद्यापि प्रभावी विकल्पः अस्ति ।

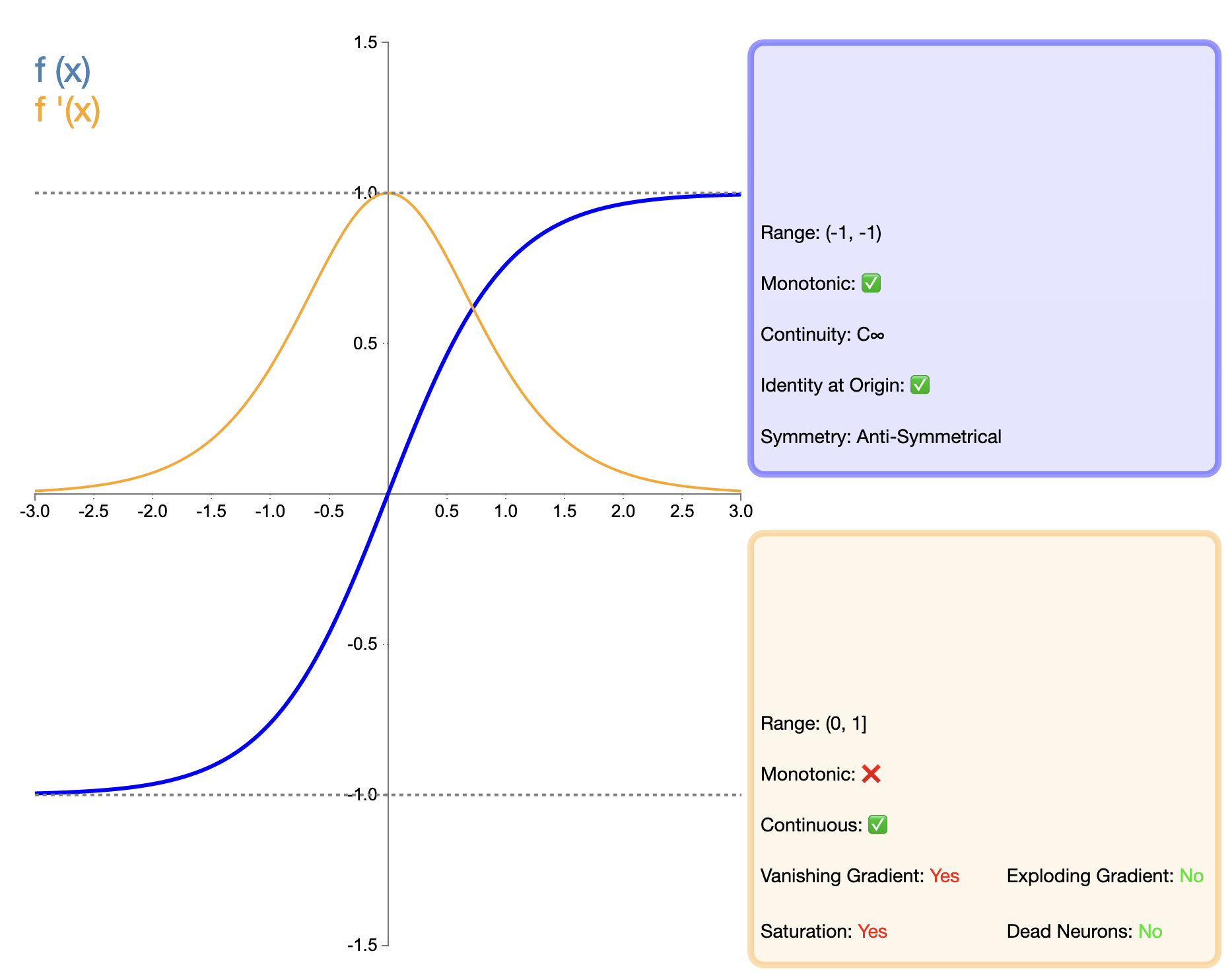

Tanh (अतिपरवलयिक स्पर्शरेखा) फंक्शन् सिग्मोइड् फंक्शन् इत्यस्य उन्नतसंस्करणरूपेण गणयितुं शक्यते, तस्य गणितीयव्यञ्जना च अस्ति : तन्ह ( x ) = ex − e − xex + e − x तन्ह(x) = frac{e^x - e^{-x}}{e^x + e^{-x}} तन्ः ( x ) = ङ x + ङ − x ङ x − ङ − x

शून्य केन्द्रनिर्गमः : Tanh फंक्शन् इत्यस्य आउटपुट् रेन्ज् (-1, 1) मध्ये भवति, यत् सिग्मोइड् इत्यस्य अशून्यकेन्द्रसमस्यायाः समाधानं करोति ।बलिष्ठतरः ढालः : यत्र निवेशः शून्यस्य समीपे भवति तत्र Tanh फंक्शन् इत्यस्य ढालः Sigmoid फंक्शन् इत्यस्मात् बृहत्तरः भवति, यत् शिक्षणस्य गतिं कर्तुं साहाय्यं करोति ।स्निग्धं विभेदनीयं च : सिग्मोइड् इत्यस्य सदृशं तन्हः अपि स्निग्धः, भेद्यः च अस्ति ।

लुप्तप्रवण ढालसमस्या : यद्यपि सिग्मोइड् इत्यस्य अपेक्षया सुधारः कृतः तथापि तन्ह इत्यस्य अद्यापि निवेशमूल्यं बृहत् लघु वा भवति चेत् ढालस्य लुप्ततायाः समस्या अस्ति ।कम्प्यूटेशनल जटिलता : सिग्मोइड् इत्यस्य सदृशं तन्ह इत्यत्र अपि घातीयक्रियाः सन्ति, तस्य गणनाजटिलता अपि उच्चा भवति ।

शून्यकेन्द्रितनिर्गमस्य आवश्यकता भवति इति परिदृश्येषु सिग्मोइड् इत्यस्मात् उत्तमम् ।

प्रायः पुनरावर्तनीय-तंत्रिका-जालम् (RNN) तथा दीर्घ-अल्पकालिक-स्मृति-संजालेषु (LSTM) उपयुज्यते ।

केषुचित् परिदृश्येषु उपयुज्यते यत्र सामान्यीकृतं उत्पादनं महत्त्वपूर्णं भवति।

Tanh फंक्शन् सिग्मोइड् फंक्शन् इत्यस्य उन्नतसंस्करणरूपेण गणयितुं शक्यते मुख्यं सुधारं आउटपुट् इत्यस्य शून्य-केन्द्रीकरणे अस्ति । एतत् विशेषता अनेकेषु परिस्थितिषु विशेषतः गहनजालेषु Tanh इत्यस्य प्रदर्शनं Sigmoid इत्यस्मात् उत्तमं करोति । परन्तु पश्चात् प्रकटितस्य ReLU इत्यादिकार्यस्य तुलने तन्हस्य अद्यापि ढाल-अन्तर्धानस्य समस्या अस्ति, यत् अत्यन्तं गहनेषु जालपुटेषु मॉडलस्य कार्यक्षमतां प्रभावितं कर्तुं शक्नोति

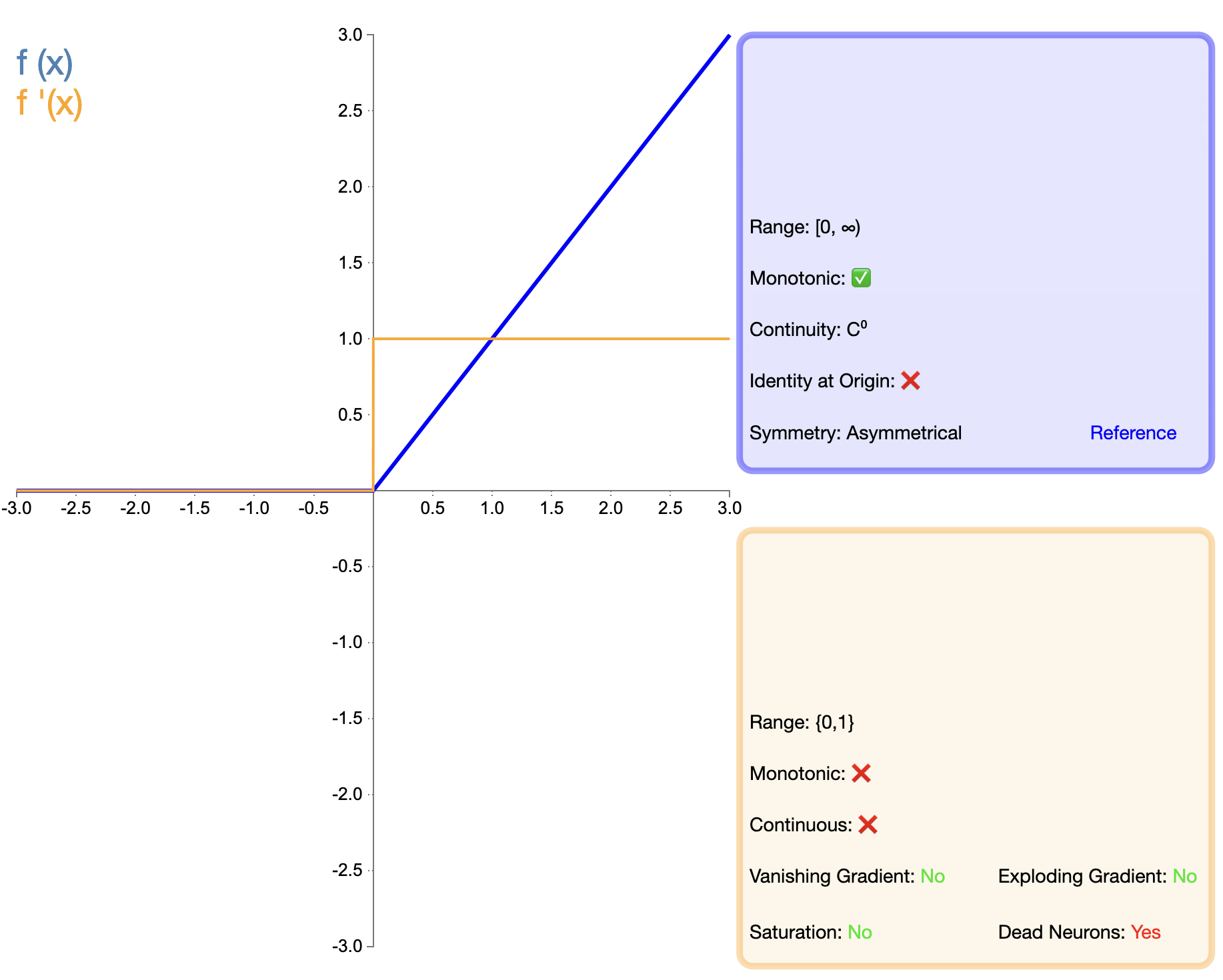

ReLU कार्यस्य प्रस्तावः सक्रियीकरणकार्यस्य विकासे महत्त्वपूर्णः माइलस्टोन् अस्ति । अस्य गणितीयव्यञ्जनम् सरलम् अस्ति : १. ReLU ( x ) = अधिकतम ( 0 , x ) पाठ{ReLU} (x) = अधिकतम (0, x) . ReLU ( x ) = अधिकतमम् ( 0 , x )

गणना सरलम् अस्ति : ReLU इत्यस्य गणनाजटिलता सिग्मोइड् तथा तान्ह इत्येतयोः अपेक्षया बहु न्यूना भवति, यत् संजालप्रशिक्षणस्य त्वरिततायै लाभप्रदम् अस्ति ।शमनप्रवणता अन्तर्धानं भवति : सकारात्मकनिवेशस्य कृते ReLU इत्यस्य ढालः सर्वदा 1 भवति, यत् गहनजालेषु लुप्तप्रवणसमस्यां प्रभावीरूपेण न्यूनीकरोति ।विरल सक्रियता : ReLU न्यूरॉन्सस्य भागस्य उत्पादनं 0 कर्तुं शक्नोति, येन जालस्य विरलव्यञ्जनं भवति, यत् कतिपयेषु कार्येषु लाभप्रदं भवति ।जैविक व्याख्या : ReLU इत्यस्य एकपक्षीयनिरोधात्मकगुणाः जैविकन्यूरोन्-व्यवहारस्य सदृशाः सन्ति ।

"मृत ReLU" समस्या : यदा निवेशः ऋणात्मकः भवति तदा ढालः शून्यः भवति, यस्य परिणामेण न्यूरॉनस्य स्थायी निष्क्रियता भवितुम् अर्हति ।अशून्य केन्द्रनिर्गम : ReLU इत्यस्य आउटपुट् सर्वे अ-नकारात्मकाः मूल्याः सन्ति, ये अग्रिम-स्तरस्य शिक्षण-प्रक्रियाम् प्रभावितं कर्तुं शक्नुवन्ति ।

गहनेषु कन्वोल्यूशनल् न्यूरल नेटवर्क् (यथा ResNet, VGG इत्यादिषु) व्यापकरूपेण उपयुज्यते ।

अधिकांश फीडफोरवर्ड न्यूरल नेटवर्क् कृते उपयुक्तम्।

सिग्मोइड् तथा तान्ह इत्येतयोः तुलने ReLU गहनजालेषु महत्त्वपूर्णं लाभं दर्शयति, मुख्यतया प्रशिक्षणवेगस्य दृष्ट्या तथा ढालस्य अन्तर्धानस्य न्यूनीकरणस्य दृष्ट्या परन्तु "मृत ReLU" समस्यायाः कारणात् शोधकर्तारः विविधानि उन्नतसंस्करणाः प्रस्तावितुं प्रेरिताः सन्ति ।

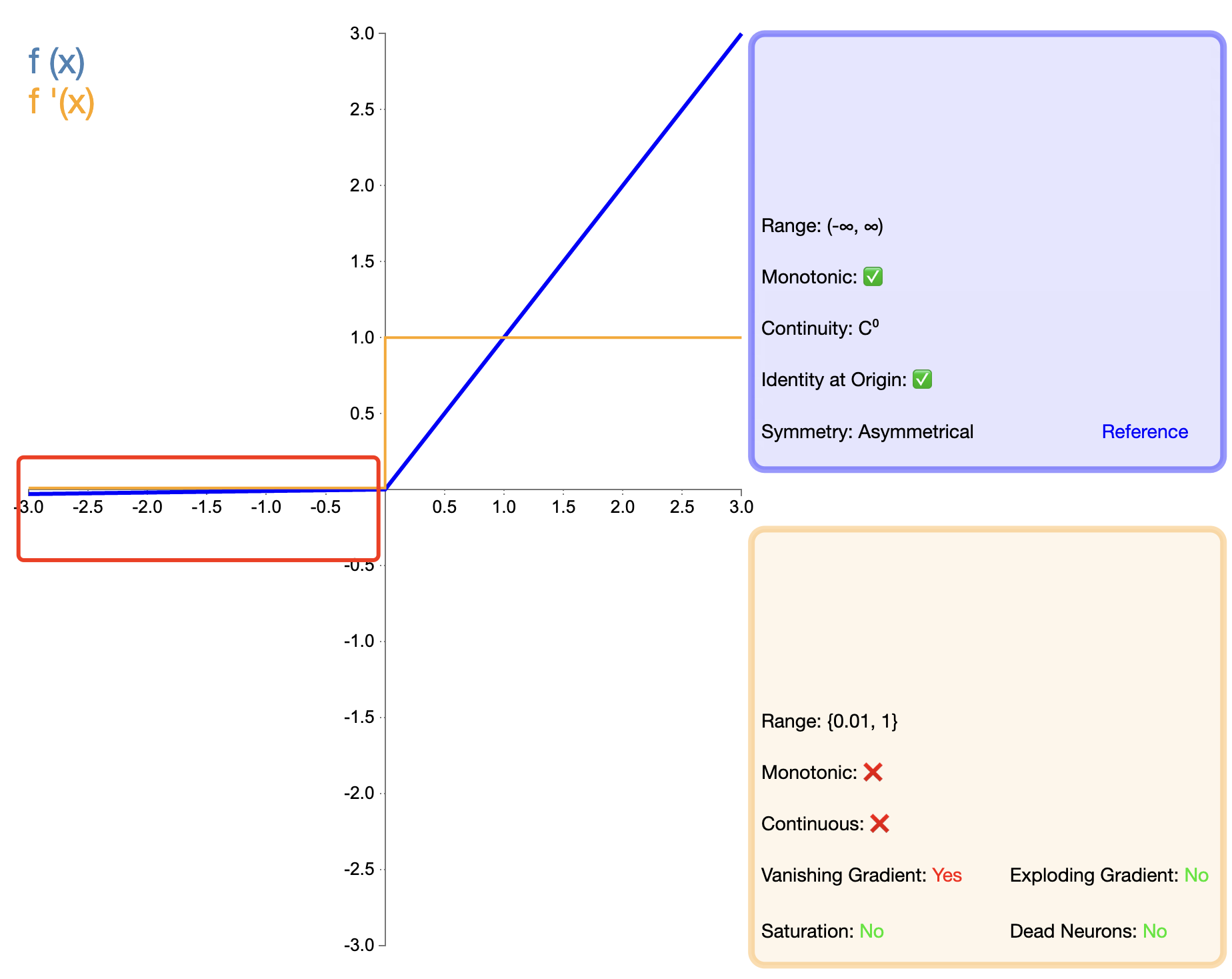

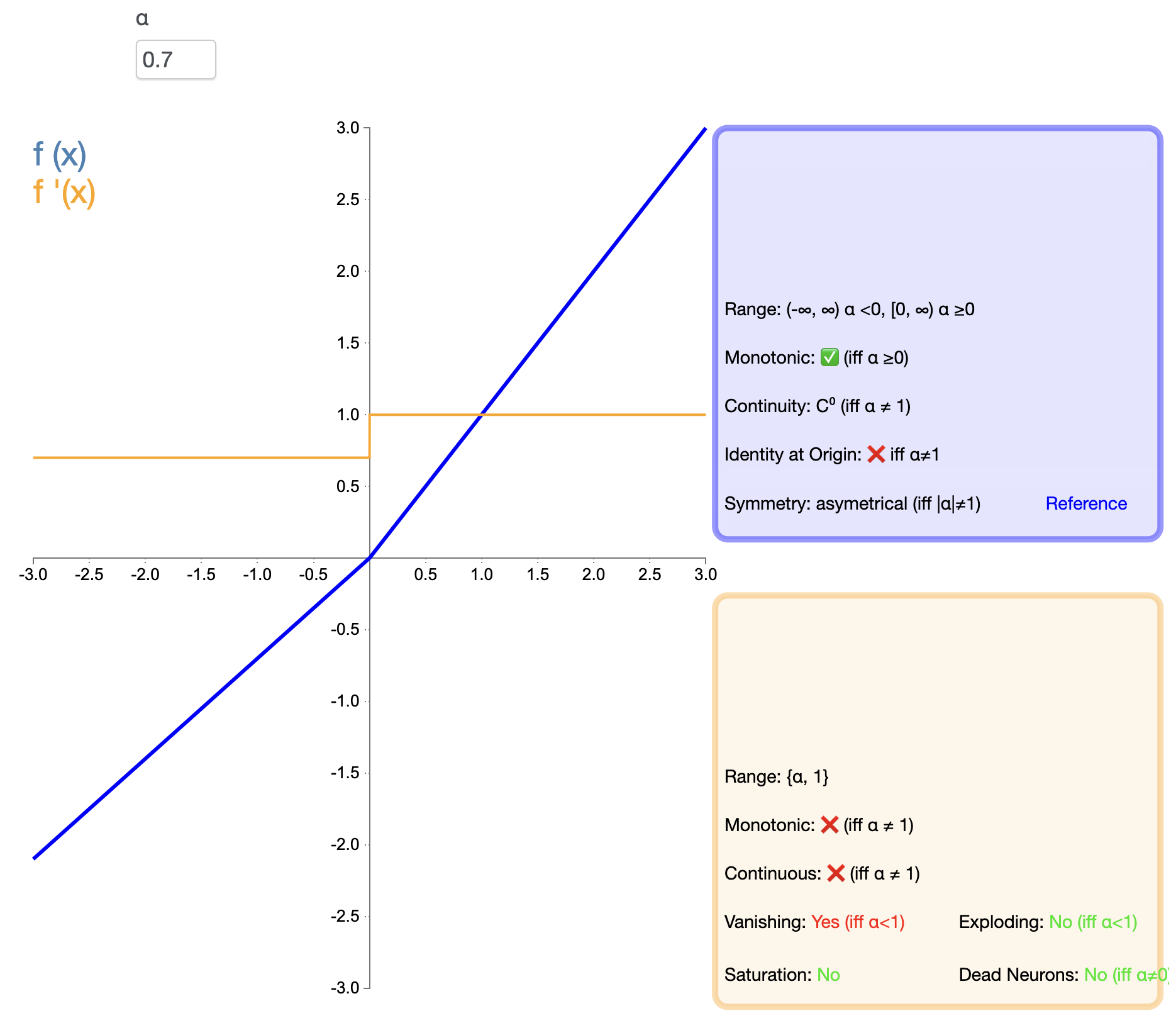

ReLU इत्यस्य "मृत्यु" समस्यायाः समाधानार्थं Leaky ReLU इति प्रस्तावितं यत् - लीकी ReLU ( x ) = { x , यदि x > 0 α x , यदि x ≤ 0 पाठ{लीकी ReLU} (x) ={ x , यदि x > 0 α x , यदि x ≤ 0 लीकी ReLU ( x ) = {

x , αx , यदि x > 0 यदि x ≤ 0 α अल्फा α

"मृत ReLU" समस्यायाः उपशमनम् : अद्यापि न्यूरॉन्सस्य पूर्णतया निष्क्रियतां परिहरितुं निवेशः नकारात्मकः भवति चेत् लघु ढालं धारयन्तु।ReLU इत्यस्य लाभं स्थापयन्तु : सकारात्मक अर्धअक्षे रेखीयतां निर्वाहयन्तु, गणना सरलं भवति, तथा च ढालस्य अन्तर्धानं न्यूनीकर्तुं साहाय्यं करोति।

अतिपैरामीटर् परिचयः : α अल्फा α अशून्य केन्द्रनिर्गम : ReLU इत्यस्य सदृशं अद्यापि उत्पादनं शून्यकेन्द्रितं नास्ति ।

यत्र ReLU दुर्बलं कार्यं करोति तेषु परिदृश्येषु विकल्परूपेण।

यत्र काश्चन नकारात्मकमूल्यसूचनाः धारयितुं आवश्यकाः सन्ति तत्र कार्येषु उपयुज्यते ।

PReLU Leaky ReLU इत्यस्य एकः प्रकारः अस्ति, यत्र ऋणात्मकस्य अर्ध-अक्षस्य प्रवणता एकः शिक्षितुं योग्यः पैरामीटर् अस्ति: PReLU ( x ) = { x , यदि x > 0 α x , यदि x ≤ 0 पाठ{PReLU}(x) ={ x , यदि x > 0 α x , यदि x ≤ 0 PReLU ( x ) = {

x , αx , यदि x > 0 यदि x ≤ 0 α अल्फा α

अनुकूली शिक्षण : दत्तांशस्य आधारेण स्वयमेव सर्वाधिकं उपयुक्तं नकारात्मकं अर्ध-अक्ष-प्रवणं ज्ञातुं शक्यते ।कार्यप्रदर्शनक्षमता : केषुचित् कार्येषु PReLU ReLU तथा Leaky ReLU इत्येतयोः अपेक्षया उत्तमं प्रदर्शनं प्राप्तुं शक्नोति ।

आदर्शस्य जटिलतां वर्धयन्तु : अतिरिक्तशिक्षणीयमापदण्डानां परिचयः प्रतिरूपस्य जटिलतां वर्धयति।सम्भाव्य अतिफिटिंग : केषुचित् सन्दर्भेषु, विशेषतः लघुदत्तांशसमूहेषु अतिफिटिङ्ग् भवितुं शक्नोति ।

बृहत्-परिमाणस्य दत्तांशसमूहेषु गहनशिक्षणकार्यम्।

अनुकूलसक्रियीकरणकार्यस्य आवश्यकतां येषां परिदृश्यानां आवश्यकता भवति।

ELU ReLU इत्यस्य लाभं नकारात्मकनिवेशानां संसाधनं च संयोजयितुं प्रयतते तस्य गणितीयव्यञ्जना अस्ति : ELU ( x ) = { x , यदि x > 0 α ( ex − 1 ) , यदि x ≤ 0 पाठ{ELU}(x) ={ x , यदि x > 0 α ( ङ x − 1 ) , यदि x ≤ 0 एलु ( x ) =